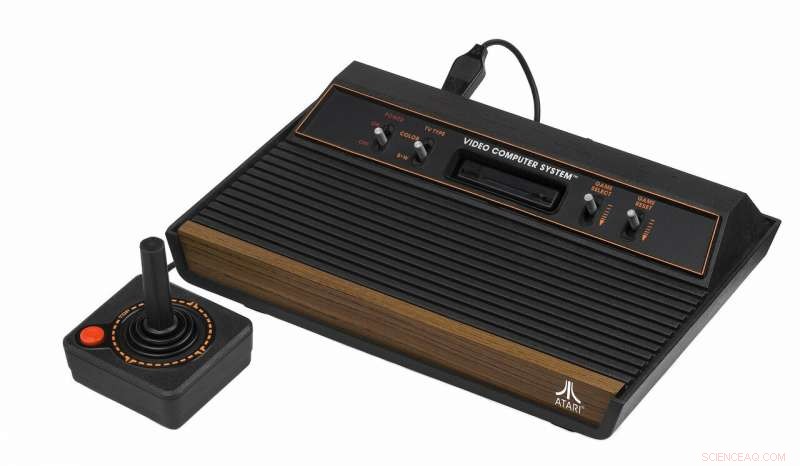

Crédit :CC0 Domaine public

Une nouvelle génération d'algorithmes a maîtrisé les jeux vidéo Atari 10 fois plus rapidement que l'IA de pointe, avec une approche révolutionnaire de la résolution de problèmes.

Concevoir une IA capable de négocier les problèmes de planification, surtout ceux où les récompenses ne sont pas immédiatement évidentes, est l'un des défis de recherche les plus importants pour faire avancer le domaine.

Une célèbre étude de 2015 a montré que Google DeepMind AI a appris à jouer à des jeux vidéo Atari comme Video Pinball au niveau humain, mais notoirement échoué à apprendre un chemin vers la première clé dans le jeu vidéo Montezuma's Revenge des années 1980 en raison de la complexité du jeu.

Dans la nouvelle méthode développée à l'Université RMIT de Melbourne, Australie, les ordinateurs configurés pour jouer de manière autonome à Montezuma's Revenge ont appris de leurs erreurs et identifié des sous-objectifs 10 fois plus rapidement que Google DeepMind pour terminer le jeu.

Le professeur agrégé Fabio Zambetta de l'Université RMIT dévoile la nouvelle approche ce vendredi lors de la 33e conférence AAAI sur l'intelligence artificielle aux États-Unis.

La méthode, développé en collaboration avec le professeur John Thangarajah et Michael Dann du RMIT, combine l'apprentissage par renforcement « de la carotte et du bâton » avec une approche de motivation intrinsèque qui récompense l'IA pour sa curiosité et son exploration de son environnement.

"Une IA vraiment intelligente doit être capable d'apprendre à effectuer des tâches de manière autonome dans des environnements ambigus, " dit Zambetta.

"Nous avons montré que le bon type d'algorithmes peut améliorer les résultats en utilisant une approche plus intelligente plutôt que de forcer purement et simplement un problème de bout en bout sur des ordinateurs très puissants.

"Nos résultats montrent à quel point nous nous rapprochons de l'IA autonome et pourraient être une piste d'enquête clé si nous voulons continuer à faire des progrès substantiels dans ce domaine."

La méthode de Zambetta récompense le système pour l'exploration autonome de sous-objectifs utiles tels que « monter cette échelle » ou « sauter par-dessus cette fosse », ce qui peut ne pas être évident pour un ordinateur, dans le cadre d'une mission plus vaste.

D'autres systèmes de pointe ont nécessité une intervention humaine pour identifier ces sous-objectifs ou bien ont décidé ce qu'il fallait faire ensuite au hasard.

"Non seulement nos algorithmes ont identifié de manière autonome les tâches pertinentes environ 10 fois plus rapidement que Google DeepMind en jouant à Montezuma's Revenge, ils ont également présenté un comportement relativement semblable à celui de l'homme ce faisant, " dit Zambetta.

"Par exemple, avant de pouvoir accéder au deuxième écran du jeu, vous devez identifier des sous-tâches telles que monter des échelles, sauter par-dessus un ennemi et finalement ramasser une clé, à peu près dans cet ordre.

"Cela finirait par se produire de manière aléatoire après une énorme quantité de temps, mais se produire si naturellement dans nos tests montre une sorte d'intention.

"Cela fait de nous le premier agent entièrement autonome axé sur les sous-objectifs à être vraiment compétitif avec les agents de pointe sur ces jeux."

Zambetta a déclaré que le système fonctionnerait en dehors des jeux vidéo dans un large éventail de tâches, lorsqu'il est fourni avec des entrées visuelles brutes.

"Créer un algorithme capable de compléter les jeux vidéo peut sembler trivial, mais le fait que nous en ayons conçu un qui puisse faire face à l'ambiguïté tout en choisissant parmi un nombre arbitraire d'actions possibles est une avancée critique.

"Cela signifie que, avec le temps, cette technologie sera précieuse pour atteindre des objectifs dans le monde réel, que ce soit dans des voitures autonomes ou en tant qu'assistants robotiques utiles avec reconnaissance du langage naturel, " il dit.

Deriving Subgoals Autonomously to Accelerate Learning in Sparse Reward Domains (ci-joint) sera présenté à la 33e conférence AAAI sur l'intelligence artificielle à Honolulu, Hawaï le 1er février 2019.