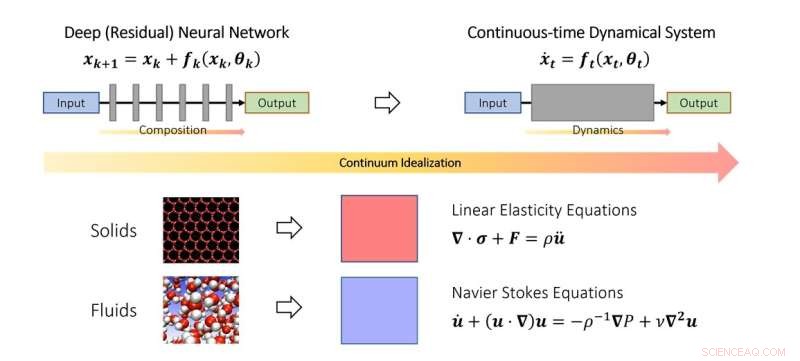

Le point de vue continu de l'apprentissage en profondeur. De la même manière que les scientifiques étudient la mécanique des solides et des fluides dans la limite du continuum, on peut également idéaliser les réseaux de neurones profonds comme une discrétisation d'un système dynamique continu. Dans le schéma, le paramètre de temps fictif représente un analogue continu de couches et la dynamique modélise l'empilement des couches. Crédit :Qianxiao Li

Les mathématiciens de NUS ont développé un nouveau cadre théorique basé sur des systèmes dynamiques pour comprendre quand et comment un réseau neuronal profond peut apprendre des relations arbitraires.

Malgré un succès généralisé dans la pratique, comprendre les principes théoriques de l'apprentissage en profondeur reste une tâche difficile. L'une des questions les plus fondamentales est la suivante :les réseaux de neurones profonds peuvent-ils apprendre des relations entrées-sorties arbitraires (en mathématiques, on les appelle des fonctions), et la manière dont ils y parviennent diffère-t-elle des méthodologies traditionnelles ?

Pour comprendre cette question, il est nécessaire de réfléchir à ce qui est exactement nouveau dans les réseaux de neurones profonds par rapport aux paradigmes traditionnels d'approximation de fonctions. Par exemple, la série de Fourier classique se rapproche des fonctions compliquées comme une somme pondérée de fonctions plus simples, telles que les sinus et les cosinus. Les réseaux de neurones profonds fonctionnent tout à fait différemment. Au lieu de sommes pondérées, ils construisent des fonctions complexes à partir de l'empilement répété de fonctions simples (couches). Ceci est également connu sous le nom de composition de fonctions en mathématiques. La question clé est de savoir comment des fonctions compliquées peuvent être construites à partir de fonctions simples en les empilant. Il s'avère qu'il s'agit d'un problème assez nouveau dans la branche des mathématiques connue sous le nom de théorie de l'approximation.

Dans cette étude publiée dans le Journal of the European Mathematical Society , le professeur adjoint Qianxiao LI du Département de mathématiques de l'Université nationale de Singapour et ses collaborateurs ont développé une nouvelle théorie des capacités d'approximation de la composition des fonctions. Une observation intéressante est que si la composition de la fonction est difficile à analyser en pratique en raison de sa structure discrète et non linéaire, ce n'est pas la première fois que de tels problèmes se posent.

Dans l'étude du mouvement des solides et des fluides, ils sont souvent idéalisés comme un continuum de particules, satisfaisant certaines équations continues (équations aux dérivées ordinaires ou partielles). Cela permet de contourner la difficulté de modéliser de tels systèmes au niveau atomique discret. Au lieu de cela, des équations du continuum qui modélisent leur comportement au niveau macroscopique ont été dérivées.

L'idée clé de l'étude est que ce concept peut être étendu aux réseaux de neurones profonds, en idéalisant la structure en couches comme un système dynamique continu. Cela relie l'apprentissage en profondeur à la branche des mathématiques connue sous le nom de systèmes dynamiques. De telles connexions permettent le développement de nouveaux outils pour comprendre les mathématiques de l'apprentissage en profondeur, y compris une caractérisation générale du moment où il peut effectivement approximer des relations arbitraires.

Le professeur Li a déclaré :« Le point de vue des systèmes dynamiques de l'apprentissage en profondeur offre un cadre mathématique prometteur qui met en évidence les aspects distinctifs des réseaux de neurones profonds par rapport aux paradigmes traditionnels. Cela apporte de nouveaux problèmes mathématiques passionnants sur l'interface des systèmes dynamiques, la théorie de l'approximation et l'apprentissage automatique. "

"Un domaine prometteur de développement futur consiste à étendre ce cadre pour étudier d'autres aspects des réseaux de neurones profonds, tels que la façon de les former efficacement et de s'assurer qu'ils fonctionnent mieux sur des ensembles de données invisibles", a ajouté le professeur Li. Le réseau de neurones rationnel fait progresser l'apprentissage des équations de différenciation partielle