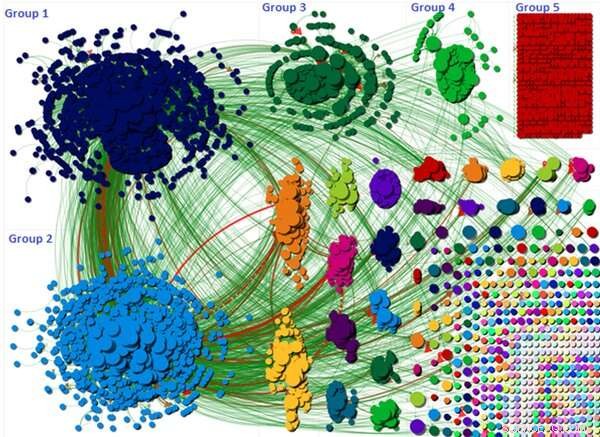

Le graphique montre comment la discussion sur la théorie du complot a été divisée en différents groupes. Crédit :Wasim Ahmed, Auteur fourni

Il est largement admis que les théories du complot sur les réseaux sociaux sont motivées par des « bots » malveillants et anonymes mis en place par des tiers obscurs. Mais ma nouvelle recherche – qui a examiné une théorie du complot COVID-19 extrêmement réussie – a montré que les comptes rendus des citoyens ordinaires peuvent être tout aussi coupables lorsqu'il s'agit de répandre des mensonges dangereux et de la désinformation.

La pandémie a alimenté au moins dix théories du complot cette année. Certains ont lié la propagation de la maladie au réseau 5G, menant au vandalisme des antennes-relais. D'autres ont fait valoir que COVID-19 était une arme biologique. La recherche a montré que les théories du complot pourraient contribuer à ce que les gens ignorent les règles de distanciation sociale.

Le mouvement #FilmYourHospital était l'une de ces théories. Il a encouragé les gens à enregistrer des vidéos d'eux-mêmes dans des images apparemment vides, ou moins de monde, hôpitaux pour prouver que la pandémie est un canular. De nombreuses vidéos montrant des couloirs et des salles vides ont été partagées.

Notre recherche visait à identifier les moteurs du complot et à examiner si les comptes qui l'ont propulsé en avril 2020 étaient des bots ou de vraies personnes.

Échelle du complot

Le complot 5G en a attiré 6, 556 utilisateurs de Twitter en une seule semaine. Les #FilmYourHospital le complot était bien plus important que la 5G, avec un total de 22, 785 tweets envoyés sur une période de sept jours par 11, 333 utilisateurs. Il bénéficiait également d'un fort soutien international.

La visualisation ci-dessus montre chaque utilisateur de Twitter comme un petit cercle et la discussion globale est regroupée en un certain nombre de groupes différents. Ces groupes sont formés en fonction de la façon dont les utilisateurs se mentionnaient et se retweetaient les uns les autres.

La visualisation met en évidence comment les trois plus grands groupes étaient responsables de la propagation du complot le plus loin. Par exemple, la discussion dans les groupes un et deux était centrée sur un seul tweet qui a été fortement re-tweeté. Le tweet suggérait que le public était induit en erreur et que les hôpitaux n'étaient pas occupés ou débordés, comme l'avaient rapporté les médias grand public. Le tweet a ensuite demandé à d'autres utilisateurs de filmer leurs hôpitaux en utilisant le hashtag afin qu'il puisse devenir un sujet tendance. Le graphique montre la portée et la taille de ces groupes.

Où sont les robots ?

Nous avons utilisé Botometer pour détecter les robots qui s'appuient sur un algorithme d'apprentissage automatique. L'outil calcule un score où les scores faibles indiquent un comportement humain et un score élevé indique un bot. Botometer fonctionne en extrayant diverses fonctionnalités d'un compte telles que son profil, copains, réseau social, modèles d'activité temporelle, langage et sentiment. Notre étude a pris un échantillon représentatif systématique de 10 % d'utilisateurs pour parcourir Botometer.

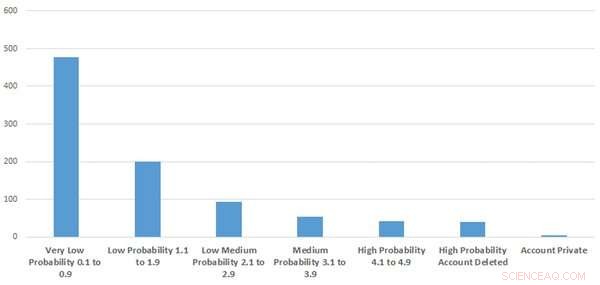

La figure montre combien de comptes étaient suspects ou ressemblaient à des robots. Crédit :Wasim Ahmed, Auteur fourni

Nos résultats ont indiqué que le taux de comptes automatisés était probablement faible. Nous avons utilisé les scores bruts de Botometer pour attacher une étiquette de probabilité indiquant si le compte était susceptible d'être un bot. Celles-ci allaient de très faibles, meugler, probabilité faible-moyenne et élevée.

Au mieux, seuls 9,2 % de l'échantillon que nous avons examiné ressemblaient à des comportements de compte ou à des robots hautement suspects. Cela signifie que plus de 90 % des comptes que nous avons examinés étaient probablement authentiques.

De façon intéressante, nous avons également constaté que les comptes supprimés et les comptes automatisés contenaient des mots-clés tels que « Trump » et « Make America Great Again » dans leur biographie utilisateur. À peu près à la même époque, le président Donald Trump était en désaccord avec les conseillers scientifiques sur le moment de lever les règles de verrouillage.

D'où vient-il?

Lorsque nous avons examiné les utilisateurs les plus influents connectés au hashtag, nous avons constaté que la théorie du complot était conduite par des politiciens conservateurs influents ainsi que par des militants politiques d'extrême droite. Les chercheurs ont noté comment l'extrême droite a exploité la pandémie. Par exemple, certains ont mis en place des chaînes sur Telegram, un service de messagerie instantanée basé sur le cloud, pour discuter de COVID-19 et ont amplifié la désinformation.

Mais une fois que la théorie du complot a commencé à attirer l'attention, elle a été soutenue par des citoyens ordinaires. La campagne semblait également être soutenue et conduite par des comptes Twitter pro-Trump et nos recherches ont révélé que certains comptes qui se comportaient comme des "bots" et des comptes supprimés avaient tendance à être pro-Trump. Il est important de noter que tous les comptes qui se comportent comme des bots ne sont pas des bots, car il pourrait y avoir des utilisateurs très actifs qui pourraient recevoir un score élevé. Et, inversement, tous les bots ne sont pas nuisibles car certains ont été configurés à des fins légitimes.

Les utilisateurs de Twitter ont fréquemment partagé des vidéos YouTube à l'appui de la théorie et YouTube était une source influente.

Peuvent-ils être arrêtés ?

Les organisations de médias sociaux peuvent surveiller les comptes et contenus suspects et s'ils violent les conditions d'utilisation, le contenu doit être supprimé rapidement. Twitter a expérimenté l'ajout d'étiquettes d'avertissement sur les tweets. Cela a d'abord échoué parce que Twitter a accidentellement mal étiqueté certains tweets, ce qui aurait pu, par inadvertance, pousser plus loin les complots. Mais s'ils parviennent à mettre au point une meilleure technique d'étiquetage, cela pourrait être une méthode efficace.

Les complots peuvent également être contrés en fournissant des informations fiables, délivrés par les autorités de santé publique ainsi que par les « influenceurs » de la culture populaire. Par exemple, Conseil municipal d'Oldham au Royaume-Uni, a fait appel à l'acteur James Buckley, célèbre pour son rôle de Jay dans la sitcom E4 The Inbetweeners, pour diffuser des messages de santé publique.

Et d'autres recherches soulignent qu'expliquer des arguments erronés et décrire un consensus scientifique peut aider à réduire l'effet de la désinformation. Malheureusement, quelles que soient les procédures et étapes mises en place, il y aura toujours des gens qui croiront aux complots. La responsabilité doit incomber aux plateformes de s'assurer que ces théories ne se propagent pas si facilement.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.