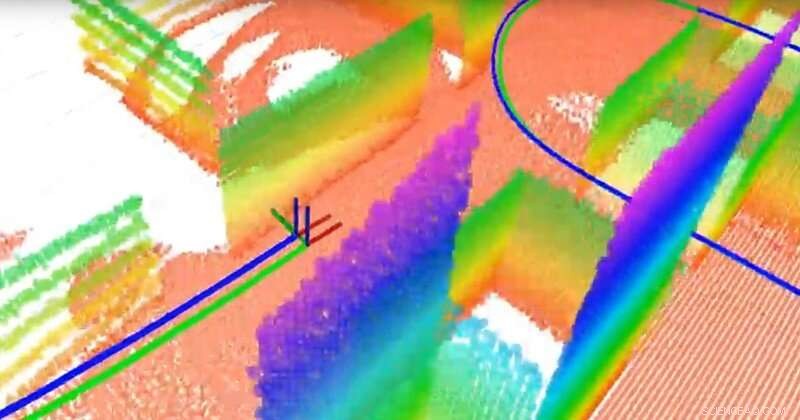

L'équipe a construit une carte plane en 3D à l'aide d'un LiDAR en 3D et d'un capteur inertiel. Le LiDAR est comme un radar mais utilise la lumière au lieu des ondes radio. Les points de couleurs différentes sont les différents plans (qui servent de repères pour la navigation), la ligne verte est la vraie trajectoire et la ligne bleue est la trajectoire estimée calculée par l'algorithme de localisation et de cartographie simultanées (SLAM) de l'équipe. Crédit :Université du Delaware

Les scientifiques du monde entier se lancent dans la course pour développer des véhicules autonomes, mais quelques éléments essentiels restent à perfectionner. L'un est la localisation, c'est-à-dire la capacité du véhicule à déterminer sa position et son mouvement. Une autre est la cartographie, c'est-à-dire la capacité des véhicules à modéliser leur environnement afin de pouvoir transporter les passagers en toute sécurité au bon endroit.

La question est :comment donner à un véhicule un sens de l'orientation ? Alors que les appareils de positionnement global par satellite (GPS) peuvent aider, ils ne sont pas disponibles ou fiables dans tous les contextes. Au lieu, de nombreux experts étudient la localisation et la cartographie simultanées, ou SLAM, un problème notoirement difficile dans le domaine de la robotique. Nouveaux algorithmes développés par Guoquan (Paul) Huang, professeur assistant en génie mécanique, génie électrique et informatique, et informatique et sciences de l'information à l'Université du Delaware, rapprochent la réponse.

Huang utilise des systèmes de navigation visuelle-inertielle qui combinent des capteurs inertiels, qui contiennent des gyroscopes pour déterminer l'orientation et des accéléromètres pour déterminer l'accélération, avec des caméras. En utilisant les données de ces relativement peu coûteuses, composants largement disponibles, Huang mesure et calcule le mouvement et la localisation.

Par exemple, lorsque son équipe a connecté son système à un ordinateur portable et l'a transporté dans le laboratoire Spencer de l'UD, siège du Département de génie mécanique, ils ont généré suffisamment de données pour cartographier le bâtiment tout en suivant le mouvement de l'ordinateur portable lui-même. Dans un véhicule autonome, des capteurs et des caméras similaires seraient attachés à un robot dans le véhicule.

La capacité d'un véhicule autonome à suivre son propre mouvement et le mouvement des objets qui l'entourent est essentielle. "Nous devons localiser le véhicule avant de pouvoir contrôler automatiquement le véhicule, " a déclaré Huang. " Le véhicule a besoin de connaître sa position pour continuer. "

Ensuite, il y a la question de la sécurité. « Dans un scénario urbain, par exemple, il y a des piétons et d'autres véhicules, donc idéalement, le véhicule devrait être capable de suivre son propre mouvement ainsi que le mouvement des objets en mouvement dans son environnement, " dit Huang.

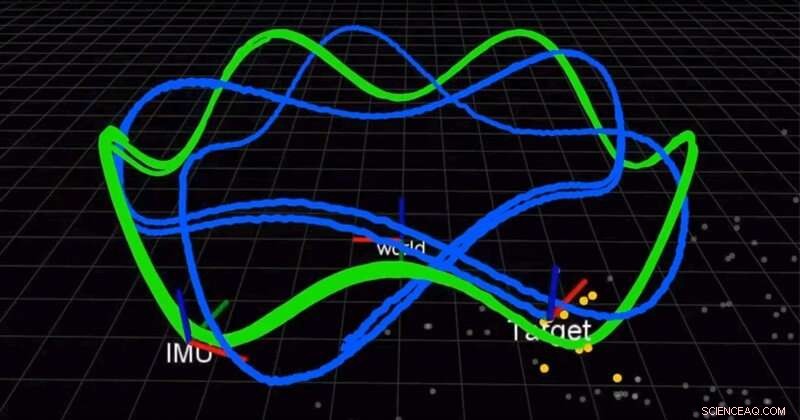

L'équipe utilise une caméra et une centrale inertielle (IMU) pour localiser simultanément un robot et suivre une cible en mouvement. La ligne verte est la trajectoire du robot et la ligne bleue est la trajectoire de la cible. Crédit :Université du Delaware

Dans un article publié plus tôt cette année dans le Journal international de recherche en robotique (IJRR), Huang et son équipe ont trouvé mieux, solution plus précise pour combiner les mesures inertielles. Jusqu'à maintenant, les scientifiques ont utilisé l'intégration discrète, une technique de calcul qui se rapproche de l'aire sous une courbe, approximer la solution. Au lieu, Le groupe de Huang a trouvé une solution et a prouvé qu'elle était meilleure que les méthodes existantes. Encore mieux, ils partagent leur solution.

"Nous open source notre code. Il est sur GitHub, " a déclaré Huang. " Beaucoup de gens ont utilisé notre code pour leurs systèmes. " Dans un autre article récent de l'IJRR, Huang et son équipe ont reformulé le problème SLAM comme une formule qui calcule de petits incréments de mouvement par les robots équipés des capteurs visuels et inertiels. Beaucoup de ces vidéos de recherche peuvent être trouvées sur la chaîne YouTube du laboratoire de Huang.

Ces découvertes pourraient avoir des applications au-delà des véhicules autonomes, des voitures aux drones aériens en passant par les navires sous-marins et plus encore. Les algorithmes de Huang pourraient également être utilisés pour développer des applications de réalité augmentée et de réalité virtuelle pour les appareils mobiles tels que les smartphones, qui ont déjà à bord des caméras et des capteurs inertiels.

"Ces capteurs sont très courants, donc la plupart des appareils mobiles, smartphone, même les drones et les véhicules ont ces capteurs, " a déclaré Huang. " Nous essayons de tirer parti des capteurs bon marché existants et de fournir une solution de localisation, une solution de suivi de mouvement."

En 2018 et à nouveau en 2019, Huang a reçu un prix de recherche de la faculté Google Daydream (AR/VR) pour soutenir ce travail.

"Les gens voient que les robots vont être la prochaine grande chose dans la vraie vie, c'est pourquoi l'industrie est en fait un moteur important de ce domaine de recherche, " dit Huang.