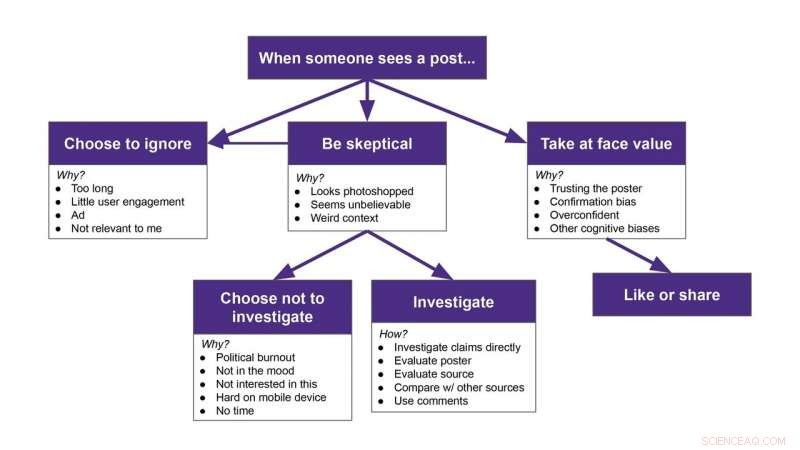

Les participants ont eu diverses réactions face à un faux message :certains l'ont carrément ignoré, certains l'ont pris pour argent comptant, certains ont cherché à savoir si c'était vrai, et certains s'en méfiaient, mais ont ensuite choisi de l'ignorer. Crédit :Franziska Roesner/Université de Washington

Plateformes de médias sociaux, comme Facebook et Twitter, fournir aux gens beaucoup d'informations, mais il devient de plus en plus difficile de dire ce qui est réel et ce qui ne l'est pas.

Des chercheurs de l'Université de Washington voulaient savoir comment les gens enquêtaient sur des publications potentiellement suspectes sur leurs propres flux. L'équipe a regardé 25 participants faire défiler leurs flux Facebook ou Twitter pendant que, à leur insu, une extension Google Chrome a ajouté au hasard du contenu démystifié au-dessus de certains des vrais messages. Les participants ont eu diverses réactions face à un faux message :certains l'ont carrément ignoré, certains l'ont pris pour argent comptant, certains ont cherché à savoir si c'était vrai, et certains s'en méfiaient, mais ont ensuite choisi de l'ignorer. Ces résultats ont été acceptés à la conférence 2020 ACM CHI sur les facteurs humains dans les systèmes informatiques.

« Nous voulions comprendre ce que font les gens lorsqu'ils rencontrent de fausses informations ou de fausses informations dans leurs flux. Le remarquent-ils ? Que font-ils à ce sujet ? » a déclaré l'auteur principal Franziska Roesner, professeur agrégé UW à la Paul G. Allen School of Computer Science &Engineering. "Il y a beaucoup de gens qui essaient d'être de bons consommateurs d'informations et ils ont du mal. Si nous pouvons comprendre ce que font ces gens, nous pourrions peut-être concevoir des outils qui peuvent les aider."

Des recherches antérieures sur la façon dont les gens interagissent avec la désinformation ont demandé aux participants d'examiner le contenu d'un compte créé par un chercheur, pas de quelqu'un qu'ils ont choisi de suivre.

"Cela pourrait rendre les gens automatiquement méfiants, " a déclaré l'auteur principal Christine Geeng, un étudiant au doctorat UW à l'école Allen. "Nous nous sommes assurés que tous les messages semblaient provenir de personnes que nos participants suivaient."

Les chercheurs ont recruté des participants âgés de 18 à 74 ans dans toute la région de Seattle, expliquant que l'équipe était intéressée à voir comment les gens utilisent les médias sociaux. Les participants utilisaient Twitter ou Facebook au moins une fois par semaine et utilisaient souvent les plateformes de médias sociaux sur un ordinateur portable.

Un exemple de fausse publication qu'un participant pourrait voir sur son fil Facebook pendant l'étude. Un participant a mentionné avoir sauté ce message parce qu'il a vu le mot « Floride » et a décidé qu'il ne le concernait pas. Crédit :Geeng et al./2020 ACM CHI conférence sur les facteurs humains dans les systèmes informatiques

Ensuite, l'équipe a développé une extension Chrome qui ajouterait au hasard de faux messages ou des mèmes qui avaient été démystifiés par le site Web de vérification des faits Snopes.com en plus de vrais messages pour faire apparaître temporairement qu'ils étaient partagés par des personnes sur les flux des participants. Alors au lieu de voir le post d'un cousin sur des vacances récentes, un participant verrait son cousin partager l'une des fausses histoires à la place.

Les chercheurs ont soit installé l'extension sur l'ordinateur portable du participant, soit le participant s'est connecté à son compte sur l'ordinateur portable du chercheur, qui avait l'extension activée. L'équipe a dit aux participants que l'extension modifierait leurs flux - les chercheurs n'ont pas dit comment - et suivrait leurs goûts et leurs partages pendant l'étude - cependant, En réalité, il ne suivait rien. L'extension a été retirée des ordinateurs portables des participants à la fin de l'étude.

"Nous leur ferions de faire défiler leurs flux avec l'extension active, " a déclaré Geeng. "Je leur ai dit de réfléchir à haute voix à ce qu'ils faisaient ou à ce qu'ils feraient s'ils se trouvaient dans une situation sans moi dans la pièce. Alors les gens parlaient de 'Oh ouais, je lirais cet article, ' ou 'Je sauterais ceci.' Parfois, je posais des questions comme, « Pourquoi sautez-vous cela ? Pourquoi voudriez-vous ça ?'"

Les participants ne pouvaient pas réellement aimer ou partager les faux messages. Sur Twitter, un "retweet" partagerait le vrai contenu sous le faux message. La seule fois où un participant a retweeté du contenu sous le faux message, les chercheurs les ont aidés à le défaire une fois l'étude terminée. Sur Facebook, les boutons J'aime et Partager ne fonctionnaient pas du tout.

Après que les participants eurent rencontré tous les faux messages (neuf pour Facebook et sept pour Twitter), les chercheurs ont arrêté l'étude et expliqué ce qui se passait.

"Ce n'était pas comme nous l'avons dit, 'Hey, il y avait de faux messages là-dedans. Nous l'avons dit, « Il est difficile de repérer la désinformation. Voici tous les faux messages que vous venez de voir. C'étaient des faux, et tes amis ne les ont pas vraiment postés, '", a déclaré Geeng. "Notre objectif n'était pas de tromper les participants ou de les faire se sentir exposés. Nous voulions normaliser la difficulté de déterminer ce qui est faux et ce qui ne l'est pas."

Un exemple de fausse publication qu'un participant pourrait voir sur son fil Facebook pendant l'étude. Crédit :Geeng et al./2020 ACM CHI conférence sur les facteurs humains dans les systèmes informatiques

Les chercheurs ont conclu l'entretien en demandant aux participants de partager les types de stratégies qu'ils utilisent pour détecter la désinformation.

En général, les chercheurs ont découvert que les participants ignoraient de nombreux messages, especially those they deemed too long, overly political or not relevant to them.

But certain types of posts made participants skeptical. Par exemple, people noticed when a post didn't match someone's usual content. Sometimes participants investigated suspicious posts—by looking at who posted it, evaluating the content's source or reading the comments below the post—and other times, people just scrolled past them.

"I am interested in the times that people are skeptical but then choose not to investigate. Do they still incorporate it into their worldviews somehow?" Roesner said. "At the time someone might say, 'That's an ad. I'm going to ignore it.' But then later do they remember something about the content, and forget that it was from an ad they skipped? That's something we're trying to study more now."

While this study was small, it does provide a framework for how people react to misinformation on social media, dit l'équipe. Now researchers can use this as a starting point to seek interventions to help people resist misinformation in their feeds.

"Participants had these strong models of what their feeds and the people in their social network were normally like. They noticed when it was weird. And that surprised me a little, " Roesner said. "It's easy to say we need to build these social media platforms so that people don't get confused by fake posts. But I think there are opportunities for designers to incorporate people and their understanding of their own networks to design better social media platforms."