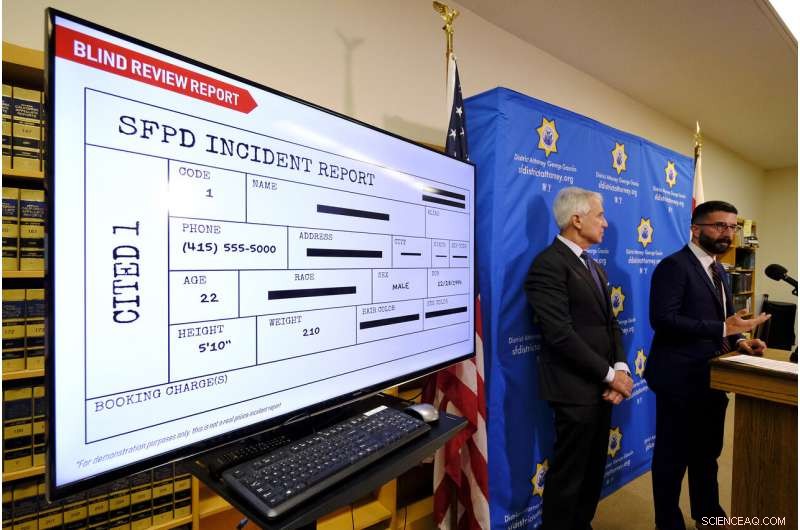

Avec un rapport d'incident de police aveugle affiché, Le procureur du district de San Francisco, George Gascon, la gauche, et Alex Chohlas-Wood, Directeur adjoint, Laboratoire de politique informatique de Stanford, parler de la mise en œuvre d'un outil d'intelligence artificielle pour éliminer le potentiel de biais dans les décisions de facturation, lors d'une conférence de presse mercredi, 12 Juin, 2019, à San Francisco. Dans une expérience unique en son genre, Les procureurs de San Francisco se tournent vers l'intelligence artificielle pour réduire les préjugés dans les tribunaux pénaux. (Photo AP/Eric Risberg)

Dans une expérience unique en son genre, Les procureurs de San Francisco se tournent vers l'intelligence artificielle pour réduire les préjugés raciaux dans les tribunaux, adopter un système qui supprime certains détails d'identification des rapports de police et ne laisse que les faits clés pour régir les décisions d'accusation.

Le procureur de district George Gascon a annoncé mercredi que son bureau commencera à utiliser la technologie en juillet pour "éliminer la race de l'équation" lorsqu'il décidera d'accuser ou non les suspects d'un crime.

Les experts de la justice pénale disent qu'ils n'ont jamais entendu parler d'un tel projet, et ils ont applaudi l'idée en tant que créatif, effort audacieux pour rendre les pratiques de recharge plus daltoniennes.

Le bureau de Gascon a travaillé avec des scientifiques et des ingénieurs des données du Stanford Computational Policy Lab pour développer un système qui prend les rapports de police électroniques et supprime automatiquement le nom d'un suspect, race et couleurs des cheveux et des yeux. Les noms des témoins et des policiers seront également supprimés, ainsi que des quartiers ou des districts spécifiques qui pourraient indiquer la race des personnes impliquées.

"Le système de justice pénale a eu un impact horrible sur les personnes de couleur dans ce pays, surtout les Afro-Américains, pour les générations, " Gascon a déclaré dans une interview avant l'annonce. " Si tous les procureurs ont pris la race hors de l'image lors de la prise de décisions d'accusation, nous serions probablement dans une bien meilleure position en tant que nation que nous ne le sommes aujourd'hui."

Avec un rapport de police hypothétique affiché, Le procureur du district de San Francisco, George Gascon, parle de la mise en œuvre d'un outil d'intelligence artificielle pour éliminer le potentiel de biais dans les décisions d'accusation lors d'une conférence de presse mercredi, 12 Juin, 2019, à San Francisco. Dans une expérience unique en son genre, Les procureurs de San Francisco se tournent vers l'intelligence artificielle pour réduire les préjugés dans les tribunaux pénaux. Ils adoptent un système qui supprime certains détails d'identification des rapports de police et ne laisse que les faits clés pour régir les décisions d'accusation. Gascon a annoncé que son bureau commencera à utiliser la technologie en juillet pour "éliminer la race de l'équation" lorsqu'il décidera d'accuser ou non les suspects d'un crime. (Photo AP/Eric Risberg)

Gascon a déclaré que son objectif était de développer un modèle qui pourrait être utilisé ailleurs, et la technologie sera offerte gratuitement à d'autres procureurs à travers le pays.

"Je les félicite vraiment, c'est un geste courageux, " dit Lucy Lang, ancien procureur de la ville de New York et directeur exécutif de l'Institute for Innovation in Prosecution du John Jay College of Criminal Justice.

La technologie repose sur les humains pour recueillir les faits initiaux, qui peut encore être influencé par les préjugés raciaux. Les procureurs prendront une décision initiale d'accusation sur la base du rapport de police rédigé. Ensuite, ils examineront l'intégralité du rapport, avec des détails restaurés, pour voir s'il existe des raisons atténuantes de reconsidérer la première décision, dit Gascon.

Lang et d'autres experts ont déclaré qu'ils attendaient avec impatience de voir les résultats et qu'ils s'attendaient à ce que le système soit un travail en cours.

Le procureur du district de San Francisco, George Gascon, la gauche, annonce la mise en œuvre d'un outil d'intelligence artificielle pour éliminer le potentiel de biais dans les décisions de facturation comme Alex Chohlas-Wood, Directeur adjoint, Laboratoire de politique informatique de Stanford, écoute lors d'une conférence de presse mercredi, 12 Juin, 2019, à San Francisco. Dans une expérience unique en son genre, Les procureurs de San Francisco se tournent vers l'intelligence artificielle pour réduire les préjugés dans les tribunaux pénaux. (Photo AP/Eric Risberg)

Le procureur du district de San Francisco, George Gascon, la gauche, annonce la mise en œuvre d'un outil d'intelligence artificielle pour éliminer le potentiel de biais dans les décisions de facturation comme Alex Chohlas-Wood, Directeur adjoint, Laboratoire de politique informatique de Stanford, écoute lors d'une conférence de presse mercredi, 12 Juin, 2019, à San Francisco. Dans une expérience unique en son genre, Les procureurs de San Francisco se tournent vers l'intelligence artificielle pour réduire les préjugés dans les tribunaux pénaux. (Photo AP/Eric Risberg)

En ce mardi, 16 février photo d'archive 2016, Le procureur du district de San Francisco, George Gascon, est présenté lors d'une conférence de presse à San Francisco, Mercredi, 12 Juin, 2019, Gascon annonce ce qui semble être le premier programme du genre utilisant l'intelligence artificielle pour réduire les préjugés dans le système de justice pénale. Dès le mois prochain, les procureurs décideront s'il faut inculper un suspect sur la base de rapports de police « daltoniens », dans lesquels les noms, la race et d'autres détails d'identification ont été supprimés. (Photo AP/Jeff Chiu)

"Chapeau pour essayer de nouvelles choses, " a déclaré Phillip Atiba Goff, président du Center for Policing Equity. "Il y a tellement de facteurs contextuels qui pourraient indiquer la race et l'origine ethnique qu'il est difficile d'imaginer comment même un humain pourrait éliminer tout cela."

Une étude de 2017 commandée par le procureur du district de San Francisco a révélé « des disparités raciales et ethniques substantielles dans les résultats de la justice pénale ». Les Afro-Américains ne représentaient que 6 % de la population du comté mais représentaient 41 % des arrestations entre 2008 et 2014.

L'étude a trouvé "peu de preuves de préjugés manifestes contre une race ou un groupe ethnique" parmi les procureurs qui traitent des infractions pénales. Mais Gascon a déclaré qu'il voulait trouver un moyen d'aider à éliminer un biais implicite qui pourrait être déclenché par la race d'un suspect, un nom à consonance ethnique ou un quartier en proie à la criminalité où ils ont été arrêtés.

Après qu'il commence, le programme sera revu chaque semaine, dit Maria Mckee, le directeur de l'analyse et de la recherche du DA.

Cette décision intervient après que San Francisco est devenue le mois dernier la première ville américaine à interdire l'utilisation de la reconnaissance faciale par la police et d'autres agences de la ville. La décision reflète une réaction croissante contre la technologie de l'IA alors que les villes cherchent à réglementer la surveillance par les agences municipales.

© 2019 La Presse Associée. Tous les droits sont réservés.