L'image d'entrée d'origine. Crédit :Lee et al.

Chercheurs d'IBM Research UK, l'Académie militaire des États-Unis et l'Université de Cardiff ont récemment proposé une nouvelle approche pour améliorer la sensibilité des LIME (Local Interpretable Model Agnostic Explanations), une technique pour parvenir à une meilleure compréhension des conclusions tirées par les algorithmes d'apprentissage automatique. Leur papier, publié sur la bibliothèque numérique de SPIE, pourraient éclairer le développement d'outils d'intelligence artificielle (IA) qui fournissent des explications exhaustives sur la façon dont ils sont parvenus à un résultat ou à une conclusion particulier.

"Nous pensons que l'IA et l'apprentissage automatique peuvent soutenir et augmenter la prise de décision humaine, mais qu'il y a aussi une nécessité pour une IA explicable, " Eunjin Lee, co-auteur du document de recherche original et spécialiste des technologies émergentes et inventeur principal chez IBM Research U.K., a déclaré TechXplore. "Aujourd'hui, les décisions prises par de nombreux systèmes d'apprentissage automatique sont inexplicables, c'est à dire., il n'y a aucun moyen pour nous, les humains, de savoir comment les systèmes sont arrivés à ces décisions. Notre recherche aborde ce problème en étudiant comment améliorer les techniques d'explicabilité qui visent à faire la lumière sur la nature de la « boîte noire » des processus d'apprentissage automatique."

LIME est une technique d'explicabilité particulièrement populaire qui peut être appliquée à de nombreux modèles d'apprentissage automatique. Malgré sa polyvalence, il est souvent considéré comme peu fiable et donc inefficace pour fournir des explications, également en raison de la variabilité des résultats qu'elle produit. Plutôt que de développer une toute nouvelle technique d'explicabilité, Lee et ses collègues ont entrepris d'identifier des mécanismes qui pourraient améliorer les explications LIME.

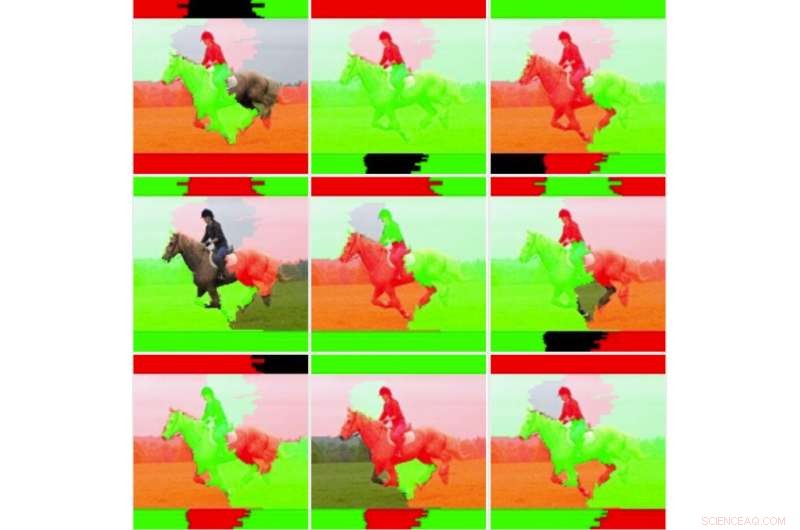

"Nous voulions d'abord approfondir l'instabilité que d'autres chercheurs ont observée pour déterminer si LIME était vraiment instable, " expliqua Lee. " Pour ce faire, nous avons testé LIME par rapport à notre ensemble de données et à notre modèle d'apprentissage automatique sans modifier le code sous-jacent. Nous avons immédiatement constaté que les images explicatives résultantes variaient considérablement et ne semblaient pas cohérentes. C'est peut-être le moment où beaucoup cesseraient tout simplement d'utiliser la technique."

Neuf sorties d'images pour la technique LIME non modifiée. Crédit :Lee et al.

Lorsque Lee et ses collègues ont approfondi les statistiques sous-jacentes de LIME, ils ont découvert que bien que les images générées semblaient être « visuellement instables, " l'explication par défaut ne prenait pas en compte toutes les informations statistiques. Par exemple, la coloration des images explicatives était trop simple et ne tenait pas compte de toutes les données sous-jacentes (par exemple, ne tenait pas compte des techniques telles que l'ombrage ou la transparence). Ce résultat explique en partie pourquoi les explications générées par LIME ne parviennent parfois pas à transmettre la certitude de la classification aux utilisateurs humains.

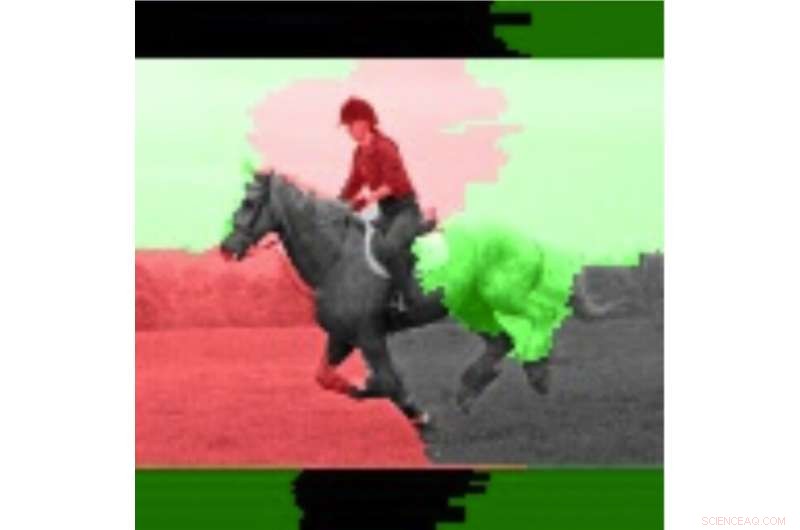

« C'est souvent le cas pour les systèmes dynamiques, tels que ceux que nous avons examinés dans cette étude, qu'effectuer de nombreux tests et rechercher des valeurs moyennes peut s'avérer bénéfique, " Lee a dit. " En adoptant cette approche, nous avons réalisé que la stabilité des explications s'est améliorée lorsque l'on considère les valeurs moyennes et les écarts types sur plusieurs exécutions plutôt que d'exécuter l'explication une seule fois."

Dans leur étude, Lee et ses collègues ont formé un modèle de réseau neuronal convolutif (CNN) en utilisant deux classes d'images, à savoir « manieur d'armes à feu » et « non-manieur ». Ils ont constaté que la sensibilité de LIME s'améliorait lorsque plusieurs poids de sortie pour des images individuelles étaient moyennés et visualisés.

Les chercheurs ont ensuite comparé ces images moyennées à des images individuelles pour évaluer la variabilité et la fiabilité des deux méthodes LIME (c'est-à-dire la méthode traditionnelle et celle qu'ils ont proposée). Ils ont découvert que les techniques traditionnelles à la CHAUX, sans les ajustements qu'ils ont faits, semblaient instables en raison de la simple coloration binaire qu'ils adoptaient et de la facilité avec laquelle les régions colorées se retournaient lors de la comparaison de différentes analyses. Lee et ses collègues ont également observé que les régions d'images significativement pondérées étaient cohérentes, tandis que les régions les moins pondérées ont inversé les états, en raison de l'instabilité inhérente aux techniques LIME.

L'image mise en évidence à l'aide de l'information moyenne. Crédit :Lee et al.

"Des techniques telles que LIME sont très prometteuses pour l'explicabilité de l'IA, surtout à une époque où il n'y a pas de facilité, capacités d'explication facilement disponibles pour les systèmes d'apprentissage automatique, " a déclaré Lee. " Bien que l'instabilité perçue soit justifiée, il existe des techniques qui peuvent aider à atténuer ce problème. Ces techniques ont des coûts de calcul supplémentaires, par exemple. exécuter l'explication plusieurs fois, ce qui signifie que l'utilisateur aura un plus grand retard dans la génération de l'explication."

L'étude menée par Lee et ses collègues offre une explication précieuse de certains des facteurs à l'origine de l'instabilité de LIME, comme observé dans des recherches antérieures. Leurs résultats suggèrent que l'amélioration des méthodes de pondération pour les techniques d'explicabilité peut améliorer leur stabilité et conduire à des explications plus fiables, en fin de compte, favoriser une plus grande confiance dans l'IA. Des recherches futures pourraient identifier des techniques numériques plus avancées pour améliorer encore la stabilité de LIME et d'autres méthodes d'explicabilité tout en réduisant les frais généraux supplémentaires.

« Nous avons un intérêt constant pour les systèmes d'IA responsables qui incluent des explications mais atténuent également les biais et améliorent la robustesse et la transparence, " Lee a déclaré. " Améliorer la capacité des développeurs à intégrer plus facilement des techniques d'explicabilité dans leurs solutions d'IA est un objectif clé pour nous. Récemment, IBM a lancé un service logiciel qui détecte automatiquement les biais et explique comment l'IA prend des décisions."

© 2019 Réseau Science X