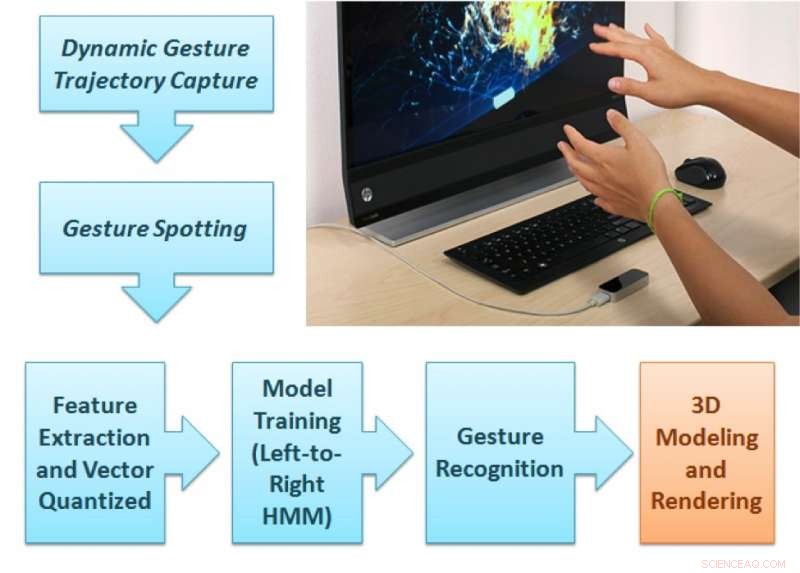

Le cadre d'analyse du geste proposé. Crédit :Singla, Roy, et Dogra.

Chercheurs du NIT Kurukshetra, IIT Roorkee et IIT Bhubaneswar ont développé une nouvelle méthode basée sur le contrôleur Leap Motion qui pourrait améliorer le rendu des formes 2D et 3D sur les appareils d'affichage. Cette nouvelle méthode, décrit dans un article prépublié sur arXiv, suit les mouvements des doigts pendant que les utilisateurs effectuent des gestes naturels dans le champ de vision d'un capteur.

Dans les années récentes, les chercheurs ont essayé de concevoir des interfaces utilisateur sans contact. De telles interfaces pourraient permettre aux utilisateurs d'interagir avec des appareils électroniques même lorsque leurs mains sont sales ou non conductrices, tout en aidant les personnes ayant un handicap physique partiel. Les études explorant ces possibilités ont été renforcées par l'émergence de capteurs à faible coût, tels que ceux utilisés par Leap Motion, Appareils Kinect et RealSense.

« Nous voulions développer une technologie qui puisse offrir une expérience d'enseignement engageante aux étudiants apprenant l'art de l'argile ou même aux enfants qui apprennent les alphabets de base, " Dr Debi Prosad Dogra, l'un des chercheurs qui a mené l'étude a déclaré à TechXplore. "Comprenant le fait que les enfants apprennent mieux à partir de stimuli visuels, nous avons utilisé un appareil de capture de mouvement manuel bien connu pour offrir cette expérience. Nous voulions concevoir un cadre capable d'identifier les gestes de l'enseignant et de rendre les visuels à l'écran. La configuration peut être utilisée pour des applications nécessitant un rendu visuel guidé par les gestes de la main."

Le cadre proposé par le Dr Dogra et ses collègues comporte deux parties distinctes. Dans la première partie, l'utilisateur effectue un geste naturel parmi les 36 types de gestes disponibles dans le champ de vision de l'appareil Leap Motion.

"Les deux caméras IR à l'intérieur du capteur peuvent enregistrer la séquence de gestes, " a déclaré le Dr Dogra. " Le module d'apprentissage automatique proposé peut prédire la classe de geste et une unité de rendu restitue la forme correspondante sur l'écran. "

Les trajectoires de la main de l'utilisateur sont analysées pour extraire les fonctionnalités étendues de Npen++ en 3D. Ces fonctionnalités, représenter les mouvements des doigts de l'utilisateur pendant les gestes, sont alimentés à un modèle de Markov caché de gauche à droite (HMM) unidirectionnel pour la formation. Le système effectue ensuite une cartographie un à un entre les gestes et les formes. Finalement, les formes correspondant à ces gestes sont rendues sur l'écran à l'aide de l'interface MuPad.

« Du point de vue du développeur, le cadre proposé est un cadre type ouvert, " expliqua le Dr Dogra. " Afin d'ajouter plus de gestes, un développeur a juste besoin de collecter des données de séquence de gestes auprès d'un certain nombre de volontaires et de reformer le modèle d'apprentissage automatique (ML) pour de nouvelles classes. Ce modèle ML peut apprendre une représentation généralisée."

Dans le cadre de leur étude, les chercheurs ont créé un ensemble de données de 5400 échantillons enregistrés par 10 volontaires. Leur jeu de données contient 18 formes géométriques et 18 non géométriques, cercle compris, rectangle, fleur, cône, sphère, et beaucoup plus.

"La sélection des fonctionnalités est l'une des parties essentielles d'une application d'apprentissage automatique typique, " a déclaré le Dr Dogra. " Dans notre travail, nous avons étendu les fonctionnalités 2-D Npen++ existantes en 3-D. Il a été démontré que les fonctionnalités étendues améliorent considérablement les performances. Les fonctionnalités 3-D Npen++ peuvent également être utilisées pour d'autres types de signaux, comme la détection de la posture corporelle, reconnaissance d'activité, etc."

Le Dr Dogra et ses collègues ont évalué leur méthode avec une validation croisée quintuple et ont constaté qu'elle atteignait une précision de 92,87 pour cent. Leurs fonctionnalités 3D étendues ont surpassé les fonctionnalités 3D existantes pour la représentation et la classification des formes. Dans le futur, la méthode conçue par les chercheurs pourrait aider au développement d'applications utiles d'interaction homme-machine (IHM) pour les dispositifs d'affichage intelligents.

"Notre approche de la reconnaissance gestuelle est assez générale, " a ajouté le Dr Dogra. " Nous considérons cette technologie comme un outil de communication pour les personnes sourdes et handicapées. Nous voulons maintenant utiliser le système pour comprendre les gestes et les convertir en format ou en formes écrites, pour aider les gens dans les conversations de la vie quotidienne. Avec l'avènement de modèles avancés d'apprentissage automatique tels que les réseaux de neurones récurrents (RNN) et la mémoire à long terme (LSTM), il existe également de vastes étendues dans la classification temporelle des signaux."

© 2018 Réseau Science X