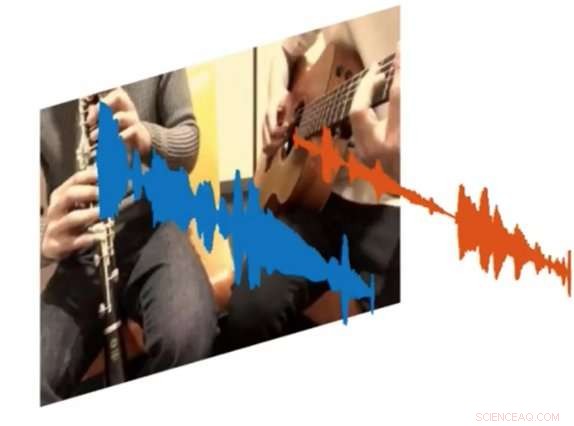

Un nouveau système d'IA appelé PixelPlayer peut regarder une image et déterminer quel ensemble de pixels est responsable de la création d'ensembles spécifiques d'ondes sonores. Crédit :MIT CSAIL

Les musiciens amateurs et professionnels peuvent passer des heures à parcourir des clips YouTube pour comprendre exactement comment jouer certaines parties de leurs chansons préférées. Mais et s'il y avait un moyen de jouer une vidéo et d'isoler le seul instrument que vous vouliez entendre ?

C'est le résultat d'un nouveau projet d'IA du Laboratoire d'informatique et d'intelligence artificielle (CSAIL) du MIT :un système d'apprentissage en profondeur qui peut regarder une vidéo d'une performance musicale, et isoler les sons d'instruments spécifiques et les rendre plus forts ou plus doux.

Le système, qui est "auto-supervisé, " ne nécessite aucune annotation humaine sur ce que sont les instruments ou à quoi ils ressemblent.

Formé sur plus de 60 heures de vidéos, le système "PixelPlayer" permet de visionner une performance musicale inédite, identifier des instruments spécifiques au niveau du pixel, et extraire les sons associés à ces instruments.

Par exemple, il peut prendre une vidéo d'un tuba et d'une trompette jouant la chanson thème "Super Mario Brothers", et séparer les ondes sonores associées à chaque instrument.

Les chercheurs disent que la possibilité de modifier le volume des instruments individuels signifie qu'à l'avenir, des systèmes comme celui-ci pourraient potentiellement aider les ingénieurs à améliorer la qualité audio des anciennes séquences de concerts. Vous pouvez même imaginer des producteurs prenant des parties d'instruments spécifiques et prévisualisant à quoi ils ressembleraient avec d'autres instruments (c'est-à-dire une guitare électrique remplacée par une guitare acoustique).

Dans un nouveau journal, l'équipe a démontré que PixelPlayer peut identifier les sons de plus de 20 instruments couramment utilisés. L'auteur principal Hang Zhao dit que le système serait capable d'identifier beaucoup plus d'instruments s'il disposait de plus de données d'entraînement, bien qu'il puisse encore avoir du mal à gérer les différences subtiles entre les sous-classes d'instruments (comme un saxophone alto contre un ténor).

Les efforts précédents pour séparer les sources sonores se sont concentrés exclusivement sur l'audio, qui nécessite souvent un étiquetage humain poussé. En revanche, PixelPlayer introduit l'élément de vision, qui, selon les chercheurs, rend les étiquettes humaines inutiles, car la vision permet l'auto-surveillance.

Le système localise d'abord les régions de l'image qui produisent des sons, puis sépare les sons d'entrée en un ensemble de composants qui représentent le son de chaque pixel.

« Nous nous attendions à un scénario idéal où nous pourrions reconnaître quels instruments produisent quels types de sons, " dit Zhao, un doctorat étudiant au CSAIL. « Nous avons été surpris de pouvoir réellement localiser les instruments dans l'espace au niveau du pixel. Être capable de le faire ouvre de nombreuses possibilités, comme pouvoir éditer l'audio d'instruments individuels en un seul clic sur la vidéo."

PixelPlayer utilise des méthodes de « deep learning, " ce qui signifie qu'il trouve des modèles dans les données en utilisant ce que l'on appelle des " réseaux de neurones " qui ont été formés sur des vidéos existantes. Plus précisément, un réseau de neurones analyse les visuels de la vidéo, on analyse l'audio, et un troisième "synthétiseur" associe des pixels spécifiques à des ondes sonores spécifiques pour séparer les différents sons.

PixelPlayer comprend également une interface qui permet aux utilisateurs de modifier le volume d'instruments spécifiques dans le mix. Crédit :MIT CSAIL

Le fait que PixelPlayer utilise un apprentissage en profondeur dit "auto-supervisé" signifie que l'équipe du MIT ne comprend pas explicitement tous les aspects de la façon dont elle apprend quels instruments produisent quels sons.

Cependant, Zhao dit qu'il peut dire que le système semble reconnaître les éléments réels de la musique. Par exemple, certaines fréquences harmoniques semblent être en corrélation avec des instruments comme le violon, tandis que les motifs rapides ressemblant à des impulsions correspondent à des instruments comme le xylophone.

Zhao dit qu'un système comme PixelPlayer pourrait même être utilisé sur des robots pour mieux comprendre les sons environnementaux émis par d'autres objets, comme des animaux ou des véhicules.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.