Joueur prêt ? Crédit :Wikimédia

Les jeux ont longtemps été utilisés comme bancs d'essai et de référence pour l'intelligence artificielle, et les réalisations n'ont pas manqué ces derniers mois. AlphaGo de Google DeepMind et le bot de poker Libratus de l'Université Carnegie Mellon ont tous deux battu des experts humains dans des jeux traditionnellement difficiles pour l'IA – quelque 20 ans après que DeepBlue d'IBM ait réalisé le même exploit aux échecs.

Des jeux comme ceux-ci ont l'attrait de règles clairement définies; ils sont relativement simples et bon marché pour les chercheurs en IA, et ils offrent une variété de défis cognitifs à n'importe quel niveau de difficulté souhaité. En inventant des algorithmes qui les jouent bien, les chercheurs espèrent mieux comprendre les mécanismes nécessaires pour fonctionner de manière autonome.

Avec l'arrivée des dernières techniques en IA et en machine learning, l'attention se porte maintenant sur les jeux vidéo visuellement détaillés - y compris le jeu de tir 3-D Doom, divers jeux Atari 2-D tels que Pong et Space Invaders, et le jeu de stratégie en temps réel StarCraft.

Tout cela est certainement un progrès, mais une partie clé de l'image plus large de l'IA est négligée. La recherche a priorisé les jeux dans lesquels toutes les actions pouvant être effectuées sont connues à l'avance, qu'il s'agisse de déplacer un chevalier ou de tirer avec une arme. L'ordinateur dispose de toutes les options dès le départ et l'accent est mis sur la manière dont il choisit entre elles. Le problème est que cela déconnecte la recherche en IA de la tâche de rendre les ordinateurs véritablement autonomes.

Peaux de banane

Faire en sorte que les ordinateurs déterminent quelles actions existent même dans un contexte donné présente des défis conceptuels et pratiques que les chercheurs en jeux ont à peine tenté de résoudre jusqu'à présent. Le problème du "singe et des bananes" est un exemple d'une énigme de longue date en matière d'IA dans laquelle aucun progrès récent n'a été réalisé.

Le problème a été initialement posé par John McCarthy, l'un des pères fondateurs de l'IA, en 1963 :il y a une pièce contenant une chaise, un baton, un singe et un régime de bananes accrochés à un crochet au plafond. La tâche consiste pour un ordinateur à proposer une séquence d'actions pour permettre au singe d'acquérir les bananes.

McCarthy a fait une distinction clé entre deux aspects de cette tâche en termes d'intelligence artificielle. Faisabilité physique – déterminer si une séquence particulière d'actions est physiquement réalisable ; et faisabilité épistémique ou liée à la connaissance – déterminer quelles actions possibles pour le singe existent réellement.

Déterminer ce qui est physiquement faisable pour le singe est très facile pour un ordinateur s'il est informé à l'avance de toutes les actions possibles - "monter sur une chaise", "wave stick" et ainsi de suite. Un programme simple qui demande à l'ordinateur de parcourir toutes les séquences d'actions possibles une par une arrivera rapidement à la meilleure solution.

Si l'ordinateur doit d'abord déterminer quelles actions sont encore possibles, cependant, c'est un défi beaucoup plus difficile. Cela soulève des questions sur la façon dont nous représentons la connaissance, les conditions nécessaires et suffisantes pour savoir quelque chose, et comment nous savons quand suffisamment de connaissances ont été acquises. En soulignant ces problèmes, McCarthy a déclaré:"Notre objectif ultime est de créer des programmes qui apprennent de leur expérience aussi efficacement que les humains."

Jusqu'à ce que les ordinateurs puissent résoudre les problèmes sans aucune description prédéterminée des actions possibles, cet objectif ne peut être atteint. Il est regrettable que les chercheurs en IA négligent cela :non seulement ces problèmes sont plus difficiles et plus intéressants, ils apparaissent comme une condition préalable à de nouveaux progrès significatifs dans le domaine.

Appel textuel

Pour fonctionner de manière autonome dans un environnement complexe, il est impossible de décrire à l'avance comment manipuler au mieux – voire caractériser – les objets qui s'y trouvent. Apprendre aux ordinateurs à contourner ces difficultés conduit immédiatement à de profondes questions sur l'apprentissage de l'expérience précédente.

Plutôt que de se concentrer sur des jeux comme Doom ou StarCraft, où il est possible d'éviter ce problème, un test plus prometteur pour l'IA moderne pourrait être l'humble aventure textuelle des années 1970 et 1980.

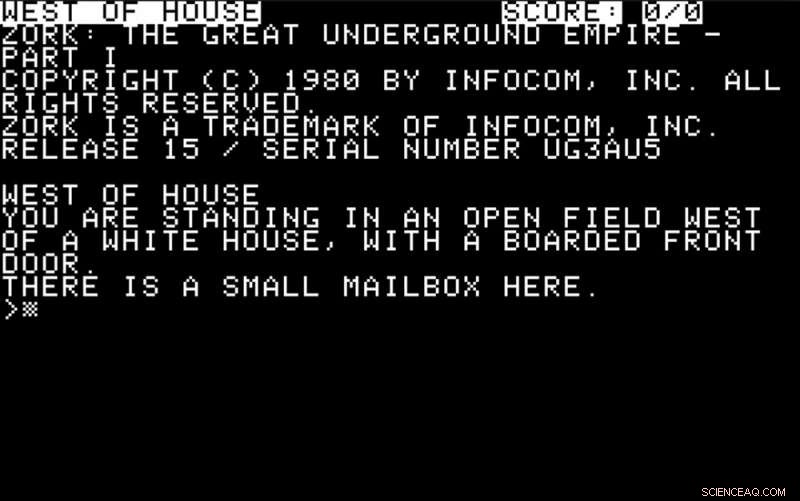

À l'époque où les ordinateurs avaient des capacités graphiques sophistiquées, des jeux comme Colossal Cave et Zork étaient populaires. Les joueurs ont été informés de leur environnement par des messages à l'écran :

Ils devaient répondre par des instructions simples, généralement sous la forme d'un verbe ou d'un verbe plus un nom - "regarde", "prendre la boîte" et ainsi de suite. Une partie du défi consistait à déterminer quelles actions étaient possibles et utiles et à réagir en conséquence.

Un bon défi pour l'IA moderne serait de jouer le rôle d'un joueur dans une telle aventure. L'ordinateur devrait donner un sens aux descriptions textuelles à l'écran et y répondre par des actions, en utilisant un mécanisme prédictif pour déterminer leur effet probable.

Des comportements plus sophistiqués de la part de l'ordinateur impliqueraient d'explorer l'environnement, définir des objectifs, faire des choix d'action axés sur les objectifs et résoudre les divers défis intellectuels généralement requis pour progresser.

À quel point les méthodes d'IA modernes du type promu par des géants de la technologie comme IBM, Google, Facebook ou Microsoft se débrouilleraient dans ces aventures textuelles est une question ouverte – tout comme la quantité de connaissances humaines spécialisées dont ils auraient besoin pour chaque nouveau scénario.

Pour mesurer les progrès dans ce domaine, au cours des deux dernières années, nous avons organisé un concours à la conférence IEEE sur l'intelligence informatique et les jeux, qui cette année a lieu à Maastricht aux Pays-Bas en août. Les concurrents soumettent leurs inscriptions à l'avance, et peuvent utiliser la technologie d'IA de leur choix pour créer des programmes capables de jouer à ces jeux en donnant un sens à une description textuelle et en émettant des commandes de texte appropriées en retour.

En bref, les chercheurs doivent reconsidérer leurs priorités si l'IA veut continuer à progresser. Si déterrer les racines délaissées de la discipline s'avère fructueux, le singe peut enfin avoir ses bananes après tout.

Cet article a été initialement publié sur The Conversation. Lire l'article original.