En modifiant le génome des plantes et des micro-organismes, les biologistes synthétiques peuvent concevoir des systèmes biologiques qui répondent à une spécification, comme la production de composés chimiques précieux, la sensibilité des bactéries à la lumière ou la programmation de cellules bactériennes pour qu'elles envahissent les cellules cancéreuses.

Ce domaine scientifique, bien qu’il ne date que de quelques décennies, a permis la production à grande échelle de médicaments et a établi la capacité de fabriquer des produits chimiques, des carburants et des matériaux sans pétrole. Il semble que les produits biofabriqués soient là pour rester et que nous dépendrons de plus en plus d'eux à mesure que nous nous éloignons des processus de fabrication traditionnels à forte intensité de carbone.

Mais il y a un obstacle majeur :la biologie synthétique demande beaucoup de travail et est lente. Qu'il s'agisse de comprendre les gènes nécessaires à la fabrication d'un produit, de les faire fonctionner correctement dans un organisme hôte et enfin de faire prospérer cet organisme dans un environnement industriel à grande échelle afin qu'il puisse produire suffisamment de produits pour répondre à la demande du marché, le développement de un processus de biofabrication peut prendre de nombreuses années et plusieurs millions de dollars d'investissement.

Héctor García Martín, chercheur au sein du domaine des biosciences du Laboratoire national Lawrence Berkeley (Berkeley Lab), s'efforce d'accélérer et d'affiner ce paysage de R&D en appliquant l'intelligence artificielle et les outils mathématiques qu'il a maîtrisés au cours de sa formation de physicien.

Nous avons discuté avec lui pour découvrir comment l'IA, les algorithmes sur mesure, la modélisation mathématique et l'automatisation robotique peuvent constituer une somme supérieure à leurs parties et fournir une nouvelle approche de la biologie synthétique.

Je pense que les obstacles que nous rencontrons en biologie synthétique pour créer des produits renouvelables proviennent tous d’une lacune scientifique très fondamentale :notre incapacité à prédire les systèmes biologiques. De nombreux biologistes synthétiques pourraient être en désaccord avec moi et souligner la difficulté de faire passer les processus de quelques millilitres à des milliers de litres, ou les difficultés à obtenir des rendements suffisamment élevés pour garantir la viabilité commerciale, ou même la recherche ardue dans la littérature de molécules ayant les bonnes propriétés à synthétiser. Et tout cela est vrai.

Mais je crois que tout cela est une conséquence de notre incapacité à prédire les systèmes biologiques. Supposons que quelqu'un avec une machine à voyager dans le temps (ou Dieu, ou votre être omniscient préféré) vienne nous donner une séquence d'ADN parfaitement conçue à insérer dans un microbe afin qu'il crée la quantité optimale de la molécule cible souhaitée (par exemple, un biocarburant) à grande échelle (milliers de litres).

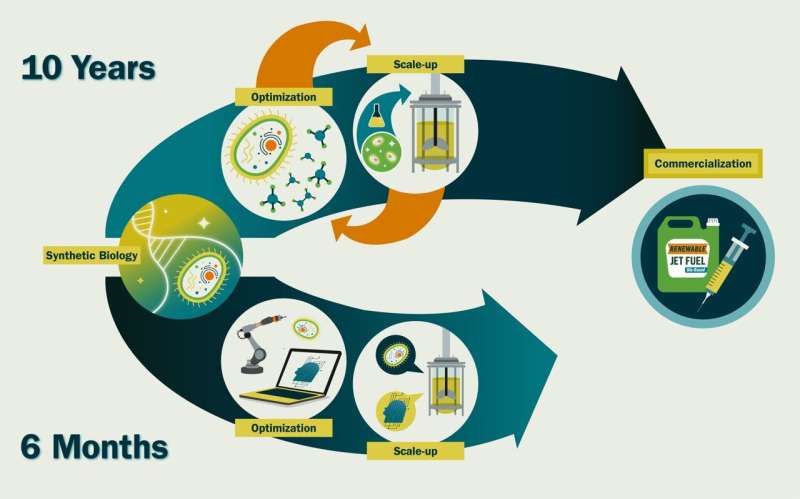

Il faudrait quelques semaines pour le synthétiser et le transformer en cellule, et trois à six mois pour le cultiver à une échelle commerciale. La différence entre ces 6,5 mois et les 10 ans qu'il nous faut aujourd'hui réside dans le temps passé à affiner les séquences génétiques et les conditions de culture, par exemple en réduisant l'expression d'un certain gène pour éviter l'accumulation de substances toxiques ou en augmentant les niveaux d'oxygène pour une croissance plus rapide. - parce que nous ne savons pas comment cela affectera le comportement cellulaire.

Si nous pouvions prédire cela avec précision, nous serions en mesure de les concevoir beaucoup plus efficacement. Et c’est ainsi que cela se passe dans d’autres disciplines. Nous ne concevons pas d’avions en construisant de nouvelles formes d’avion et en les pilotant pour voir à quel point ils fonctionnent. Notre connaissance de la dynamique des fluides et de l'ingénierie structurelle est si bonne que nous pouvons simuler et prédire l'effet qu'un changement de fuselage aura sur le vol.

Nous utilisons l’apprentissage automatique et l’intelligence artificielle pour fournir la puissance prédictive dont la biologie synthétique a besoin. Notre approche évite la nécessité de comprendre pleinement les mécanismes moléculaires impliqués, ce qui permet de gagner un temps considérable. Cependant, cela suscite certaines suspicions chez les biologistes moléculaires traditionnels.

Normalement, ces outils doivent être formés sur d’énormes ensembles de données, mais nous n’avons tout simplement pas autant de données en biologie synthétique que dans un domaine comme l’astronomie. Nous avons donc développé des méthodes uniques pour surmonter cette limitation. Par exemple, nous avons utilisé l'apprentissage automatique pour prédire quels promoteurs (séquences d'ADN qui interviennent dans l'expression des gènes) choisir pour obtenir une productivité maximale.

Nous avons également utilisé l'apprentissage automatique pour prédire les milieux de croissance appropriés pour une production optimale, pour prédire la dynamique métabolique des cellules, pour augmenter les rendements des précurseurs durables du carburant d'aviation et pour prédire comment concevoir des polycétides synthases fonctionnelles (des enzymes capables de produire une énorme variété de molécules précieuses, mais sont tristement difficiles à concevoir de manière prévisible).

Dans bon nombre de ces cas, nous avons dû automatiser les expériences scientifiques pour obtenir les grandes quantités de données de haute qualité dont nous avons besoin pour que les méthodes d’IA soient réellement efficaces. Par exemple, nous avons utilisé des manipulateurs de liquides robotisés pour créer de nouveaux milieux de croissance pour les microbes et tester leur efficacité, et nous avons développé des puces microfluidiques pour tenter d’automatiser l’édition génétique. Je travaille activement avec d'autres membres du laboratoire (et des collaborateurs externes) pour créer des laboratoires autonomes pour la biologie synthétique.

Le nombre de groupes de recherche possédant une expertise à l’intersection de l’IA, de la biologie synthétique et de l’automatisation est très restreint, en particulier en dehors de l’industrie. Je soulignerais Philip Romero de l'Université du Wisconsin et Huimin Zhao de l'Université de l'Illinois à Urbana-Champaign. Cependant, étant donné le potentiel de cette combinaison de technologies d'avoir un impact sociétal énorme (par exemple, dans la lutte contre le changement climatique ou dans la production de nouveaux médicaments thérapeutiques ), je pense que ce domaine va se développer très rapidement dans un avenir proche.

J'ai fait partie de plusieurs groupes de travail, commissions et ateliers, y compris une réunion d'experts de la Commission de sécurité nationale sur les biotechnologies émergentes, qui ont discuté des opportunités dans ce domaine et rédigent des rapports avec des recommandations actives.

Je pense qu’une application intense de l’IA et de la robotique/automatisation à la biologie synthétique peut accélérer d’environ 20 fois les délais de la biologie synthétique. Nous pourrions créer une nouvelle molécule commercialement viable en environ 6 mois au lieu d’environ 10 ans. Cela est absolument nécessaire si nous voulons permettre une bioéconomie circulaire :l'utilisation durable de la biomasse renouvelable (sources de carbone) pour générer de l'énergie et des produits intermédiaires et finaux.

On estime qu’il existe aujourd’hui 3 574 produits chimiques en grand volume de production (HPV) (produits chimiques que les États-Unis produisent ou importent en quantités d’au moins 1 million de livres par an) qui proviennent de la pétrochimie. Une entreprise de biotechnologie appelée Genencor a nécessité 575 années-personnes de travail pour produire une voie renouvelable permettant de produire l'un de ces produits chimiques largement utilisés, le 1,3-propanediol, et c'est un chiffre typique.

Si nous supposons que c'est le temps qu'il faudrait pour concevoir un processus de biofabrication destiné à remplacer le processus de raffinage du pétrole pour chacun de ces milliers de produits chimiques, nous aurions besoin d'environ 2 000 000 d'années-personnes. Si nous mettons l'ensemble des quelque 5 000 biologistes synthétiques américains (disons 10 % de tous les scientifiques en biologie aux États-Unis, et c'est une surestimation) pour travailler là-dessus, il faudrait environ 371 ans pour créer cette bioéconomie circulaire.

Avec l'anomalie de température qui augmente chaque année, nous n'avons pas vraiment 371 ans. Ces chiffres sont évidemment de rapides calculs d’enveloppe, mais ils donnent une idée de l’ordre de grandeur si nous poursuivons sur la voie actuelle. Nous avons besoin d'une approche disruptive.

De plus, cette approche permettrait de poursuivre des objectifs plus ambitieux qui sont irréalisables avec les approches actuelles, tels que :l'ingénierie des communautés microbiennes à des fins environnementales et de santé humaine, les biomatériaux, les tissus issus de la bio-ingénierie, etc.

Berkeley Lab a fortement investi dans la biologie synthétique au cours des deux dernières décennies et affiche une expertise considérable dans le domaine. De plus, le laboratoire de Berkeley est le foyer de la « grande science » :une science multidisciplinaire impliquant de grandes équipes et

Je pense que c’est la bonne voie pour la biologie synthétique en ce moment. Beaucoup a été accompli au cours des soixante-dix dernières années depuis la découverte de l'ADN grâce aux approches traditionnelles de biologie moléculaire menées par un seul chercheur, mais je pense que les défis à venir nécessitent une approche multidisciplinaire impliquant des biologistes synthétiques, des mathématiciens, des ingénieurs électriciens, des informaticiens, des biologistes moléculaires et des ingénieurs chimistes. , etc. Je pense que Berkeley Lab devrait être l'endroit naturel pour ce genre de travail.

Depuis très tôt, je me suis beaucoup intéressé aux sciences, plus particulièrement à la biologie et à la physique. Je me souviens très bien de mon père qui m'avait parlé de l'extinction des dinosaures. Je me souviens aussi qu'on m'a raconté comment, au Permien, il y avait des libellules géantes (~ 75 cm) parce que les niveaux d'oxygène étaient beaucoup plus élevés qu'aujourd'hui (~ 30 % contre 20 %) et que les insectes obtiennent leur oxygène par diffusion et non par les poumons. Par conséquent, des niveaux d’oxygène plus élevés ont permis l’apparition d’insectes beaucoup plus gros.

J’étais également fasciné par la capacité que nous offrent les mathématiques et la physique à comprendre et à concevoir les choses qui nous entourent. La physique était mon premier choix, car la façon dont la biologie était enseignée à cette époque impliquait beaucoup plus de mémorisation que de prédictions quantitatives. Mais j'ai toujours eu envie de savoir quels principes scientifiques ont conduit à la vie sur Terre telle que nous la voyons aujourd'hui.

J'ai obtenu mon doctorat en physique théorique, dans lequel j'ai simulé des condensats de Bose-Einstein (un état de la matière qui apparaît lorsque des particules appelées bosons, un groupe qui comprend des photons, sont à une température proche du zéro absolu) et en utilisant l'intégrale de chemin Monte Carlo, mais cela a également fourni une explication à une énigme vieille de plus de 100 ans en écologie :pourquoi le nombre d'espèces dans une zone évolue-t-il avec une loi de puissance apparemment universelle en fonction de la zone (S=cA z , z=0,25) ? À partir de ce moment-là, j'aurais pu continuer à travailler sur la physique, mais j'ai pensé que je pourrais avoir un plus grand impact en appliquant les capacités prédictives à la biologie.

Pour cette raison, j’ai pris le pari d’obtenir un doctorat en physique. et a accepté un postdoc au DOE Joint Genome Institute en métagénomique (séquençage des communautés microbiennes pour démêler leurs activités cellulaires sous-jacentes) dans l'espoir de développer des modèles prédictifs pour les microbiomes. J'ai cependant découvert que la plupart des écologistes microbiens avaient un intérêt limité pour les modèles prédictifs. J'ai donc commencé à travailler dans la biologie synthétique, qui nécessite des capacités de prédiction car elle vise à concevoir des cellules selon une spécification.

Mon poste actuel me permet d'utiliser mes connaissances mathématiques pour essayer de concevoir de manière prévisible des cellules afin de produire des biocarburants et de lutter contre le changement climatique. Nous avons fait beaucoup de progrès et avons fourni certains des premiers exemples de biologie synthétique guidée par l'IA, mais il reste encore beaucoup de travail à faire pour rendre la biologie prévisible.

Fourni par le Laboratoire national Lawrence Berkeley