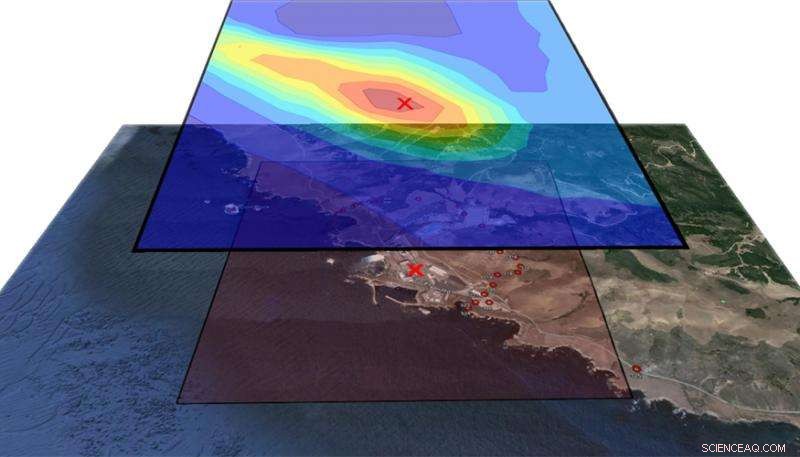

Dans cette figure, la couche supérieure montre les contours de probabilité d'emplacement de libération et la couche inférieure montre la région géographique entourant la centrale électrique de Diablo Canyon. Le lieu de sortie réel, désigné par le X rouge, tombe dans le contour de probabilité la plus élevée (rouge foncé) déterminé par l'algorithme d'inversion. Crédit :Laboratoire national Lawrence Livermore

En cas de rejet radiologique accidentel d'un réacteur de centrale nucléaire ou d'une installation industrielle, retracer le panache aérien de rayonnement jusqu'à sa source en temps opportun pourrait être un facteur crucial pour les intervenants d'urgence, les évaluateurs des risques et les enquêteurs.

À l'aide de données recueillies lors d'une expérience de traceur atmosphérique il y a trois décennies à la centrale nucléaire de Diablo Canyon sur la côte centrale de Californie, des dizaines de milliers de simulations informatiques et un modèle statistique, des chercheurs du Lawrence Livermore National Laboratory (LLNL) ont créé des méthodes qui peuvent estimer la source d'un rejet atmosphérique avec une plus grande précision qu'auparavant.

Les méthodes intègrent deux modèles informatiques :le modèle américain de recherche et de prévision météorologiques (WRF), qui produit des simulations de champs de vent, et le modèle de dispersion communautaire FLEXPART, qui prédit les panaches de concentration en fonction du temps, montant et lieu d'une libération. En utilisant ces modèles, Les scientifiques atmosphériques Don Lucas et Matthew Simpson du National Atmospheric Release Advisory Center (NARAC) de LLNL ont exécuté des simulations développées à des fins de sécurité nationale et d'intervention d'urgence.

En 1986, évaluer l'impact d'un éventuel rejet radioactif à la centrale de Diablo Canyon, Pacific Gas &Electric (PG&E) a libéré un gaz non réactif, Hexafluorure de soufre, dans l'atmosphère et récupéré les données de 150 instruments placés dans la centrale électrique et ses environs. Ces données ont été mises à disposition des scientifiques du LLNL, en leur offrant une occasion rare et précieuse de tester leurs modèles informatiques en les comparant à des données réelles.

"Parfois, les modèles que nous utilisons dans NARAC sont en cours de développement et nous devons les tester, " a déclaré Lucas. " Le boîtier Diablo Canyon est une référence que nous pouvons utiliser pour garder nos outils de modélisation à jour. Pour ce projet, nous avons utilisé nos modèles météorologiques de pointe et avons dû remonter le temps jusqu'aux années 1980, utiliser d'anciennes données météo pour recréer, du mieux que nous pouvions, les conditions dans lesquelles elles ont été réalisées. Nous creusions toutes les données, mais même cela ne suffisait pas à déterminer les conditions météorologiques exactes à ce moment-là. »

En raison de la topographie complexe et du microclimat qui entourent Diablo Canyon, Lucas a dit, l'incertitude du modèle était élevée, et lui et Simpson ont dû concevoir de grands ensembles de simulations utilisant des modèles météorologiques et de dispersion. Dans le cadre d'un récent projet de recherche et développement dirigé par un laboratoire (LDRD) dirigé par le scientifique retraité du LLNL Ron Baskett et le scientifique du LLNL Philip Cameron-Smith, ils ont couru 40, 000 simulations de panaches, modifier des paramètres tels que le vent, le lieu du rejet et la quantité de matière, chacun prend environ 10 heures pour terminer.

L'un de leurs principaux objectifs était de reconstituer le montant, le lieu et l'heure du lâcher lorsque le temps est incertain. Pour améliorer cette capacité de modélisation inverse, ils ont demandé l'aide de Devin Francom, un Lawrence Graduate Scholar dans le groupe de statistique appliquée à LLNL. Sous la direction de Bruno Sanso au Département de Statistiques de l'UC Santa Cruz, et son mentor LLNL et statisticienne Vera Bulaevskaya, Francom a développé un modèle statistique qui a été utilisé pour analyser la sortie de concentration dans l'air obtenue à partir de ces analyses et a estimé les paramètres du rejet.

Ce modèle, appelée splines de régression adaptative multivariée bayésienne (BMARS), était le sujet de la thèse de Francom, qu'il a récemment défendu avec succès. BMARS est un outil très puissant pour l'analyse de simulations telles que celles obtenues par Simpson et Lucas. Parce qu'il s'agit d'un modèle statistique, il ne produit pas seulement des estimations ponctuelles de quantités d'intérêt, mais fournit également une description complète de l'incertitude dans ces estimations, ce qui est crucial pour la prise de décision dans le contexte de la réponse d'urgence. De plus, BMARS était particulièrement bien adapté pour le grand nombre d'exécutions de ce problème car, comparé à la plupart des modèles statistiques utilisés pour émuler la sortie informatique, il est bien meilleur pour gérer des quantités massives de données.

"Nous avons pu résoudre le problème inverse de trouver d'où vient le matériau sur la base des modèles avancés et des instruments sur le terrain, " dit Francom. " On pourrait dire, "Cela venait de cette région et c'était sur cette période et c'est la quantité qui a été libérée." Plus important encore, nous pourrions le faire assez précisément et donner une marge d'erreur associée à nos estimations. Il s'agit d'un cadre entièrement probabiliste, donc l'incertitude s'est propagée à chaque étape du chemin."

Étonnamment, l'emplacement suggéré par la méthode de Francom était en conflit avec les informations contenues dans les rapports techniques de l'expérience. Cela a fait l'objet d'une enquête plus approfondie, qui a révélé une divergence dans l'enregistrement des coordonnées lorsque le test de 1986 a été effectué.

"Quand nous sommes revenus et avons regardé l'emplacement enregistré de la sortie de 1986, il ne semblait pas correspondre à la description qualitative des chercheurs, " a déclaré Francom. "Notre prédiction a suggéré que la description qualitative de l'emplacement était plus probable que l'emplacement de libération enregistré. On ne s'attendait pas à trouver ça. C'était chouette de voir que nous pouvions trouver l'éventuelle inexactitude dans les dossiers, et apprenez ce que nous pensons être le véritable emplacement grâce à nos modèles de dispersion des particules et à l'émulateur statistique."

"Cette analyse est un exemple très puissant des modèles physiques, Méthodes statistiques, données et arsenal informatique moderne réunis pour apporter des réponses significatives à des questions impliquant des phénomènes complexes, " a déclaré Bulaevskaya. "Sans toutes ces pièces, il aurait été impossible d'obtenir des estimations précises des caractéristiques de rejet et de décrire correctement le degré de confiance que nous avons dans ces valeurs."

Lucas a déclaré que les chercheurs aimeraient éventuellement avoir un modèle qui puisse fonctionner rapidement car dans un événement réel, ils auraient besoin de savoir quand et où la libération s'est produite et combien a été libérée immédiatement. "Émulateurs rapides, tels que BMARS, nous donnent la possibilité d'obtenir des estimations de ces quantités assez rapidement, " dit Lucas. " Si du matériel radiologique est libéré dans l'atmosphère et détecté par des capteurs sous le vent, l'émulateur pourrait donner des informations sur les zones dangereuses et pourrait potentiellement sauver des vies."

Francom se rendra au Laboratoire national de Los Alamos pour poursuivre ses travaux sur les émulateurs statistiques pour l'analyse de codes informatiques complexes. Lucas et Simpson, avec Cameron-Smith et Baskett, avoir un article sur la modélisation inverse des données de Diablo Canyon qui est en cours de révision pour la revue Chimie et physique de l'atmosphère . Francom et ses co-auteurs ont soumis un autre article, en se concentrant sur BMARS dans ce problème, à un journal de statistiques et fait l'objet d'un examen par les pairs.