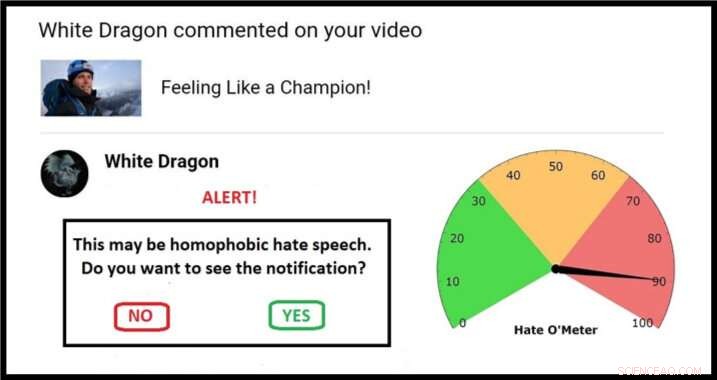

Exemple d'une approche possible pour un écran de quarantaine, complet avec Hate O'Meter. Crédit :Stefanie Ullman

La propagation du discours de haine via les médias sociaux pourrait être combattue en utilisant la même approche de « quarantaine » déployée pour lutter contre les logiciels malveillants, selon les chercheurs de l'Université de Cambridge.

Les définitions du discours de haine varient selon les pays, loi et plateforme, et le simple blocage des mots-clés est inefficace :les descriptions graphiques de la violence n'ont pas besoin de contenir des insultes ethniques évidentes pour constituer des menaces de mort racistes, par exemple.

En tant que tel, les discours de haine sont difficiles à détecter automatiquement. Il doit être signalé par les personnes qui y sont exposées, après que le « préjudice psychologique » prévu a été infligé, avec des armées de modérateurs nécessaires pour juger chaque cas.

C'est la nouvelle ligne de front d'un débat ancien :la liberté d'expression contre un langage empoisonné.

Maintenant, un ingénieur et un linguiste ont publié une proposition dans la revue Éthique et technologies de l'information qui exploite les techniques de cybersécurité pour donner le contrôle aux personnes ciblées, sans recourir à la censure.

Les experts en langues et en apprentissage automatique de Cambridge utilisent des bases de données de menaces et d'insultes violentes pour créer des algorithmes qui peuvent fournir un score pour la probabilité d'un message en ligne contenant des formes de discours haineux.

Au fur et à mesure que ces algorithmes s'affinent, les discours de haine potentiels pourraient être identifiés et « mis en quarantaine ». Les utilisateurs recevraient une alerte d'avertissement avec un "Hate O'Meter" - le score de gravité du discours de haine - le nom de l'expéditeur, et une option pour afficher le contenu ou supprimer invisible.

Cette approche s'apparente aux filtres anti-spam et anti-malware, et les chercheurs du projet « Giving Voice to Digital Democracies » pensent que cela pourrait réduire considérablement le nombre de discours de haine que les gens sont obligés de subir. Ils visent à avoir un prototype prêt au début de 2020.

« Le discours de haine est une forme de préjudice intentionnel en ligne, comme les logiciels malveillants, et peut donc être traité par mise en quarantaine, " a déclaré la co-auteur et linguiste Dr Stefanie Ullman. " En fait, beaucoup de discours de haine sont en fait générés par des logiciels tels que les bots Twitter."

« Des entreprises comme Facebook, Twitter et Google réagissent généralement aux discours de haine, " a déclaré le co-auteur et ingénieur, le Dr Marcus Tomalin. " Cela peut convenir à ceux qui ne le rencontrent pas souvent. Pour d'autres c'est trop peu, trop tard."

« De nombreuses femmes et personnes appartenant à des groupes minoritaires aux yeux du public reçoivent des discours de haine anonymes pour avoir osé avoir une présence en ligne. Nous voyons cela dissuader les gens d'entrer ou de continuer dans la vie publique, souvent ceux de groupes ayant besoin d'une plus grande représentation, " il a dit.

L'ancienne secrétaire d'État américaine Hillary Clinton a récemment déclaré à un public britannique que les discours de haine représentaient une "menace pour les démocraties", à la suite de nombreuses femmes parlementaires citant les abus en ligne comme faisant partie des raisons pour lesquelles elles ne se présenteront plus aux élections.

Alors que dans une adresse de l'Université de Georgetown, Le PDG de Facebook, Mark Zuckerberg, a parlé de « larges désaccords sur ce qui est qualifié de haine » et a fait valoir :« nous devrions pécher par excès d'expression ».

Les chercheurs disent que leur proposition n'est pas une solution miracle, mais il se situe entre les "approches libertaires et autoritaires extrêmes" consistant à autoriser ou à interdire entièrement certains langages en ligne.

Surtout, l'utilisateur devient l'arbitre. "Beaucoup de gens n'aiment pas l'idée d'une société non élue ou d'un gouvernement micro-gérant décidant de ce que nous pouvons et ne pouvons pas nous dire, " dit Tomalin.

"Notre système signalera lorsque vous devrez faire attention, mais c'est toujours ton appel. Cela n'empêche pas les gens de publier ou de voir ce qu'ils aiment, mais cela donne un contrôle bien nécessaire à ceux qui sont inondés de haine."

Dans le journal, les chercheurs se réfèrent à des algorithmes de détection atteignant une précision de 60%, pas beaucoup mieux que le hasard. Le laboratoire d'apprentissage automatique de Tomalin a maintenant atteint 80 %, et il anticipe une amélioration continue de la modélisation mathématique.

Pendant ce temps, Ullman rassemble plus de « données d'entraînement » :des discours de haine vérifiés à partir desquels les algorithmes peuvent apprendre. Cela permet d'affiner les "scores de confiance" qui déterminent une quarantaine et une lecture ultérieure du Hate O'Meter, qui pourrait être réglé comme un cadran de sensibilité en fonction des préférences de l'utilisateur.

Un exemple de base pourrait impliquer un mot comme « salope » :une insulte misogyne, mais aussi un terme légitime dans des contextes tels que l'élevage de chiens. C'est l'analyse algorithmique de l'emplacement syntaxique d'un tel mot - les types de mots environnants et les relations sémantiques entre eux - qui informe le score du discours de haine.

"Identifier des mots clés individuels ne suffit pas, nous examinons des structures de phrases entières et bien au-delà. Les informations sociolinguistiques dans les profils d'utilisateurs et les historiques de publication peuvent toutes aider à améliorer le processus de classification, " dit Ullman.

Tomalin a ajouté :« Grâce à des quarantaines automatisées qui fournissent des conseils sur la force du contenu haineux, nous pouvons responsabiliser ceux qui sont à l'origine du discours de haine qui empoisonne nos discours en ligne. »

Cependant, les chercheurs, qui travaillent au Centre de recherche sur les arts de Cambridge, Sciences humaines et sociales (CRASSH), dire que, comme pour les virus informatiques, il y aura toujours une course aux armements entre le discours de haine et les systèmes pour le limiter.

Le projet a également commencé à examiner le « contre-discours » :les manières dont les gens réagissent au discours de haine. Les chercheurs ont l'intention d'alimenter les débats sur la façon dont les assistants virtuels tels que « Siri » devraient répondre aux menaces et à l'intimidation.