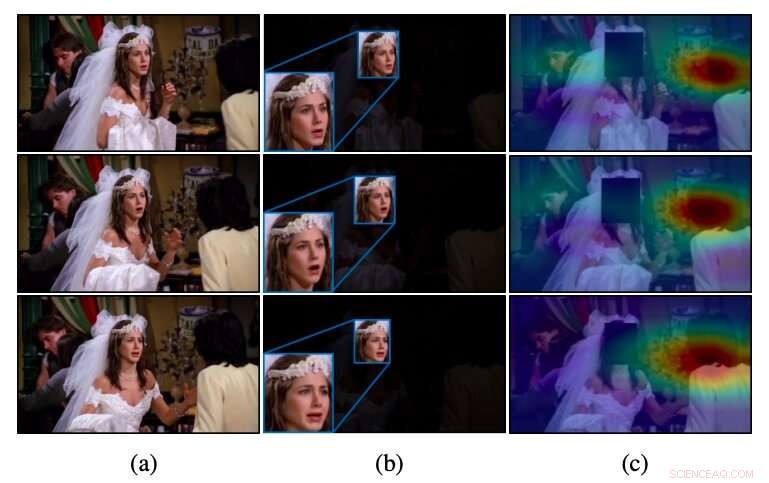

Intuition de CAER-Net pour les vidéos non rognées, comme dans (a) les méthodes conventionnelles qui exploitent uniquement les régions du visage, comme en (b), ne parviennent souvent pas à reconnaître l'émotion. Contrairement à ces méthodes, CAER-Net se concentre à la fois sur les régions de visage et de contexte attentif, comme on le voit en (c). Crédit :Lee et al.

Une équipe de chercheurs de l'Université Yonsei et de l'École Polytechnique Fédérale de Lausanne (EPFL) a récemment développé une nouvelle technique capable de reconnaître les émotions en analysant les visages des personnes dans les images ainsi que les caractéristiques contextuelles. Ils ont présenté et décrit leur architecture basée sur l'apprentissage profond, appelé CAER-Net, dans un article prépublié sur arXiv.

Pour plusieurs années, des chercheurs du monde entier ont essayé de développer des outils pour détecter automatiquement les émotions humaines en analysant des images, des vidéos ou des clips audio. Ces outils pourraient avoir de nombreuses applications, par exemple, améliorer les interactions robot-humain ou aider les médecins à identifier les signes de troubles mentaux ou neuronaux (par exemple, , basé sur des modèles de discours atypiques, traits du visage, etc.).

Jusque là, la majorité des techniques de reconnaissance des émotions dans les images sont basées sur l'analyse des expressions faciales des personnes, en supposant essentiellement que ces expressions traduisent le mieux les réponses émotionnelles des humains. Par conséquent, la plupart des ensembles de données pour la formation et l'évaluation des outils de reconnaissance des émotions (par exemple, les jeux de données AFEW et FER2013) ne contiennent que des images recadrées de visages humains.

Une limitation clé des outils conventionnels de reconnaissance des émotions est qu'ils ne parviennent pas à obtenir des performances satisfaisantes lorsque les signaux émotionnels sur les visages des personnes sont ambigus ou indiscernables. Contrairement à ces approches, les êtres humains sont capables de reconnaître les émotions des autres en fonction non seulement de leurs expressions faciales, mais aussi sur des indices contextuels (par exemple, les actions qu'ils accomplissent, leurs interactions avec les autres, où ils sont, etc.).

Des études antérieures suggèrent que l'analyse des expressions faciales et des caractéristiques contextuelles peut améliorer considérablement les performances des outils de reconnaissance des émotions. Inspiré par ces découvertes, les chercheurs de Yonsei et de l'EPFL ont entrepris de développer une architecture basée sur l'apprentissage en profondeur qui peut reconnaître les émotions des gens dans les images en fonction à la fois de leurs expressions faciales et d'informations contextuelles.

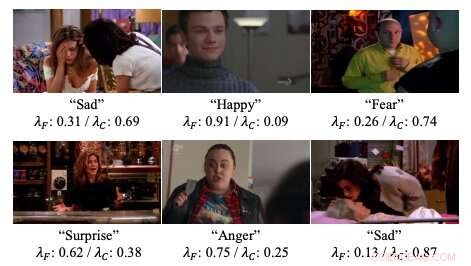

Exemples de poids d'attention dans les réseaux de neurones développés par les chercheurs. Crédit :Lee et al.

« Nous présentons des réseaux profonds pour la reconnaissance des émotions contextuelle, appelé CAER-Net, qui exploitent non seulement l'expression faciale humaine, mais aussi des informations contextuelles, de manière solidaire et dynamisante, ", écrivent les chercheurs dans leur article. "L'idée clé est de cacher des visages humains dans une scène visuelle et de rechercher d'autres contextes basés sur un mécanisme d'attention."

CAER-Net, l'architecture développée par les chercheurs, est composé de deux sous-réseaux et encodeurs clés qui extraient séparément les traits du visage et les régions contextuelles d'une image. Ces deux types de caractéristiques sont ensuite combinés à l'aide de réseaux de fusion adaptative et analysés ensemble pour prédire les émotions des personnes dans une image donnée.

En plus de CAER-Net, les chercheurs ont également introduit un nouvel ensemble de données pour la reconnaissance des émotions contextuelle, qu'ils appellent CAER. Les images de cet ensemble de données représentent à la fois les visages des personnes et leur environnement/contexte, par conséquent, il pourrait servir de référence plus efficace pour la formation à l'évaluation des techniques de reconnaissance des émotions.

Les chercheurs ont évalué leur technique de reconnaissance des émotions dans une série d'expériences, en utilisant à la fois l'ensemble de données qu'ils ont compilé et l'ensemble de données AFEW. Leurs résultats suggèrent que l'analyse des expressions faciales et des informations contextuelles peut considérablement améliorer les performances des outils de reconnaissance des émotions, comme l'indiquent les études précédentes.

"Nous espérons que les résultats de cette étude faciliteront de nouvelles avancées dans la reconnaissance des émotions contextuelle et ses tâches connexes, ", ont écrit les chercheurs.

© 2019 Réseau Science X