Crédit :Olivier, Lanillos et Cheng.

Un défi majeur pour les chercheurs en robotique est de développer des systèmes capables d'interagir avec les humains et leur environnement dans des situations impliquant divers degrés d'incertitude. En réalité, tandis que les humains peuvent continuellement apprendre de leurs expériences et percevoir leur corps dans son ensemble lorsqu'ils interagissent avec le monde, les robots n'ont pas encore ces capacités.

Des chercheurs de l'Université technique de Munich ont récemment mené une étude ambitieuse dans laquelle ils ont tenté d'appliquer « l'inférence active, " une construction théorique qui décrit la capacité d'unir perception et action, à un robot humanoïde. Leur étude fait partie d'un projet plus large financé par l'UE appelé SELFCEPTION, qui relie la robotique et la psychologie cognitive dans le but de développer des robots plus perspicaces.

"La question de recherche originale qui a déclenché ce travail était de fournir aux robots humanoïdes et aux agents artificiels en général la capacité de percevoir leur corps comme le font les humains, "Pablo Lanillos, l'un des chercheurs qui a mené l'étude, a déclaré TechXplore. "L'objectif principal était d'améliorer leurs capacités à interagir dans l'incertitude. Sous l'égide du projet Selfception.eu Marie Skłodowska-Curie, nous avons initialement défini une feuille de route pour inclure certaines caractéristiques de la perception et de l'action humaines dans les robots."

Dans leur étude, Lanillos et ses collègues ont essayé de mieux comprendre la perception humaine et l'ont ensuite modélisée en un robot humanoïde. Cela s'est avéré être une tâche très difficile, autant de détails sur la façon dont les informations sensorielles (visuelles, tactile, etc.) est traité par l'homme sont encore inconnus. Les chercheurs se sont inspirés des travaux de Hermann Von Helmholtz et Karl Friston, en particulier de leur théorie de l'inférence active, qui fait partie des constructions neuroscientifiques les plus influentes.

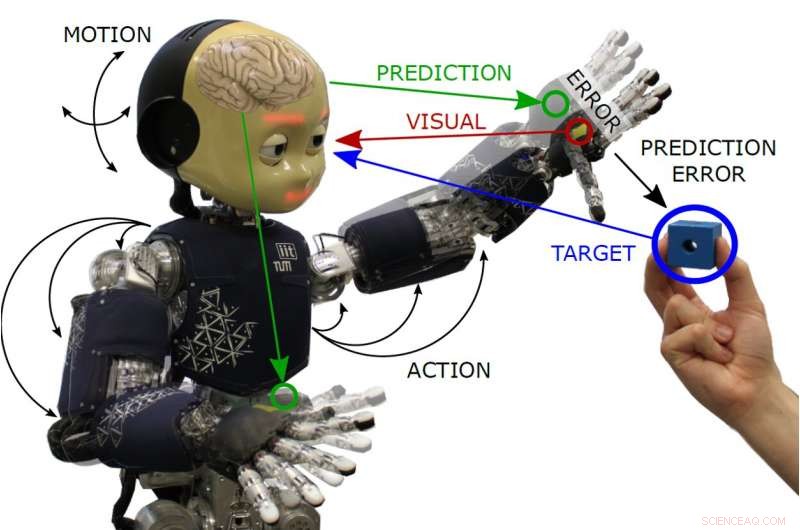

« En substance, nous proposons que le robot se rapproche continuellement de son corps en utilisant ses modèles appris imparfaits, " Guillermo Olivier, un autre chercheur impliqué dans l'étude, a déclaré TechXplore. "L'algorithme, basé sur le principe de l'énergie libre, présente la perception et l'action travaillant pour un objectif commun :réduire l'erreur de prédiction. Dans cette approche, l'action fait que les données sensorielles correspondent mieux à la prédiction faite par le modèle interne."

Lanillos, Oliver et le professeur Gordon Cheng ont été les premiers à appliquer l'inférence active à un vrai robot. En réalité, jusque là, l'inférence active n'a été testée que théoriquement ou dans des simulations partiellement biaisées par la simplification des modèles utilisés.

Leur approche tente de reproduire la capacité des humains à modifier leurs actions (par exemple leur démarche) dans des situations particulières, par exemple, lorsqu'ils s'approchent d'un escalator du métro, mais découvre soudain qu'il est cassé ou hors service, et adapter leurs mouvements en conséquence. L'algorithme de perception et de contrôle développé par Lanillos, Oliver et Cheng reproduisent un mécanisme similaire dans les robots.

Par exemple, dans une tâche d'atteinte dans laquelle un robot doit toucher un objet, le modèle crée une erreur dans l'emplacement de la main souhaité qui déclenche une action vers l'objet. L'équilibre (ou la minimisation) est obtenu lorsque la main du robot et l'objet sont au même endroit.

« Cette approche est rare dans la communauté robotique, mais offre la tractabilité, permet la combinaison d'informations sensorielles provenant de différentes sources et permet le réglage de la fiabilité de chaque information de capteur, selon la précision, ", a déclaré Olivier.

Les chercheurs ont appliqué leur algorithme à iCub, un robot humanoïde cognitif open source développé dans le cadre d'un autre projet financé par l'UE, et évalué ses performances dans des tâches qui impliquaient une extension à deux bras et un suivi actif de la tête. Dans leurs tests, le robot était capable d'effectuer des comportements d'atteinte avancés et robustes, ainsi que le suivi actif de la tête des objets dans son champ visuel.

"Le robot humanoïde était capable d'effectuer des tâches robustes d'atteinte à double bras et de suivi visuel d'un objet en utilisant le même modèle mathématique, " dit Oliver. " Avec ce type d'algorithme, nous aimerions changer la vision actuelle du pipeline de perception d'entrée-sortie (par exemple, les réseaux de neurones à la pointe de la technologie) en appliquant l'idée de la perception en boucle fermée, où les passes en avant et en arrière sont traitées en ligne, et y compris l'action comme une autre variable inévitable."

Lanillos, Oliver et Cheng sont les premiers à implémenter un modèle basé sur le principe de l'énergie libre sur un vrai robot humanoïde. Leurs résultats suggèrent que la validation de tels modèles dans des contextes réels est possible, de même que l'analyse des avantages de ces modèles en présence d'informations sensorielles bruitées, occlusions ou lorsque seules des informations partielles sont disponibles. Les chercheurs envisagent maintenant d'appliquer leur modèle à d'autres robots et de tester sa généralisabilité.

"À long terme, nous voulons permettre le développement d'agents artificiels avec les mêmes capacités d'adaptation corporelle et d'interaction que les humains, " dit Lanillos. " En attendant, nous développons de nouveaux algorithmes d'intelligence artificielle bio-inspirés. À l'avenir, nous utiliserons également ce modèle pour enquêter sur la propriété du corps et l'agence, et qui sait, nous pourrions un jour permettre l'auto-reconnaissance dans les machines."

© 2019 Réseau Science X