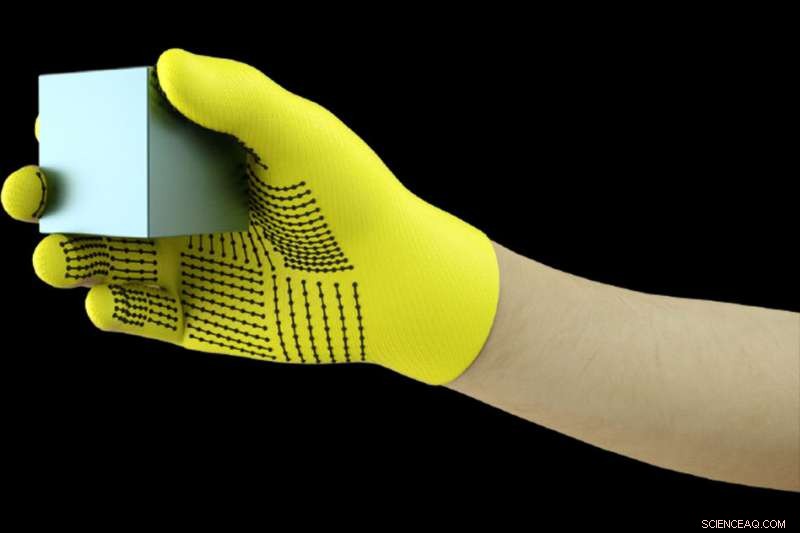

Les chercheurs du MIT ont développé un gant doté de capteurs qui capte les signaux de pression lorsque les humains interagissent avec des objets. Le gant peut être utilisé pour créer des ensembles de données tactiles haute résolution que les robots peuvent exploiter pour mieux identifier, peser, et manipuler des objets. Crédit :Massachusetts Institute of Technology

Porter un gant doté de capteurs lors de la manipulation d'une variété d'objets, Les chercheurs du MIT ont compilé un ensemble de données massif qui permet à un système d'IA de reconnaître des objets uniquement par le toucher. Les informations pourraient être exploitées pour aider les robots à identifier et à manipuler des objets, et peut aider à la conception de prothèses.

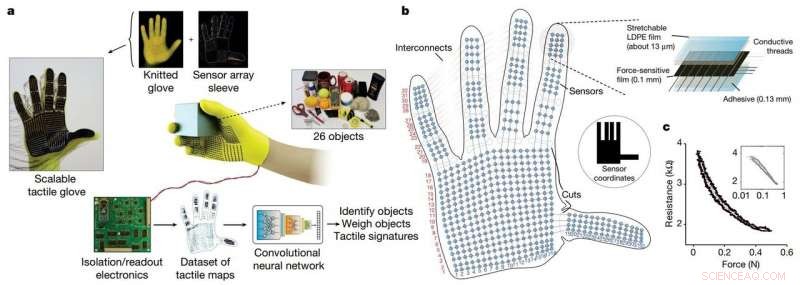

Les chercheurs ont développé un gant tricoté à faible coût, appelé « gant tactile évolutif » (STAG), équipé d'environ 550 minuscules capteurs sur presque toute la main. Chaque capteur capte les signaux de pression lorsque les humains interagissent avec les objets de diverses manières. Un réseau de neurones traite les signaux pour « apprendre » un ensemble de données de modèles de signaux de pression liés à des objets spécifiques. Puis, le système utilise cet ensemble de données pour classer les objets et prédire leur poids par sensation seule, sans entrée visuelle nécessaire.

Dans un article publié en La nature , les chercheurs décrivent un ensemble de données qu'ils ont compilé à l'aide de STAG pour 26 objets courants, dont une canette de soda, les ciseaux, balle de tennis, cuillère, stylo, et tasse. En utilisant le jeu de données, le système a prédit l'identité des objets avec une précision allant jusqu'à 76 %. Le système peut également prédire le poids correct de la plupart des objets dans un rayon d'environ 60 grammes.

Des gants similaires à base de capteurs utilisés aujourd'hui coûtent des milliers de dollars et ne contiennent souvent qu'une cinquantaine de capteurs qui capturent moins d'informations. Même si STAG produit des données à très haute résolution, il est fabriqué à partir de matériaux disponibles dans le commerce pour un total d'environ 10 $.

Le système de détection tactile pourrait être utilisé en combinaison avec la vision par ordinateur traditionnelle et des ensembles de données basés sur des images pour donner aux robots une compréhension plus humaine de l'interaction avec les objets.

« Les humains peuvent bien identifier et manipuler les objets parce que nous avons un retour tactile. Lorsque nous touchons des objets, nous sentons autour de nous et réalisons ce qu'ils sont. Les robots n'ont pas une rétroaction aussi riche, " dit Subramanian Sundaram Ph.D. '18, un ancien étudiant diplômé du Laboratoire d'Informatique et d'Intelligence Artificielle (CSAIL). "Nous avons toujours voulu que les robots fassent ce que les humains peuvent faire, comme faire la vaisselle ou d'autres tâches ménagères. Si vous voulez que les robots fassent ces choses, ils doivent être capables de très bien manipuler les objets."

Les chercheurs ont également utilisé l'ensemble de données pour mesurer la coopération entre les régions de la main lors des interactions d'objets. Par exemple, quand quelqu'un utilise l'articulation médiane de son index, ils utilisent rarement leur pouce. Mais les pointes de l'index et du majeur correspondent toujours à l'utilisation du pouce. "Nous montrons de manière quantifiable, pour la première fois, cette, si j'utilise une partie de ma main, dans quelle mesure je suis susceptible d'utiliser une autre partie de ma main, " il dit.

Les fabricants de prothèses peuvent potentiellement utiliser les informations pour, dire, choisissez les emplacements optimaux pour placer les capteurs de pression et aidez à personnaliser les prothèses en fonction des tâches et des objets avec lesquels les gens interagissent régulièrement.

Les post-doctorants du CSAIL Petr Kellnhofer et Jun-Yan Zhu se joindront à Sundaram sur le papier; Yunzhu Li, étudiant diplômé du CSAIL; Antonio Torralba, professeur à EECS et directeur du MIT-IBM Watson AI Lab; et Wojciech Matusik, professeur agrégé en génie électrique et en informatique et chef du groupe Fabrication informatique.

Le STAG comme plate-forme pour apprendre de l'emprise humaine. Crédit: La nature (2019). DOI :10.1038/s41586-019-1234-z

STAG est laminé avec un polymère électriquement conducteur qui modifie la résistance à la pression appliquée. Les chercheurs ont cousu des fils conducteurs à travers des trous dans le film polymère conducteur, du bout des doigts à la base de la paume. Les fils se chevauchent d'une manière qui les transforme en capteurs de pression. Quand quelqu'un qui porte le gant sent, ascenseurs, détient, et laisse tomber un objet, les capteurs enregistrent la pression en chaque point.

Les fils se connectent du gant à un circuit externe qui traduit les données de pression en "cartes tactiles, " qui sont essentiellement de brèves vidéos de points qui grandissent et rétrécissent sur le graphique d'une main. Les points représentent l'emplacement des points de pression, et leur taille représente la force - plus le point est gros, plus la pression est grande.

A partir de ces cartes, les chercheurs ont compilé un ensemble de données d'environ 135, 000 images vidéo issues d'interactions avec 26 objets. Ces trames peuvent être utilisées par un réseau de neurones pour prédire l'identité et le poids des objets, et fournir des informations sur l'emprise humaine.

Pour identifier des objets, les chercheurs ont conçu un réseau de neurones convolutifs (CNN), qui est généralement utilisé pour classer les images, pour associer des modèles de pression spécifiques à des objets spécifiques. Mais l'astuce consistait à choisir des cadres parmi différents types de prises pour obtenir une image complète de l'objet.

L'idée était d'imiter la façon dont les humains peuvent tenir un objet de différentes manières afin de le reconnaître, sans utiliser leur vue. De la même manière, le CNN des chercheurs choisit jusqu'à huit images semi-aléatoires de la vidéo qui représentent les prises les plus dissemblables, disons, tenant une tasse par le bas, Haut, et poignée.

Mais le CNN ne peut pas simplement choisir des images aléatoires parmi les milliers de chaque vidéo, ou il ne choisira probablement pas des poignées distinctes. Au lieu, il regroupe des cadres similaires, résultant en des groupes distincts correspondant à des saisies uniques. Puis, il extrait une image de chacun de ces clusters, s'assurer qu'il dispose d'un échantillon représentatif. Ensuite, le CNN utilise les modèles de contact qu'il a appris lors de la formation pour prédire une classification d'objets à partir des trames choisies.

"Nous voulons maximiser la variation entre les trames pour donner la meilleure entrée possible à notre réseau, ", dit Kellnhofer. "Tous les cadres à l'intérieur d'un seul groupe devraient avoir une signature similaire qui représente les mêmes manières de saisir l'objet. L'échantillonnage à partir de plusieurs clusters simule un humain essayant de manière interactive de trouver différentes prises tout en explorant un objet."

Pour l'estimation du poids, les chercheurs ont construit un ensemble de données distinct d'environ 11, 600 images de cartes tactiles d'objets saisis par le doigt et le pouce, tenu, et a chuté. Notamment, le CNN n'a été formé sur aucune trame sur laquelle il a été testé, ce qui signifie qu'il ne pouvait pas apprendre à associer simplement le poids à un objet. En test, une seule trame a été entrée dans le CNN. Essentiellement, le CNN détecte la pression autour de la main causée par le poids de l'objet, et ignore la pression causée par d'autres facteurs, comme le positionnement de la main pour empêcher l'objet de glisser. Ensuite, il calcule le poids en fonction des pressions appropriées.

Le système pourrait être combiné avec les capteurs déjà installés sur les articulations des robots qui mesurent le couple et la force pour les aider à mieux prédire le poids de l'objet. "Les articulations sont importantes pour prédire le poids, mais il y a aussi des éléments importants du poids du bout des doigts et de la paume que nous capturons, " dit Sundaram.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.