Crédit :Marat Marihal/Shutterstock

Depuis que les entreprises ont commencé à développer des voitures autonomes, les gens ont demandé comment les concepteurs répondraient à la question morale de savoir qui une voiture autonome devrait tuer si un accident mortel est inévitable. Des recherches récentes suggèrent que cette question peut être encore plus difficile à répondre pour les constructeurs automobiles qu'on ne le pensait auparavant, car les préférences morales des gens varient beaucoup d'un pays à l'autre.

Les chercheurs, basé à l'Université Harvard et au MIT, a développé un jeu en ligne simulant des situations où un accident de voiture mortel était inévitable. Ils ont demandé à environ 40 millions de personnes de plus de 200 pays de choisir entre divers résultats d'accidents, comme tuer des piétons plutôt que des passagers de la voiture.

Les résultats ont révélé trois groupes culturels où il y avait des différences significatives dans les préférences éthiques des gens. Par exemple, dans le cluster sud (qui comprenait la majeure partie de l'Amérique latine et quelques anciennes colonies françaises), il y avait une forte préférence pour épargner les femmes par rapport aux hommes. Le cluster oriental (qui comprenait de nombreux pays islamiques ainsi que la Chine, Japon et Corée) avaient une préférence moindre pour épargner les jeunes par rapport aux personnes plus âgées.

Les chercheurs ont conclu en disant que ces informations devraient influencer les développeurs de voitures autonomes. Mais est-ce vraiment le cas ? Alors que cet article met en lumière une découverte intéressante sur les variations globales des préférences morales, il met également en évidence un malentendu persistant sur l'IA, et ce qu'il peut réellement faire. Compte tenu de la technologie d'IA actuelle utilisée dans les voitures autonomes, l'idée qu'un véhicule puisse prendre une décision morale est en réalité impossible.

Le fantasme de la "machine morale"

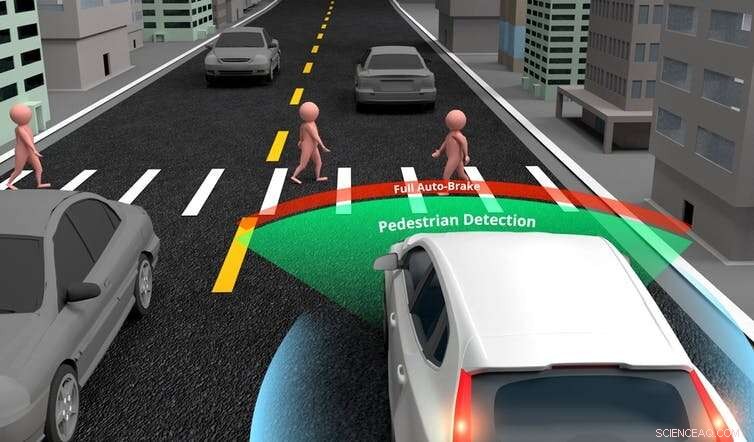

Les voitures autonomes sont formées pour prendre des décisions sur où diriger ou quand freiner, en utilisant une IA spécifique (ou faible) (intelligence artificielle qui se concentre sur l'accomplissement d'une tâche étroite). Ils sont conçus avec une gamme de capteurs, caméras et lasers de mesure de distance (lidar), qui donnent des informations à un ordinateur central. L'ordinateur utilise ensuite l'IA pour analyser ces entrées et prendre une décision.

Bien que la technologie soit actuellement relativement simple, les voitures finiront par surpasser les humains dans ces tâches de conduite de base. Cependant, il est irréaliste de penser que les voitures autonomes devraient également être capables de prendre une décision éthique que même le plus moral des êtres humains n'aurait pas le temps de prendre dans un scénario d'accident. Une voiture devrait être programmée avec une IA générale si on s'attendait à ce qu'elle le fasse.

Une IA spécifique permet aux voitures autonomes de porter des jugements de base sur les objets dans leur environnement. Crédit :Akarat Phasura/Shutterstock

L'IA générale est l'équivalent de ce qui fait de nous des humains. C'est la capacité de converser, profite de la musique, trouver des choses amusantes ou porter des jugements moraux. Produire une IA générale est actuellement impossible en raison de la complexité de la pensée et des émotions humaines. Si nous avons besoin de véhicules autonomes moraux nous n'y arriverons pas avant plusieurs décennies, si jamais.

Un autre problème avec la nouvelle recherche était que bon nombre des situations que les participants devaient juger étaient irréalistes. Dans un scénario faisant écho au fameux « problème du chariot », On a demandé aux participants qui la voiture devait tuer si ses freins venaient à défaillir :ses trois passagers (un homme adulte, une femme adulte et un garçon) ou trois piétons âgés (deux hommes et une femme).

Les gens peuvent examiner attentivement ce genre de problèmes lorsqu'ils répondent à un questionnaire. Mais dans la plupart des accidents de la vie réelle, un conducteur n'aurait pas le temps de porter de tels jugements en une fraction de seconde avant que cela ne se produise. Cela signifie que la comparaison est invalide. Et compte tenu de la technologie d'IA actuelle des voitures autonomes, ces véhicules ne pourront pas non plus porter ces jugements.

Les voitures autonomes actuelles ont des capacités de détection sophistiquées et peuvent distinguer les piétons des autres objets, comme des lampadaires ou des panneaux de signalisation. Cependant, les auteurs de la recherche suggèrent que les voitures autonomes peuvent, pourra et peut-être devrait-il pouvoir faire des distinctions plus poussées. Par exemple, ils pourraient reconnaître les personnes jugées plus souhaitables pour la société, comme les médecins ou les athlètes, et choisissez de les enregistrer dans un scénario de crash.

La réalité est que concevoir des voitures pour porter des jugements aussi avancés impliquerait de produire une IA générale, ce qui est actuellement impossible. Il y a aussi la question de savoir si cela est même souhaitable. S'il est un jour possible de programmer une voiture pour décider quelle vie doit être sauvée, ce n'est pas quelque chose que je crois que nous devrions permettre. Nous ne devrions pas permettre les préférences identifiées dans la recherche, quelle que soit la taille de l'échantillon, pour déterminer la valeur d'une vie.

Dans leur forme la plus basique, les voitures autonomes sont conçues pour éviter les accidents si elles le peuvent, et minimiser la vitesse à l'impact s'ils ne le peuvent pas. Même si, comme les humains, ils ne sont pas capables de prendre une décision morale avant un accident inévitable. Mais les voitures autonomes seront plus sûres que les conducteurs humains, comme ils sont plus attentifs, peut réagir plus rapidement et utilisera pleinement les capacités du système de freinage en cas d'accident.

Actuellement, le plus grand défi éthique auquel sont confrontés les concepteurs de voitures autonomes est de déterminer s'il existe suffisamment de preuves d'un comportement sûr à partir de simulations et d'essais contrôlés sur route pour introduire des voitures autonomes sur la route. Mais cela ne veut pas dire qu'ils sont "moraux", ou le sera bientôt. Dire cela, c'est confondre l'IA spécifique des tâches de conduite avec l'IA générale, qui n'existera probablement pas de notre vivant.

Finalement, Les voitures autonomes seront plus sûres que les humains. Ils y parviendront grâce à la conception et en évitant les accidents dans la mesure du possible, et réduire les dommages là où il n'y en a pas. Cependant, les voitures ne seront pas capables de prendre des décisions morales que même nous ne pourrions pas. Cette notion reste un fantasme tiré par les cheveux, et pas un pour lequel nous devrions avoir de l'espoir. Au lieu, concentrons-nous sur la sécurité :quelque chose dans lequel nous pourrons avoir une confiance justifiée.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.