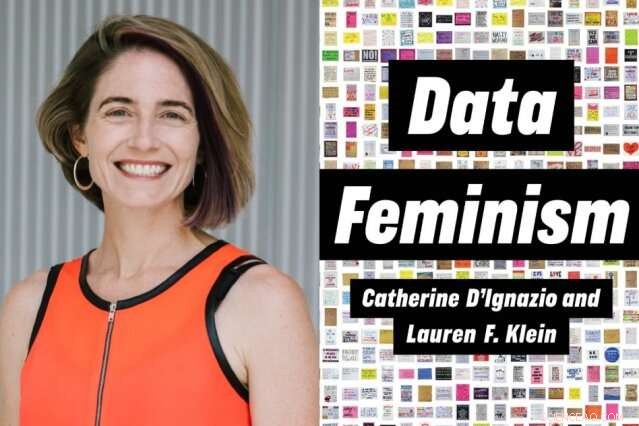

Crédit :Diana Levine et MIT Press

Supposons que vous vouliez connaître les taux de mortalité des femmes pendant l'accouchement, par pays, autour du monde. Où chercheriez-vous ? Une option est le projet WomanStats, le site Web d'un effort de recherche universitaire sur les liens entre la sécurité et les activités des États-nations, et la sécurité des femmes qui y vivent.

Le projet, fondée en 2001, répond à un besoin en rassemblant des données du monde entier. De nombreux pays sont indifférents à la collecte de statistiques sur la vie des femmes. Mais même lorsque les pays s'efforcent de recueillir des données, il y a des défis évidents pour arriver à des chiffres utiles, qu'il s'agisse de la sécurité physique des femmes, droits de propriété, et la participation du gouvernement, parmi de nombreux autres problèmes.

Par exemple :dans certains pays, les violations des droits des femmes peuvent être signalées plus régulièrement qu'en d'autres endroits. Cela signifie qu'un système juridique plus réactif peut créer l'apparence de problèmes plus graves, lorsqu'il offre un soutien relativement plus important aux femmes. Le projet WomanStats note de nombreuses complications de ce type.

Ainsi, le projet WomanStats offre quelques réponses, par exemple, Australie, Canada, et une grande partie de l'Europe occidentale a de faibles taux de mortalité à l'accouchement, tout en montrant également les défis à relever pour prendre les chiffres pour argent comptant. Cette, selon la professeure du MIT Catherine D'Ignazio, rend le site atypique, et précieux.

"Les données ne parlent jamais d'elles-mêmes, " dit D'Ignazio, se référant au problème général de trouver des chiffres fiables sur la vie des femmes. "Il y a toujours des humains et des institutions qui parlent pour les données, et différentes personnes ont leurs propres agendas. Les données ne sont jamais innocentes."

Maintenant D'Ignazio, professeur assistant au département d'études urbaines et de planification du MIT, a approfondi cette question dans un nouveau livre, co-écrit avec Lauren Klein, professeur agrégé d'anglais et de théorie et méthodes quantitatives à l'Université Emory. Dans le livre, " Data Féminisme, " publié ce mois-ci par le MIT Press, les auteurs utilisent le prisme du féminisme intersectionnel pour examiner comment la science des données reflète les structures sociales dont elle émerge.

"Le féminisme intersectionnel examine le pouvoir inégal, " écrivent D'Ignazio et Klein, dans l'introduction du livre. « Et dans notre monde contemporain, les données c'est aussi le pouvoir. Parce que le pouvoir des données est exercé injustement, elle doit être remise en cause et changée."

Le problème des 4 pour cent

Pour voir un cas clair de relations de pouvoir générant des données biaisées, D'Ignazio et Klein notent, envisager la recherche menée par Joy Buolamwini du MIT, qui, en tant qu'étudiant diplômé dans une classe étudiant les programmes de reconnaissance faciale, observé que le logiciel en question ne pouvait pas « voir » son visage. Buolamwini a découvert que pour le système de reconnaissance faciale en question, le logiciel était basé sur un ensemble de visages composés à 78 % d'hommes et à 84 % de blancs; seulement 4% étaient des femmes et à la peau foncée, comme elle-même.

La couverture médiatique ultérieure du travail de Buolamwini, D'Ignazio et Klein écrivent, contenait "un soupçon de choc". Mais les résultats étaient probablement moins surprenants pour ceux qui ne sont pas des hommes blancs, ils pensent.

« Si le passé est raciste, oppressif, sexiste, et biaisé, et ce sont vos données d'entraînement, c'est ce que vous recherchez, " dit D'Ignazio.

Ou considérons un autre exemple, du géant de la technologie Amazon, qui a testé un système automatisé utilisant l'IA pour trier les CV prometteurs envoyés par les candidats. Un problème :parce qu'un pourcentage élevé d'employés de l'entreprise étaient des hommes, l'algorithme privilégiait les prénoms masculins, toutes choses étant égales par ailleurs.

"Ils pensaient que cela aiderait [le] processus, mais bien sûr, ce qu'il fait, c'est former le [système] d'IA à être biaisé envers les femmes, parce qu'eux-mêmes n'ont pas embauché autant de femmes, " D'Ignazio observe.

Au crédit d'Amazon, il a reconnu le problème. De plus, D'Ignazio note, ce genre de problème est un problème qui peut être résolu. « Certaines technologies peuvent être réformées avec un processus plus participatif, ou de meilleures données d'entraînement. … Si nous sommes d'accord, c'est un bon objectif, une voie à suivre consiste à ajuster votre ensemble d'entraînement et à inclure plus de personnes de couleur, plus de femmes."

« Qui fait partie de l'équipe ? Qui a eu l'idée ? À qui en profite ? »

Toujours, la question de savoir qui participe à la science des données est, comme l'écrivent les auteurs, "l'éléphant dans la salle des serveurs." En 2011, seulement 26 pour cent de tous les étudiants de premier cycle recevant des diplômes en informatique aux États-Unis étaient des femmes. Ce n'est pas seulement un chiffre bas, mais en réalité une baisse par rapport aux niveaux antérieurs :en 1985, 37 pour cent des diplômés en informatique étaient des femmes, la note la plus élevée jamais enregistrée.

En raison du manque de diversité dans le domaine, D'Ignazio et Klein croient, de nombreux projets de données sont radicalement limités dans leur capacité à voir toutes les facettes des situations sociales complexes qu'ils prétendent mesurer.

"Nous voulons essayer de mettre les gens à l'écoute de ce genre de relations de pouvoir et pourquoi elles sont si importantes, " D'Ignazio dit. " Qui fait partie de l'équipe ? Qui a eu l'idée ? A qui profite le projet ? Qui est potentiellement lésé par le projet ? »

Dans tout, D'Ignazio et Klein exposent sept principes du féminisme des données, d'examiner et de contester le pouvoir, à repenser les systèmes binaires et les hiérarchies, et embrasser le pluralisme. (Ces statistiques sur le sexe et les diplômés en informatique sont limitées, ils notent, en n'utilisant que les catégories "homme" et "femme", excluant ainsi les personnes qui s'identifient en des termes différents.)

Les personnes intéressées par le féminisme des données, les auteurs déclarent, devrait également « valoriser de multiples formes de connaissances, " y compris des connaissances de première main qui peuvent nous amener à remettre en question des données apparemment officielles. ils doivent toujours tenir compte du contexte dans lequel les données sont générées, et « rendre le travail visible » en matière de science des données. Ce dernier principe, les chercheurs notent, parle du problème que même lorsque les femmes et d'autres personnes exclues contribuent aux projets de données, ils reçoivent souvent moins de crédit pour leur travail.

Pour toute la critique du livre des systèmes existants, programmes, et pratiques, D'Ignazio et Klein prennent également soin d'inclure des exemples de efforts fructueux, comme le projet WomanStats, qui a grandi et prospéré pendant deux décennies.

"Pour les gens qui sont des gens de données mais qui sont nouveaux dans le féminisme, nous voulons leur offrir une introduction très accessible, et leur donner des concepts et des outils qu'ils peuvent utiliser dans leur pratique, " D'Ignazio dit. "Nous n'imaginons pas que les gens ont déjà le féminisme dans leur boîte à outils. D'autre part, nous essayons de parler à des gens qui sont très à l'écoute du féminisme ou des principes de justice sociale, et mettre en évidence pour eux en quoi la science des données est à la fois problématique, mais peut être mis au service de la justice."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.