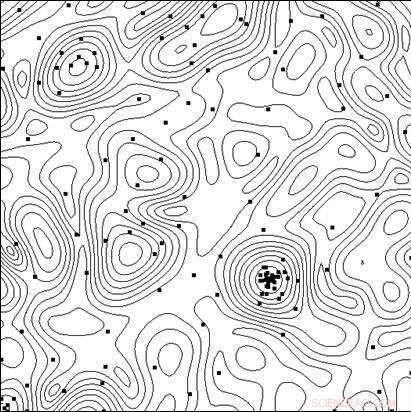

Les lignes du niveau de la fonction objectif et les points des tests effectués par l'algorithme en train de trouver le minimum. Crédit :Université Lobatchevsky

Pour créer des systèmes techniques et des processus technologiques hautement efficaces, outre l'utilisation de nouveaux principes, nouveaux matériaux, de nouveaux effets physiques et d'autres solutions qui déterminent la structure globale de l'objet en cours de création, les chercheurs doivent choisir la meilleure combinaison des paramètres de l'objet (dimensions géométriques, Caractéristiques électriques, etc.), car toute modification des paramètres avec une structure d'objet globale fixe peut avoir un impact significatif sur les indicateurs d'efficacité.

En conception assistée par ordinateur, le test des options peut être effectué en analysant son modèle mathématique pour différentes valeurs de paramètres. Les modèles devenant de plus en plus complexes, le besoin se fait sentir d'un choix ciblé d'options dans la recherche de la solution optimale (la plus efficace).

Une équipe de scientifiques de l'Université d'État Lobatchevsky de Nijni Novgorod (UNN) dirigée par le professeur Roman Strongin a étudié les choix ciblés lors de la recherche de la solution optimale. Il s'agit d'une analyse d'un sous-ensemble des options possibles dans le but d'exclure les cas manifestement peu prometteurs et de concentrer la recherche sur le sous-ensemble contenant la meilleure option.

"Lorsque les modèles mathématiques des processus qui se produisent dans un objet deviennent plus compliqués, les caractéristiques d'efficacité ne posséderont pas la propriété de monotonie, c'est pourquoi les méthodes de recherche locale sont insuffisantes pour évaluer la meilleure option, ", explique le professeur Roman Strongin.

Les procédures de recherche globale qui sont utilisées dans de tels problèmes (également appelées problèmes d'optimisation multi-extrémaux) assurent que la recherche est ciblée en tenant compte du caractère limité du changement des caractéristiques de l'objet lorsque les changements de ses paramètres sont limités. La formulation mathématique résultante peut prendre la forme de la condition de Lipschitz, la condition uniforme de Hölder, etc.

Les problèmes d'optimisation multi-extrémaux offrent un champ étroit d'opportunités de recherche analytique, et ils deviennent coûteux en temps de calcul lors de la recherche de solutions numériques, puisque les coûts de calcul augmentent de façon exponentielle avec la dimension croissante du problème.

Selon Konstantin Barkalov, Professeur agrégé du Département UNN des technologies logicielles et des superordinateurs, l'utilisation de systèmes informatiques parallèles modernes élargit la portée des méthodes d'optimisation globale. Cependant, à la fois, cela pose le défi de paralléliser efficacement le processus de recherche.

« C'est pourquoi les principaux efforts dans ce domaine devraient être concentrés sur le développement de méthodes parallèles efficaces pour résoudre numériquement des problèmes d'optimisation multi-extrémaux et sur la création de logiciels appropriés pour les systèmes informatiques modernes sur la base de telles méthodes, " dit Barkalov.

D'habitude, les méthodes d'optimisation globale (à la fois séquentielles et parallèles) sont destinées à résoudre un seul problème d'optimisation. Pour résoudre une série de q problèmes, les problèmes de la série sont résolus séquentiellement, l'un après l'autre. Par conséquent, l'estimation optimale dans le i-ième problème de la série reste indéfinie jusqu'à ce que tous les problèmes précédents de la série (avec les indices 1, 2, . . . , je ? 1) ont été complètement résolus. En cas de ressources de calcul limitées, les estimations optimales dans les problèmes i + 1, . . . , q ne sera pas obtenu si les ressources de calcul sont épuisées lors de la résolution du ième problème.

Les situations où une série de q problèmes doivent être résolus ne sont pas extraordinaires. Par exemple, une série de problèmes scalaires se pose lors de la recherche d'un ensemble de Pareto dans la résolution de problèmes d'optimisation multi-objectifs. Dans ce cas, la solution d'un problème scalaire unique correspond à l'un des points optimaux de Pareto d'un problème multi-objectifs. Une série de problèmes d'optimisation se pose également lors de l'utilisation de méthodes de réduction de dimension pour résoudre des problèmes d'optimisation multidimensionnels. Finalement, une série de problèmes de test peut également être obtenue à l'aide d'un générateur de problèmes de test particulier.

Les scientifiques pensent que lors de la résolution d'un ensemble de problèmes, il est nécessaire d'avoir des estimations initiales des solutions pour tous les problèmes à la fois, de sorte qu'à tout moment, il est possible d'évaluer l'opportunité de poursuivre la recherche. Dans ce cas, il est souhaitable d'avoir les estimations optimales pour tous les problèmes avec la même précision.

Exécution de nombreux processus indépendants dans un système informatique parallèle, chacun des processus résolvant un problème d'une série, présente un certain nombre d'inconvénients. D'abord, un déséquilibre de la charge de travail entre les processeurs se produira. Si la résolution du i -ième problème nécessite considérablement moins d'itérations de la méthode que la résolution du j -ième problème, le processeur chargé de gérer le problème i resterait inactif une fois la tâche terminée. Seconde, les estimations des optima seront obtenues avec une précision différente dans différents problèmes. Des problèmes plus simples seront résolus avec une plus grande précision, tandis que la précision sera plus faible pour des problèmes plus complexes.

L'objectif des recherches menées à l'Université Lobatchevsky était de développer une nouvelle méthode pour résoudre une série de problèmes d'optimisation globale qui assurerait :(i) un chargement uniforme de tous les cœurs/processeurs employés; (ii) une convergence uniforme vers les solutions de tous les problèmes de la série.

Dans la partie théorique de leur article, Les scientifiques de l'UNN ont également prouvé le théorème de la convergence uniforme du nouvel algorithme. La partie expérimentale du travail a consisté à résoudre une série de plusieurs centaines de problèmes tests de différentes dimensions, et les résultats ont démontré de façon convaincante la présence d'une convergence uniforme.

Les scientifiques de l'UNN envisagent également des problèmes d'optimisation globale à forte intensité de calcul, pour la résolution desquels les systèmes de calcul intensif avec des performances exaflopiques peuvent être requis. Pour surmonter une telle complexité de calcul, les chercheurs proposent des schémas de calcul parallèles généralisés, ce qui peut impliquer de nombreux algorithmes parallèles efficaces d'optimisation globale. Les schémas proposés incluent des méthodes de décomposition à plusieurs niveaux de calculs parallèles pour garantir l'efficacité de calcul des systèmes de supercalcul avec des multiprocesseurs à mémoire partagée et distribuée utilisant des milliers de processeurs pour relever les défis d'optimisation globale.