Une nouvelle étude de Dressel et al. montre que le logiciel COMPAS n'est pas plus précis ou juste que les prédictions faites par des personnes ayant peu ou pas d'expertise en matière de justice pénale. Crédit :Carla Schaffer / AAAS

Un outil logiciel informatique largement utilisé peut ne pas être plus précis ou juste pour prédire les comportements criminels répétés que les personnes sans expérience de la justice pénale, selon une étude du Dartmouth College.

L'analyse de Dartmouth a montré que les non-experts qui ont répondu à un sondage en ligne ont obtenu les mêmes résultats que le système logiciel COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) utilisé par les tribunaux pour aider à déterminer le risque de récidive.

L'article démontre également que bien que COMPAS utilise plus d'une centaine d'informations pour faire une prédiction, le même niveau de précision peut être atteint avec seulement deux variables - l'âge d'un accusé et le nombre de condamnations antérieures.

Selon le document de recherche, COMPAS a été utilisé pour évaluer plus d'un million de délinquants depuis sa création en 1998, avec sa composante de prédiction de la récidive utilisée depuis 2000.

L'analyse, publié dans la revue Avancées scientifiques , a été réalisée par l'équipe de recherche étudiants-professeurs de Julia Dressel et Hany Farid.

"Il est troublant de constater que les travailleurs Internet non formés peuvent fonctionner aussi bien qu'un programme informatique utilisé pour prendre des décisions qui changent la vie des accusés criminels, " dit Farid, l'Albert Bradley 1915 troisième siècle professeur d'informatique au Dartmouth College. "L'utilisation d'un tel logiciel peut ne rien faire pour aider les personnes qui pourraient se voir refuser une seconde chance par les algorithmes de la boîte noire."

Selon le journal, des outils logiciels sont utilisés en phase préliminaire, parole, et les décisions de condamnation pour prédire un comportement criminel, y compris qui est susceptible de ne pas se présenter à une audience du tribunal et qui est susceptible de récidiver à un moment donné dans le futur. Les partisans de tels systèmes soutiennent que les mégadonnées et l'apprentissage automatique avancé rendent ces analyses plus précises et moins biaisées que les prédictions faites par les humains.

"Les affirmations selon lesquelles des outils de données secrets et apparemment sophistiqués sont plus précis et justes que les humains ne sont tout simplement pas étayées par nos résultats de recherche, " dit Dressel, qui a effectué la recherche dans le cadre de sa thèse de premier cycle en informatique à Dartmouth.

Le document de recherche compare le logiciel commercial COMPAS aux travailleurs recrutés via le marché de crowdsourcing en ligne Mechanical Turk d'Amazon pour voir quelle approche est la plus précise et la plus juste pour juger de la possibilité de récidive. Aux fins de l'étude, la récidive était définie comme la commission d'un délit ou d'un crime dans les deux ans suivant la dernière arrestation d'un accusé.

Des groupes d'internautes ont vu de courtes descriptions qui incluaient le sexe d'un accusé, âge, et antécédents criminels. Les résultats humains ont ensuite été comparés aux résultats du système COMPAS qui utilise 137 variables pour chaque individu.

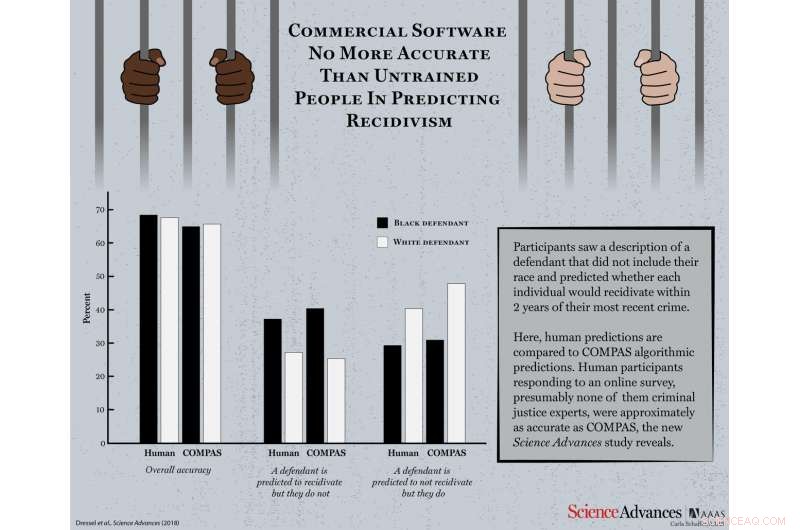

L'exactitude globale était basée sur le taux auquel un défendeur était correctement prédit qu'il récidiverait ou non. La recherche a également signalé des faux positifs - lorsqu'un accusé est censé récidiver mais ne le fait pas - et des faux négatifs - lorsqu'un accusé est censé ne pas récidiver mais le fait.

Avec beaucoup moins d'informations que COMPAS - sept fonctionnalités contre 137 - lorsque les résultats ont été regroupés pour déterminer la "sagesse de la foule, " les humains sans expérience présumée de la justice pénale étaient exacts dans 67 pour cent des cas présentés, statistiquement identique à la précision de 65,2 pour cent de COMPAS. Les participants à l'étude et COMPAS étaient d'accord pour 69,2% des 1000 accusés lorsqu'ils prédisaient qui répéterait leurs crimes.

Selon l'étude, la question de la prédiction précise de la récidive ne se limite pas à COMPAS. Un examen séparé cité dans l'étude a révélé que huit des neuf logiciels n'ont pas réussi à faire des prédictions précises.

« Toute l'utilisation d'instruments de prédiction de la récidive dans les salles d'audience devrait être remise en question, " Dressel a déclaré. " Parallèlement aux travaux antérieurs sur l'équité des algorithmes de justice pénale, ces résultats combinés jettent un doute important sur l'ensemble de l'effort de prévision de la récidive. »

Contrairement à d'autres analyses qui se concentrent sur la question de savoir si les algorithmes sont biaisés racialement, l'étude de Dartmouth examine la question plus fondamentale de savoir si l'algorithme COMPAS est meilleur que les humains non formés pour prédire la récidive de manière précise et équitable.

Cependant, quand la race était considérée, la recherche a révélé que les résultats des répondants humains et du logiciel ont montré des disparités importantes entre la façon dont les accusés noirs et blancs sont jugés.

Selon le journal, il est utile de se demander si nous mettrions ces décisions entre les mains de personnes non formées qui répondent à un sondage en ligne, car, à la fin, "les résultats de ces deux approches semblent être indiscernables."