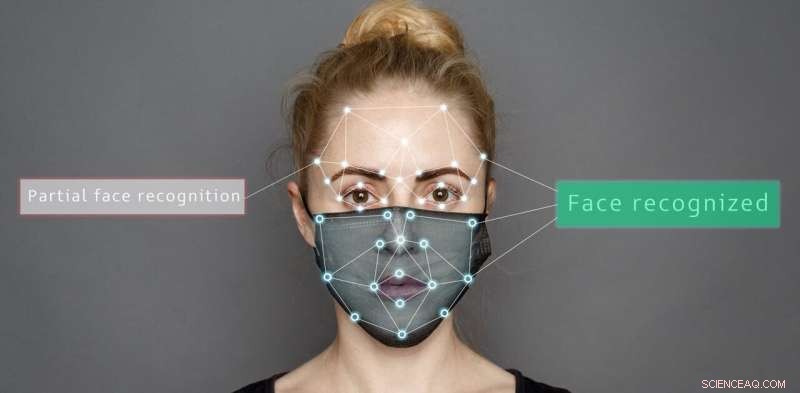

Crédit :Shutterstock/Sergey Tinyakov

Les systèmes artificiels tels que les robots de soins à domicile ou la technologie d'assistance à la conduite sont de plus en plus courants, et il est temps de déterminer si les personnes ou les algorithmes sont meilleurs pour lire les émotions, en particulier compte tenu du défi supplémentaire posé par les masques.

Dans notre étude récente, nous avons comparé la façon dont les masques faciaux ou les lunettes de soleil affectent notre capacité à déterminer différentes émotions par rapport à la précision des systèmes artificiels.

Nous avons présenté des images d'expressions faciales émotionnelles et ajouté deux types de masques différents :le masque complet utilisé par les travailleurs de première ligne et un masque récemment introduit avec une fenêtre transparente pour permettre la lecture sur les lèvres.

Nos résultats montrent que les algorithmes et les gens ont du mal lorsque les visages sont partiellement masqués. Mais les systèmes artificiels sont plus susceptibles de mal interpréter les émotions de manière inhabituelle.

Les systèmes artificiels réussissaient nettement mieux que les humains à reconnaître les émotions lorsque le visage n'était pas couvert - 98,48 % contre 82,72 % pour sept types d'émotions différents.

Mais selon le type de couverture, la précision pour les personnes et les systèmes artificiels variait. Par exemple, les lunettes de soleil obscurcissaient la peur des gens tandis que les masques partiels aidaient à la fois les gens et les systèmes artificiels à identifier correctement le bonheur.

Fait important, les gens classaient les expressions inconnues principalement comme neutres, mais les systèmes artificiels étaient moins systématiques. Ils sélectionnaient souvent de manière incorrecte la colère pour les images masquées par un masque complet, et la colère, le bonheur, le neutre ou la surprise pour les expressions partiellement masquées.

L'étude a utilisé des masques complets et partiels et des lunettes de soleil pour masquer des parties du visage. Auteur fourni

Décoder les expressions faciales

Notre capacité à reconnaître les émotions utilise le système visuel du cerveau pour interpréter ce que nous voyons. Nous avons même une zone du cerveau spécialisée dans la reconnaissance faciale, connue sous le nom de zone du visage fusiforme, qui aide à interpréter les informations révélées par les visages des personnes.

Avec le contexte d'une situation particulière (interaction sociale, parole et mouvement du corps) et notre compréhension des comportements passés et de la sympathie envers nos propres sentiments, nous pouvons décoder ce que les gens ressentent.

Un système d'unités d'action faciale a été proposé pour décoder les émotions sur la base d'indices faciaux. Il comprend des unités telles que "le soulèvement de la joue" et "l'extracteur du coin des lèvres", qui sont tous deux considérés comme faisant partie d'une expression de bonheur.

En revanche, les systèmes artificiels analysent les pixels des images d'un visage lors de la catégorisation des émotions. Ils transmettent les valeurs d'intensité des pixels à travers un réseau de filtres imitant le système visuel humain.

La découverte que les systèmes artificiels classent à tort les émotions des visages partiellement obscurcis est importante. Cela pourrait entraîner des comportements inattendus de robots interagissant avec des personnes portant des masques faciaux.

Imaginez s'ils classent à tort une émotion négative, comme la colère ou la tristesse, comme une expression émotionnelle positive. Les systèmes artificiels essaieraient d'interagir avec une personne prenant des mesures sur l'interprétation erronée dont elle est heureuse. Cela pourrait avoir des effets néfastes sur la sécurité de ces systèmes artificiels et des humains en interaction.

Pouvez-vous lire l'émotion des chercheurs sur leurs visages masqués ? Les systèmes artificiels et les personnes sont compromis dans la catégorisation des émotions lorsque les visages sont masqués. Auteur fourni

Risques liés à l'utilisation d'algorithmes pour lire les émotions

Notre recherche réitère que les algorithmes sont susceptibles de biais dans leur jugement. Par exemple, les performances des systèmes artificiels sont grandement affectées lorsqu'il s'agit de catégoriser l'émotion à partir d'images naturelles. Même l'angle ou l'ombre du soleil peut influencer les résultats.

Les algorithmes peuvent également être racistes. Comme l'ont montré des études antérieures, même une petite modification de la couleur de l'image, qui n'a rien à voir avec les expressions émotionnelles, peut entraîner une baisse des performances des algorithmes utilisés dans les systèmes artificiels.

Comme si cela ne suffisait pas, même de petites perturbations visuelles, imperceptibles à l'œil humain, peuvent amener ces systèmes à identifier à tort une entrée comme autre chose.

Certains de ces problèmes de classification erronée peuvent être résolus. Par exemple, les algorithmes peuvent être conçus pour prendre en compte des caractéristiques liées aux émotions telles que la forme de la bouche, plutôt que de glaner des informations à partir de la couleur et de l'intensité des pixels.

Une autre façon de résoudre ce problème consiste à modifier les caractéristiques des données d'entraînement, en suréchantillonnant les données d'entraînement afin que les algorithmes imitent mieux le comportement humain et commettent moins d'erreurs extrêmes lorsqu'ils classent mal une expression.

Mais dans l'ensemble, les performances de ces systèmes diminuent lors de l'interprétation d'images dans des situations réelles lorsque les visages sont partiellement couverts.

Bien que les robots puissent revendiquer une précision supérieure à celle de l'homme dans la reconnaissance des émotions pour les images statiques de visages complètement visibles, dans les situations réelles que nous vivons tous les jours, leurs performances ne sont toujours pas humaines.