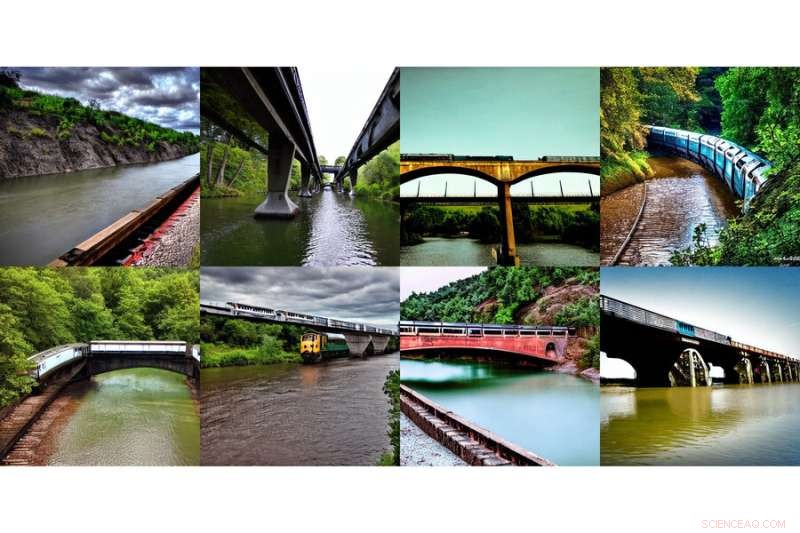

Ce tableau d'images générées, montrant "un train sur un pont" et "une rivière sous le pont", a été généré à l'aide d'une nouvelle méthode développée par des chercheurs du MIT. Crédit :Massachusetts Institute of Technology

Internet a connu un moment de bien-être collectif avec l'introduction de DALL-E, un générateur d'images basé sur l'intelligence artificielle inspiré par l'artiste Salvador Dali et l'adorable robot WALL-E qui utilise le langage naturel pour produire n'importe quelle image mystérieuse et magnifique que votre cœur désire. . Voir des entrées dactylographiées comme "gopher souriant tenant un cornet de crème glacée" prendre instantanément vie a clairement résonné avec le monde.

Faire apparaître ledit gopher souriant et ses attributs sur votre écran n'est pas une mince tâche. DALL-E 2 utilise ce qu'on appelle un modèle de diffusion, où il essaie d'encoder le texte entier en une seule description pour générer une image. Mais une fois que le texte contient beaucoup plus de détails, il est difficile pour une seule description de tout capturer. De plus, bien qu'ils soient très flexibles, ils ont parfois du mal à comprendre la composition de certains concepts, comme confondre les attributs ou les relations entre différents objets.

Pour générer des images plus complexes avec une meilleure compréhension, les scientifiques du Laboratoire d'informatique et d'intelligence artificielle du MIT (CSAIL) ont structuré le modèle typique sous un angle différent :ils ont ajouté une série de modèles ensemble, où ils coopèrent tous pour générer les images souhaitées capturant plusieurs aspects différents. comme demandé par le texte d'entrée ou les étiquettes. Pour créer une image à deux composants, disons décrite par deux phrases de description, chaque modèle s'attaquerait à un composant particulier de l'image.

Ce tableau d'images générées, montrant "une rivière menant à des montagnes" et "des arbres rouges sur le côté", a été généré à l'aide d'une nouvelle méthode développée par des chercheurs du MIT. Crédit :Institut de technologie du Massachusetts

Les modèles apparemment magiques derrière la génération d'images fonctionnent en suggérant une série d'étapes de raffinement itératives pour arriver à l'image souhaitée. Il commence par une "mauvaise" image puis l'affine progressivement jusqu'à ce qu'elle devienne l'image sélectionnée. En composant plusieurs modèles ensemble, ils affinent conjointement l'apparence à chaque étape, de sorte que le résultat est une image qui présente tous les attributs de chaque modèle. En faisant coopérer plusieurs modèles, vous pouvez obtenir des combinaisons beaucoup plus créatives dans les images générées.

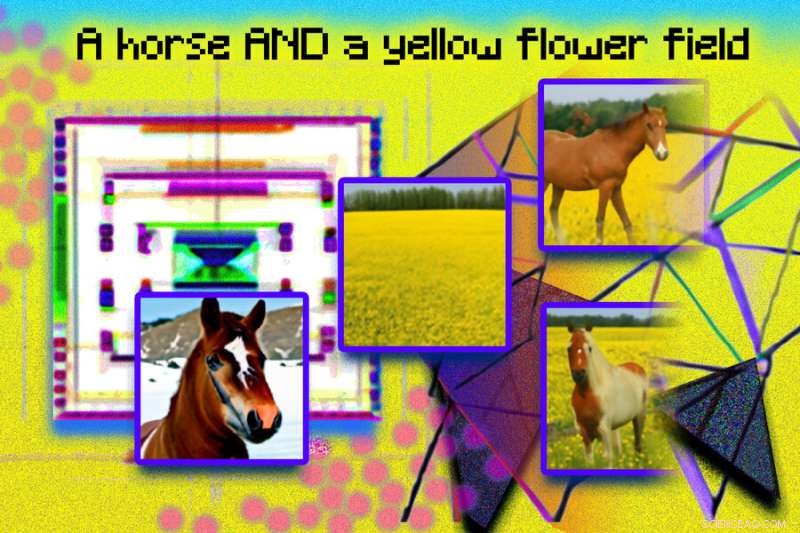

Prenez, par exemple, un camion rouge et une maison verte. Le modèle confondra les concepts de camion rouge et de maison verte lorsque ces phrases deviennent très compliquées. Un générateur typique comme DALL-E 2 pourrait faire un camion vert et une maison rouge, donc il va échanger ces couleurs. L'approche de l'équipe peut gérer ce type de liaison d'attributs avec des objets, et en particulier lorsqu'il existe plusieurs ensembles d'éléments, elle peut gérer chaque objet avec plus de précision.

"Le modèle peut modéliser efficacement les positions des objets et les descriptions relationnelles, ce qui est difficile pour les modèles de génération d'images existants. Par exemple, placez un objet et un cube dans une certaine position et une sphère dans une autre. DALL-E 2 est bon pour générer des images naturelles. images, mais a parfois du mal à comprendre les relations d'objet », déclare MIT CSAIL Ph.D. étudiant et co-auteur principal Shuang Li, "Au-delà de l'art et de la créativité, nous pourrions peut-être utiliser notre modèle pour l'enseignement. Si vous voulez dire à un enfant de mettre un cube au-dessus d'une sphère, et si nous le disons en langage, il peut être difficile à comprendre pour eux. Mais notre modèle peut générer l'image et les montrer."

Les chercheurs ont pu créer des images surprenantes et surréalistes avec le texte, "un chien" et "le ciel". Sur la gauche apparaissent un chien et des nuages séparément, étiquetés "chien" et "ciel" en dessous, et sur la droite apparaissent deux images de chiens ressemblant à des nuages avec l'étiquette "chien ET ciel" en dessous. Crédit :Institut de technologie du Massachusetts

Rendre Dali fier

Composable Diffusion, le modèle de l'équipe, utilise des modèles de diffusion aux côtés d'opérateurs de composition pour combiner des descriptions de texte sans formation supplémentaire. L'approche de l'équipe capture plus précisément les détails du texte que le modèle de diffusion original, qui encode directement les mots en une seule longue phrase. Par exemple, étant donné "un ciel rose" ET "une montagne bleue à l'horizon" ET "des fleurs de cerisier devant la montagne", le modèle de l'équipe a pu produire exactement cette image, alors que le modèle de diffusion original rendait le ciel bleu et tout devant les montagnes roses.

"Le fait que notre modèle soit composable signifie que vous pouvez apprendre différentes parties du modèle, une à la fois. Vous pouvez d'abord apprendre un objet au-dessus d'un autre, puis apprendre un objet à droite d'un autre, puis apprendre quelque chose à gauche d'un autre », déclare le co-auteur principal et Ph.D. du MIT CSAIL. étudiant Yilun Du. "Puisque nous pouvons les composer ensemble, vous pouvez imaginer que notre système nous permet d'apprendre progressivement la langue, les relations ou les connaissances, ce que nous pensons être une direction assez intéressante pour les travaux futurs."

Cette illustration photographique a été créée à partir d'images générées à partir d'un système MIT appelé Composable Diffusion, et arrangées dans Photoshop. Des expressions telles que « modèle de diffusion » et « réseau » ont été utilisées pour générer les points roses et les images angulaires géométriques. La phrase "un cheval ET un champ de fleurs jaunes" est incluse en haut de l'image. Les images générées d'un cheval et d'un champ jaune apparaissent à gauche, et l'imagerie combinée d'un cheval dans un champ de fleurs jaunes apparaît à droite. Crédit :Institut de technologie du Massachusetts

Bien qu'il ait montré des prouesses dans la génération d'images complexes et photoréalistes, il était toujours confronté à des défis car le modèle était formé sur un ensemble de données beaucoup plus petit que ceux comme DALL-E 2, il y avait donc certains objets qu'il ne pouvait tout simplement pas capturer.

Maintenant que Composable Diffusion peut fonctionner au-dessus des modèles génératifs, tels que DALL-E 2, les scientifiques veulent explorer l'apprentissage continu comme prochaine étape potentielle. Étant donné que davantage est généralement ajouté aux relations d'objet, ils veulent voir si les modèles de diffusion peuvent commencer à "apprendre" sans oublier les connaissances précédemment acquises - à un endroit où le modèle peut produire des images avec à la fois les connaissances précédentes et nouvelles.

"Cette recherche propose une nouvelle méthode pour composer des concepts dans la génération de texte à image non pas en les concaténant pour former une invite, mais plutôt en calculant des scores par rapport à chaque concept et en les composant à l'aide d'opérateurs de conjonction et de négation", explique Mark Chen, co-créateur de DALL-E 2 et chercheur à OpenAI. "C'est une bonne idée qui tire parti de l'interprétation basée sur l'énergie des modèles de diffusion afin que les anciennes idées sur la compositionnalité utilisant des modèles basés sur l'énergie puissent être appliquées. L'approche est également capable d'utiliser des conseils sans classificateur, et il est surprenant de voyez qu'il surpasse la ligne de base GLIDE sur divers critères de composition et peut produire qualitativement des types très différents de générations d'images."

"Les humains peuvent composer des scènes comprenant différents éléments d'une myriade de façons, mais cette tâche est difficile pour les ordinateurs", explique Bryan Russel, chercheur chez Adobe Systems. "Ce travail propose une formulation élégante qui compose explicitement un ensemble de modèles de diffusion pour générer une image à partir d'une invite complexe en langage naturel."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche, de l'innovation et de l'enseignement du MIT. Révolutionner la génération d'images grâce à l'IA :transformer du texte en images