Crédit :Université York

Les réseaux de neurones à convolution profonde (DCNN) ne voient pas les objets comme les humains - en utilisant la perception de forme configurale - et cela pourrait être dangereux dans les applications d'IA du monde réel, déclare le professeur James Elder, co-auteur d'une étude de l'Université York publiée aujourd'hui.

Publié dans la revue Cell Press iScience , Les modèles d'apprentissage en profondeur ne parviennent pas à saisir la nature configurale de la perception de la forme humaine est une étude collaborative menée par Elder, titulaire de la chaire de recherche de York en vision humaine et par ordinateur et codirecteur du York's Center for AI &Society, et professeur adjoint de psychologie Nicholas Baker au Loyola College de Chicago, ancien boursier postdoctoral VISTA à York.

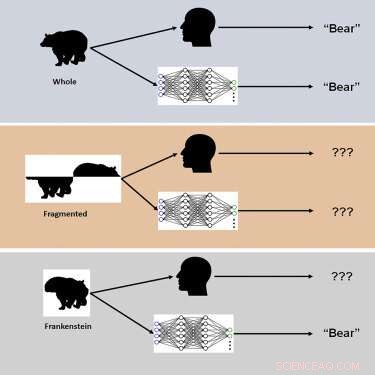

L'étude a utilisé de nouveaux stimuli visuels appelés "Frankensteins" pour explorer comment le cerveau humain et les DCNN traitent les propriétés holistiques et configurales des objets.

"Les Frankenstein sont simplement des objets qui ont été démontés et remontés dans le mauvais sens", explique Elder. "En conséquence, ils ont toutes les bonnes fonctionnalités locales, mais aux mauvais endroits."

Les enquêteurs ont découvert que si le système visuel humain est confus par les Frankenstein, les DCNN ne le sont pas, ce qui révèle une insensibilité aux propriétés de configuration des objets.

"Nos résultats expliquent pourquoi les modèles d'IA profonde échouent dans certaines conditions et soulignent la nécessité de considérer des tâches au-delà de la reconnaissance d'objets afin de comprendre le traitement visuel dans le cerveau", déclare Elder. "Ces modèles profonds ont tendance à prendre des" raccourcis "lors de la résolution de tâches de reconnaissance complexes. Bien que ces raccourcis puissent fonctionner dans de nombreux cas, ils peuvent être dangereux dans certaines des applications d'IA du monde réel sur lesquelles nous travaillons actuellement avec nos partenaires industriels et gouvernementaux, " fait remarquer Elder.

L'une de ces applications est les systèmes de sécurité vidéo sur la circulation :"Les objets d'une scène de circulation animée - les véhicules, les vélos et les piétons - se gênent et arrivent à l'œil d'un conducteur sous la forme d'un fouillis de fragments déconnectés", explique Elder. "Le cerveau doit regrouper correctement ces fragments pour identifier les catégories et les emplacements corrects des objets. Un système d'IA pour la surveillance de la sécurité routière qui ne peut percevoir que les fragments individuellement échouera dans cette tâche, ce qui pourrait mal comprendre les risques pour les usagers de la route vulnérables. "

Selon les chercheurs, les modifications de la formation et de l'architecture visant à rendre les réseaux plus ressemblant au cerveau n'ont pas conduit à un traitement de configuration, et aucun des réseaux n'a été en mesure de prédire avec précision les jugements d'objets humains essai par essai. "Nous supposons que pour correspondre à la sensibilité de la configuration humaine, les réseaux doivent être formés pour résoudre un plus large éventail de tâches d'objet au-delà de la reconnaissance des catégories", note Elder. Faire progresser la perception humaine dans les véhicules autonomes