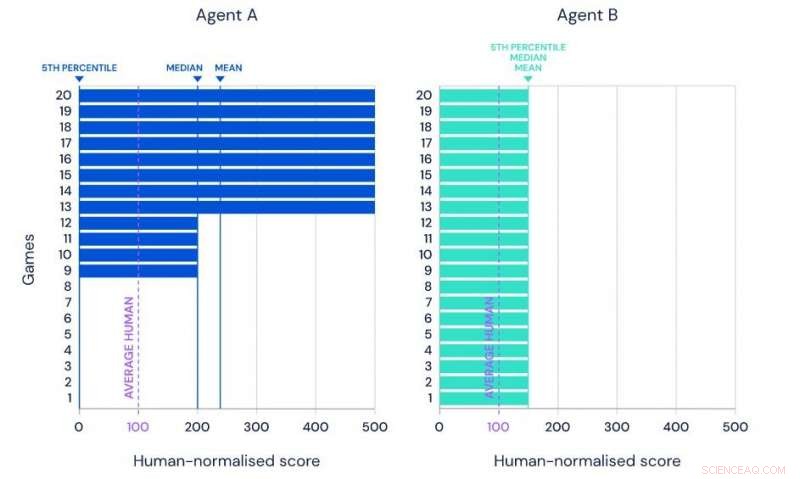

Illustration de la moyenne, performance médiane et 5e centile de deux agents hypothétiques sur le même ensemble de référence de 20 tâches. Crédit :Google

Afin de mieux répondre à des défis complexes à l'aube de la troisième décennie du XXIe siècle, Alphabet Inc. a puisé dans des reliques datant des années 1980 :les jeux vidéo.

La société mère de Google a annoncé cette semaine que son unité d'intelligence artificielle DeepMind Technologies avait appris avec succès à jouer à 57 jeux vidéo Atari. Et le système informatique joue mieux que n'importe quel humain.

Atari, créateur de Pong, l'un des premiers jeux vidéo à succès des années 1970, a continué à populariser de nombreux grands jeux vidéo classiques dans les années 1990. Les jeux vidéo sont couramment utilisés avec les projets d'IA car ils défient les algorithmes pour naviguer dans des chemins et des options de plus en plus complexes, tout en rencontrant des scénarios changeants, menaces et récompenses.

Baptisé AGENT57, Le système d'intelligence artificielle d'Alphabet a sondé 57 jeux Atari de premier plan couvrant une vaste gamme de niveaux de difficulté et diverses stratégies de réussite.

"Les jeux sont un excellent terrain d'essai pour construire des algorithmes adaptatifs, ", ont déclaré les chercheurs dans un rapport publié sur la page du blog DeepMind. "Ils fournissent une riche suite de tâches que les joueurs doivent développer des stratégies comportementales sophistiquées pour maîtriser, mais ils fournissent également une mesure de progression facile - le score du jeu - à optimiser.

"Le but ultime n'est pas de développer des systèmes qui excellent dans les jeux, mais plutôt d'utiliser les jeux comme tremplin pour développer des systèmes qui apprennent à exceller dans un large éventail de défis, " dit le rapport.

Le système AlphaGo de DeepMind a été largement reconnu en 2016 lorsqu'il a battu le champion du monde Lee Sedol dans le jeu stratégique de Go.

Parmi la récolte actuelle de 57 jeux Atari, quatre sont considérés comme particulièrement difficiles à maîtriser pour les projets d'IA :Montezuma's Revenge, Piège, Solaris et ski. Les deux premiers jeux posent ce que DeepMind appelle le "problème d'exploration-exploitation" déroutant.

" Faut-il continuer à adopter des comportements qu'on sait travailler (exploiter), ou faut-il essayer quelque chose de nouveau (explorer) pour découvrir de nouvelles stratégies qui pourraient être encore plus efficaces ?", demande DeepMind. "Par exemple, faut-il toujours commander son même plat préféré dans un restaurant local, ou essayer quelque chose de nouveau qui pourrait surpasser l'ancien favori ? L'exploration implique de prendre de nombreuses actions sous-optimales pour recueillir les informations nécessaires pour découvrir un comportement finalement plus fort."

Les deux autres jeux difficiles imposent de longs temps d'attente entre les défis et les récompenses, ce qui rend plus difficile l'analyse réussie des systèmes d'IA.

Les efforts précédents pour maîtriser les quatre jeux avec l'IA ont tous échoué.

Le rapport indique qu'il y a encore place à l'amélioration. Pour un, les longs temps de calcul restent un problème. Aussi, tout en reconnaissant que "plus il s'entraînait, plus son score est élevé, " Les chercheurs de DeepMind veulent qu'Agent57 fasse mieux. Ils veulent qu'il maîtrise plusieurs jeux simultanément; actuellement, il ne peut apprendre qu'un jeu à la fois et il doit s'entraîner à chaque redémarrage d'un jeu.

Finalement, Les chercheurs de DeepMind prévoient un programme qui peut appliquer des choix de prise de décision humains tout en faisant face à des défis en constante évolution et jamais vus auparavant.

"Une vraie polyvalence, qui vient si facilement à un nourrisson humain, est encore bien au-delà de la portée des IA, " conclut le rapport.

© 2020 Réseau Science X