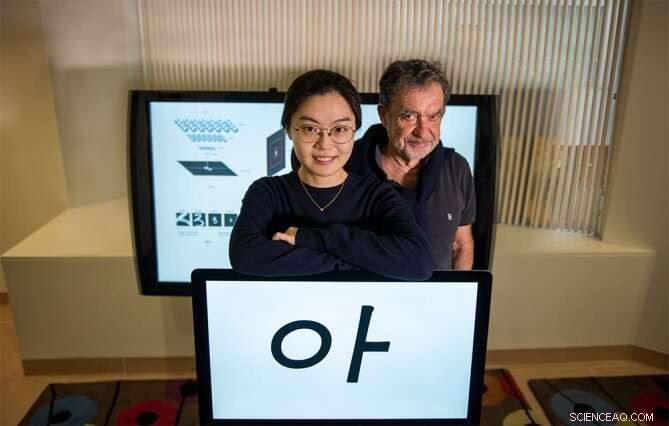

Yena Han (à gauche) et Tomaso Poggio présentent un exemple des stimuli visuels utilisés dans une nouvelle étude de psychophysique. Crédit :Kris Brewer

Supposons que vous regardiez brièvement à quelques mètres de distance une personne que vous n'avez jamais rencontrée auparavant. Reculez de quelques pas et regardez à nouveau. Saurez-vous reconnaître son visage ? "Oui, bien sûr, " vous pensez probablement. Si cela est vrai, cela signifierait que notre système visuel, avoir vu une seule image d'un objet tel qu'un visage spécifique, le reconnaît solidement malgré les changements de position et d'échelle de l'objet, par exemple. D'autre part, nous savons que les classificateurs de pointe, tels que les réseaux profonds vanille, échouera à ce test simple.

Afin de reconnaître un visage spécifique sous une gamme de transformations, les réseaux de neurones doivent être entraînés avec de nombreux exemples de visage dans différentes conditions. En d'autres termes, ils peuvent atteindre l'invariance par la mémorisation, mais ne peut pas le faire si une seule image est disponible. Ainsi, comprendre comment la vision humaine peut réaliser cet exploit remarquable est pertinent pour les ingénieurs qui souhaitent améliorer leurs classificateurs existants. Il est également important pour les neuroscientifiques modélisant le système visuel des primates avec des réseaux profonds. En particulier, il est possible que l'invariance avec l'apprentissage ponctuel présenté par la vision biologique nécessite une stratégie de calcul assez différente de celle des réseaux profonds.

Un nouvel article du MIT Ph.D. candidat en génie électrique et informatique Yena Han et ses collègues de Rapports scientifiques sur la nature , intitulé « Échelle et invariance de la traduction pour les nouveaux objets dans la vision humaine, " explique comment ils étudient ce phénomène plus attentivement pour créer de nouveaux réseaux d'inspiration biologique.

"Les humains peuvent apprendre de très peu d'exemples, contrairement aux réseaux profonds. C'est une énorme différence avec de vastes implications pour l'ingénierie des systèmes de vision et pour comprendre comment fonctionne réellement la vision humaine, " déclare le co-auteur Tomaso Poggio, directeur du Center for Brains, Minds and Machines (CBMM) et le professeur Eugene McDermott de sciences cérébrales et cognitives au MIT. "L'une des principales raisons de cette différence est l'invariance relative du système visuel des primates à l'échelle, décalage, et autres transformations. Étrangement, cela a été principalement négligé dans la communauté de l'IA, en partie parce que les données psychophysiques étaient loin d'être claires. Le travail de Han a maintenant établi des mesures solides des invariances de base de la vision humaine."

Différencier l'invariance issue du calcul intrinsèque de celle issue de l'expérience et de la mémorisation, la nouvelle étude a mesuré la plage d'invariance dans l'apprentissage unique. Une tâche d'apprentissage unique a été réalisée en présentant des stimuli de lettres coréennes à des sujets humains qui ne connaissaient pas la langue. Ces lettres ont été initialement présentées une seule fois dans une condition spécifique et testées à des échelles ou des positions différentes de la condition d'origine. Le premier résultat expérimental est que, comme vous l'avez deviné, les humains ont montré une reconnaissance invariante d'échelle significative après une seule exposition à ces nouveaux objets. Le deuxième résultat est que la plage d'invariance de position est limitée, selon la taille et l'emplacement des objets.

Prochain, Han et ses collègues ont réalisé une expérience comparable dans des réseaux de neurones profonds conçus pour reproduire cette performance humaine. Les résultats suggèrent que pour expliquer la reconnaissance invariante des objets par les humains, les modèles de réseaux de neurones devraient explicitement incorporer l'invariance d'échelle intégrée. En outre, l'invariance de position limitée de la vision humaine est mieux reproduite dans le réseau en faisant augmenter les champs récepteurs des neurones modèles à mesure qu'ils sont plus éloignés du centre du champ visuel. Cette architecture est différente des modèles de réseaux de neurones couramment utilisés, où une image est traitée sous une résolution uniforme avec les mêmes filtres partagés.

"Notre travail fournit une nouvelle compréhension de la représentation cérébrale des objets sous différents points de vue. Il a également des implications pour l'IA, comme les résultats fournissent de nouvelles informations sur ce qu'est une bonne conception architecturale pour les réseaux de neurones profonds, " remarque Han, Chercheur CBMM et auteur principal de l'étude.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.