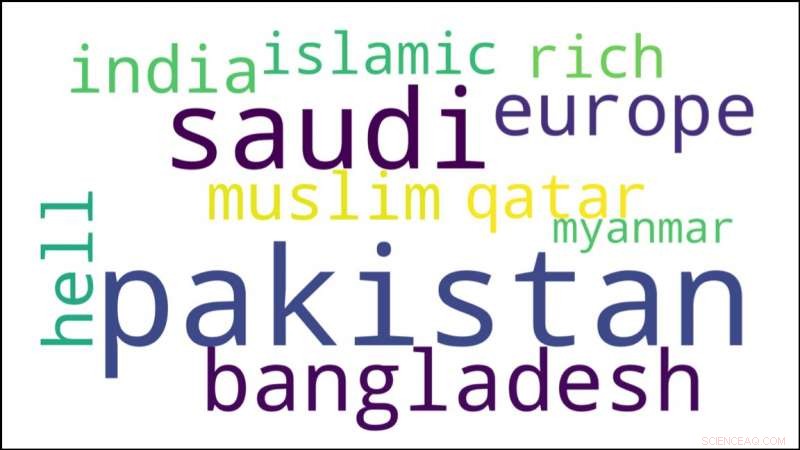

Ce nuage de mots décrit les réponses sur les réseaux sociaux à la question de savoir où les réfugiés rohingyas devraient aller. Crédit :Université Carnegie Mellon

Complétez la phrase suivante :Les réfugiés rohingyas devraient aller à... —

A. Pakistan.

B. Bangladesh.

C. L'enfer.

Ce ne sont pas de bons choix, mais tous sont des sentiments qui ont été exprimés à plusieurs reprises sur les réseaux sociaux. Les Rohingyas, qui a commencé à fuir le Myanmar en 2017 pour éviter le nettoyage ethnique, sont mal équipés pour se défendre contre ces attaques en ligne, mais les innovations du Language Technologies Institute (LTI) de l'Université Carnegie Mellon pourraient aider à contrer le discours de haine dirigé contre eux et d'autres groupes sans voix.

Les chercheurs de LTI ont développé un système qui exploite l'intelligence artificielle pour analyser rapidement des centaines de milliers de commentaires sur les réseaux sociaux et identifier la fraction qui défend ou sympathise avec les minorités privées de leurs droits, comme la communauté Rohingya. Modérateurs humains de médias sociaux, qui ne pouvait pas passer au crible manuellement autant de commentaires, aurait alors la possibilité de mettre en évidence ce "discours d'aide" dans les sections de commentaires.

"Même s'il y a beaucoup de contenu haineux, nous pouvons encore trouver des commentaires positifs, " a déclaré Ashiqur R. KhudaBukhsh, un chercheur post-doctoral au LTI qui a mené la recherche avec l'ancien élève Shriphani Palakodety. Retrouver et souligner ces commentaires positifs, ils proposent, pourrait faire autant pour rendre Internet plus sûr, endroit plus sain comme le ferait la détection et l'élimination des contenus hostiles ou l'interdiction des trolls responsables.

Laissés à eux-mêmes, les Rohingyas sont en grande partie sans défense contre les discours de haine en ligne. Beaucoup d'entre eux ont une maîtrise limitée des langues mondiales telles que l'anglais, et ils ont peu accès à Internet. La plupart sont trop occupés à essayer de rester en vie pour passer beaucoup de temps à publier leur propre contenu, dit KhudaBukhsh.

Pour trouver un discours d'aide pertinent, les chercheurs ont utilisé leur technique pour rechercher plus d'un quart de million de commentaires sur YouTube dans ce qu'ils pensent être la première analyse centrée sur l'IA de la crise des réfugiés rohingyas. Ils présenteront leurs conclusions à la conférence annuelle de l'Association for the Advancement of Artificial Intelligence, 7-12 février, a New York.

De la même manière, dans une étude non encore publiée, ils ont utilisé la technologie pour rechercher des "discours d'espoir" anti-guerre parmi près d'un million de commentaires YouTube concernant l'attaque terroriste de Pulwama en février 2019 au Cachemire, qui a enflammé le différend de longue date entre l'Inde et le Pakistan sur la région.

La capacité d'analyser de si grandes quantités de texte pour le contenu et l'opinion est possible grâce aux récentes améliorations majeures des modèles linguistiques, dit Jaime Carbonell, directeur du LTI et co-auteur de l'étude. Ces modèles apprennent à partir d'exemples afin de pouvoir prédire quels mots sont susceptibles de se produire dans une séquence donnée et d'aider les machines à comprendre ce que les locuteurs et les écrivains essaient de dire.

Mais les chercheurs de la CMU ont développé une autre innovation qui a permis d'appliquer ces modèles à de courts textes de médias sociaux en Asie du Sud, il ajouta. De courts morceaux de texte, souvent avec des fautes d'orthographe et de grammaire, sont difficiles à interpréter pour les machines. C'est encore plus difficile dans les pays d'Asie du Sud, où les gens peuvent parler plusieurs langues et ont tendance à "changer de code, " combinant des morceaux de langues différentes et même des systèmes d'écriture différents dans le même énoncé.

Les méthodes d'apprentissage automatique existantes créent des représentations de mots, ou des inclusions de mots, afin que tous les mots ayant un sens similaire soient représentés de la même manière. Cette technique permet de calculer la proximité d'un mot à d'autres dans un commentaire ou une publication. Pour étendre cette technique aux textes exigeants de l'Asie du Sud, l'équipe CMU a obtenu de nouveaux plongements qui ont révélé des groupements ou des clusters linguistiques. Cette technique d'identification de la langue fonctionnait aussi bien ou mieux que les solutions disponibles dans le commerce.

Cette innovation est devenue une technologie habilitante pour les analyses informatiques des médias sociaux dans cette région, Carbonell a noté.

Des échantillons de commentaires sur YouTube ont montré qu'environ 10 % des commentaires étaient positifs. Lorsque les chercheurs ont utilisé leur méthode pour rechercher des paroles d'aide dans le plus grand ensemble de données, les résultats étaient positifs à 88 %, indiquant que la méthode pourrait réduire considérablement l'effort manuel nécessaire pour les trouver, dit KhudaBukhsh.

"Aucun pays n'est trop petit pour accueillir des réfugiés, " dit un texte, tandis qu'un autre a fait valoir que « tous les pays devraient prendre position pour ces personnes ».

Mais détecter les textes pro-Rohingya peut être une arme à double tranchant :certains textes peuvent contenir un langage qui pourrait être considéré comme un discours de haine contre leurs présumés persécuteurs, il ajouta.

Les antagonistes des Rohingyas sont « vraiment un peu comme des animaux, pas comme des êtres humains, c'est pourquoi ils génocident des innocents, " dit l'un de ces textes. Bien que la méthode réduise les efforts manuels, des commentaires comme celui-ci indiquent le besoin continu de jugement humain et de recherches supplémentaires, concluent les scientifiques.