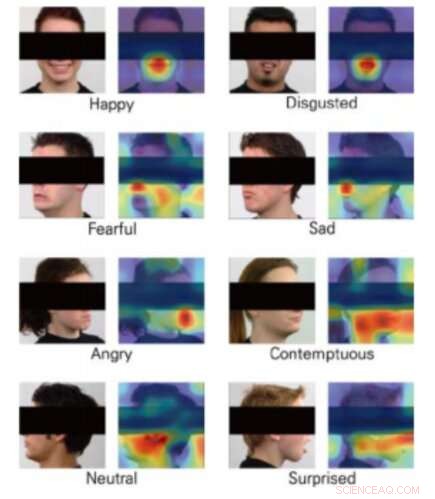

Cartes d'activation de classe pour 8 émotions. Crédit :Yong, Lee &Choi.

La réalité virtuelle (VR) ouvre de nouvelles frontières passionnantes dans le développement de jeux vidéo, ouvrant la voie à de plus en plus réaliste, des expériences de jeu interactives et immersives. consoles de réalité virtuelle, En réalité, permettre aux joueurs de se sentir presque à l'intérieur du jeu, surmonter les limitations associées aux problèmes de résolution d'affichage et de latence.

Une intégration supplémentaire intéressante pour la VR serait la reconnaissance des émotions, car cela pourrait permettre le développement de jeux qui répondent aux émotions d'un utilisateur en temps réel. Avec ça en tête, une équipe de chercheurs de l'Université Yonsei et de Motion Device Inc. ont récemment proposé une technique basée sur l'apprentissage en profondeur qui pourrait permettre la reconnaissance des émotions lors d'expériences de jeu en réalité virtuelle. Leur article a été présenté à la conférence IEEE 2019 sur la réalité virtuelle et les interfaces utilisateur 3D.

Pour que la VR fonctionne, les utilisateurs portent des visiocasques (HMD), afin que le contenu d'un jeu puisse être présenté directement devant leurs yeux. Fusionner des outils de reconnaissance des émotions avec des expériences de jeu VR s'est donc avéré difficile, comme la plupart des modèles d'apprentissage automatique pour la prédiction des émotions fonctionnent en analysant les visages des gens ; en RV, le visage d'un utilisateur est partiellement obstrué par le HMD.

L'équipe de chercheurs de l'Université Yonsei et de Motion Device ont formé trois réseaux de neurones convolutifs (CNN), à savoir DenseNet, ResNet et Inception-ResNet-V2—pour prédire les émotions des gens à partir d'images partielles de visages. Ils ont pris des images du jeu de données Radbound Faces (RaFD), qui comprend 8, 040 images de visage de 67 sujets, puis les a édités en couvrant la partie du visage qui serait obstruée par le HMD lors de l'utilisation de la VR.

Les images utilisées pour entraîner les algorithmes représentent des visages humains, mais la section contenant les yeux, les oreilles et les sourcils sont recouverts d'un rectangle noir. Lorsque les chercheurs ont évalué leurs CNN, ils ont découvert qu'ils étaient capables de classer les émotions même sans analyser ces caractéristiques particulières du visage d'une personne, qui sont considérés comme d'une importance clé pour la reconnaissance des émotions.

Globalement, le CNN appelé DenseNet a mieux performé que les autres, atteindre des précisions moyennes de plus de 90 pour cent. De façon intéressante, cependant, l'algorithme ResNet a surpassé les deux autres dans la classification des expressions faciales qui véhiculaient la peur et le dégoût.

"Nous avons formé avec succès trois architectures CNN qui estiment les émotions à partir des images de visage humain partiellement couvertes, ", ont écrit les chercheurs dans leur article. "Notre étude a montré la possibilité d'estimer les émotions à partir d'images d'humains portant des HMD en utilisant la vision artificielle."

L'étude suggère qu'à l'avenir, les outils de reconnaissance des émotions pourraient être intégrés à la technologie VR, même si les HMD obstruent des parties du visage d'un joueur. En outre, les CNN développés par les chercheurs pourraient inspirer d'autres équipes de recherche dans le monde à développer de nouvelles techniques de reconnaissance des émotions pouvant être appliquées aux jeux en réalité virtuelle.

Les chercheurs prévoient maintenant de remplacer les rectangles noirs qu'ils ont utilisés dans leur étude par de vraies images de personnes portant des HDM. Cela devrait leur permettre à terme de former les CNN de manière plus fiable et efficace, les préparer à des applications réelles.

© 2019 Réseau Science X