Crédit :Petr Kratochvil/domaine public

Dans un monde de Deep Fakes et d'IA bien trop humaine en langage naturel, Des chercheurs de la Harvard John A. Paulson School of Engineering and Applied Sciences (SEAS) et d'IBM Research ont demandé :existe-t-il un meilleur moyen d'aider les gens à détecter le texte généré par l'IA ?

Cette question a conduit Sebastian Gehrmann, un doctorat candidat à SEAS, et Hendrik Strobelt, chercheur chez IBM, développer une méthode statistique, accompagné d'un outil interactif en libre accès, pour détecter le texte généré par l'IA.

Les générateurs de langage naturel sont entraînés sur des dizaines de millions de textes en ligne et imitent le langage humain en prédisant les mots qui se succèdent le plus souvent. Par exemple, les mots « avoir », « suis » et « était » sont statiquement les plus susceptibles de venir après le mot « je ».

En utilisant cette idée, Gehrmann et Strobelt ont développé une méthode qui, plutôt que d'identifier les erreurs dans le texte, identifie un texte trop prévisible.

« L'idée que nous avions est qu'au fur et à mesure que les modèles s'améliorent, ils sont définitivement pires que les humains, qui est détectable, aussi bon ou meilleur que les humains, qui peuvent être difficiles à détecter avec les approches conventionnelles, " a déclaré Gehrmann.

"Avant, vous pouviez dire par toutes les erreurs que le texte a été généré par machine, " dit Strobelt. " Maintenant, ce ne sont plus les erreurs mais plutôt l'utilisation de mots hautement probables (et quelque peu ennuyeux) qui appellent du texte généré par machine. Avec cet outil, les humains et l'IA peuvent travailler ensemble pour détecter les faux textes."

Gehrmann et Strobelt présenteront leurs recherches, qui a été co-écrit par Alexander Rush, Associé en informatique à SEAS, à la conférence de l'Association for Computational Linguistics (ACL) du 28 juillet au 2 août.

la méthode de Gehrmann et Strobelt, connu sous le nom de GLTR, est basé sur un modèle formé sur 45 millions de textes de sites Web - la version publique du modèle OpenAI, GPT-2. Parce qu'il utilise GPT-2 pour détecter le texte généré, GLTR fonctionne mieux contre GPT-2, mais se débrouille aussi bien contre d'autres modèles.

Voilà comment cela fonctionne:

Si vous insérez un passage de texte dans l'outil, il surligne le texte en vert, jaune, rouge ou violet, chaque couleur signifiant la prévisibilité du mot dans le contexte du mot qui le précède. Vert signifie que le mot était très prévisible, jaune, modérément prévisible, le rouge n'est pas très prévisible et le violet signifie que le modèle n'aurait pas du tout prédit le mot.

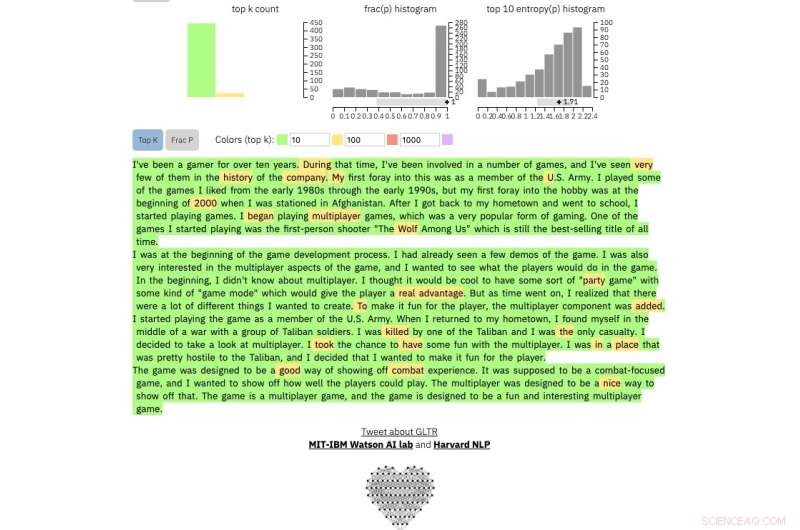

Ainsi, un paragraphe de texte généré par GPT-2 ressemblera à ceci :

Crédit :Université de Harvard

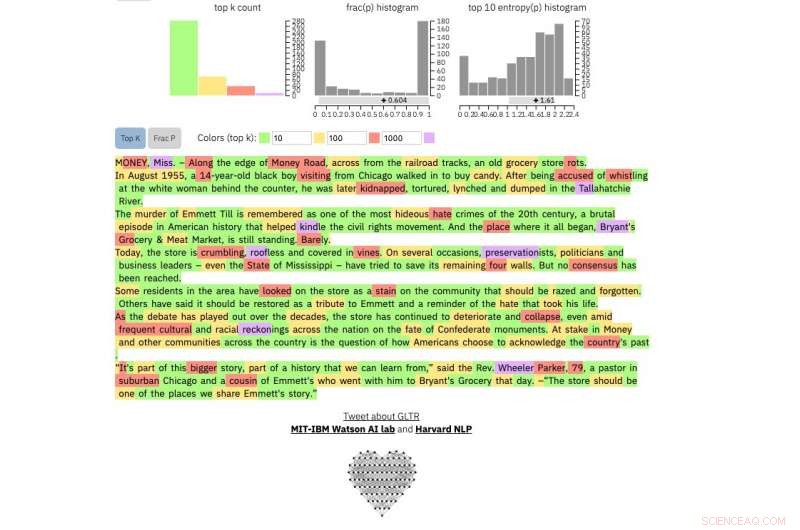

Comparer, c'est un vrai New York Times article:

Crédit :Université de Harvard

Et c'est un extrait sans doute du texte humain le plus imprévisible jamais écrit, celui de James Joyce Finnegans Wake :

Crédit :Université de Harvard

La méthode n'est pas destinée à remplacer les humains dans l'identification de faux textes, mais plutôt à soutenir l'intuition et la compréhension humaines. Les chercheurs ont testé le modèle avec un groupe d'étudiants de premier cycle dans un cours d'informatique SEAS.

Sans le modèle, les étudiants ont pu identifier environ 50 pour cent du texte généré par l'IA. Avec la superposition de couleurs, les étudiants ont pu identifier 72 pour cent.

Gehrmann et Strobelt disent qu'avec un peu de formation et d'expérience avec le programme, le nombre pourrait encore s'améliorer.

"Notre objectif est de créer des systèmes de collaboration humaine et IA, " a déclaré Gehrmann. "Cette recherche vise à donner aux humains plus d'informations afin qu'ils puissent prendre une décision éclairée sur ce qui est vrai et ce qui est faux."