Une bannière indiquant « L'État islamique » est affichée sur la page Facebook d'un utilisateur s'identifiant comme étant Nawan Al-Farancsa. La page était toujours en ligne mardi, 7 mai 2019, lorsque la capture d'écran a été effectuée. Facebook dit avoir mis en place des systèmes robustes pour supprimer le contenu des groupes extrémistes, mais la plainte d'un dénonciateur scellée examinée par l'AP indique que le contenu interdit reste sur le Web et est facile à trouver. (Facebook via AP)

La vidéo animée commence par une photo des drapeaux noirs du jihad. Quelques secondes plus tard, il met en lumière les faits saillants d'une année de publications sur les réseaux sociaux :plaques de vers antisémites, parler de représailles et une photo de deux hommes portant d'autres drapeaux djihadistes alors qu'ils brûlent les étoiles et les rayures.

Il n'a pas été produit par des extrémistes; il a été créé par Facebook. Dans un habile peu d'auto-promotion, le géant des médias sociaux prend un an du contenu d'un utilisateur et génère automatiquement une vidéo de célébration. Dans ce cas, l'utilisateur s'est fait appeler "Abdel-Rahim Moussa, le califat."

"Merci d'être ici, de Facebook, " la vidéo se termine dans une bulle de dessin animé avant de faire clignoter le célèbre "pouce levé" de l'entreprise.

Facebook aime donner l'impression de devancer les extrémistes en supprimant leurs publications, souvent avant même que les utilisateurs ne les voient. Mais une plainte confidentielle d'un dénonciateur auprès de la Securities and Exchange Commission obtenue par l'Associated Press allègue que la société de médias sociaux a exagéré son succès. Encore pire, cela montre que l'entreprise utilise par inadvertance la propagande de groupes militants pour générer automatiquement des vidéos et des pages qui pourraient être utilisées pour la mise en réseau par des extrémistes.

Selon la plainte, sur une période de cinq mois l'année dernière, les chercheurs ont surveillé les pages d'utilisateurs qui se sont affiliés à des groupes que le département d'État américain a désignés comme des organisations terroristes. Dans cette période, 38% des messages avec des symboles proéminents de groupes extrémistes ont été supprimés. Dans sa propre critique, l'AP a constaté qu'à partir de ce mois, une grande partie du contenu interdit cité dans l'étude :une vidéo d'exécution, images de têtes coupées, la propagande en l'honneur des militants martyrs s'est glissée sur la toile algorithmique et est restée facile à trouver sur Facebook.

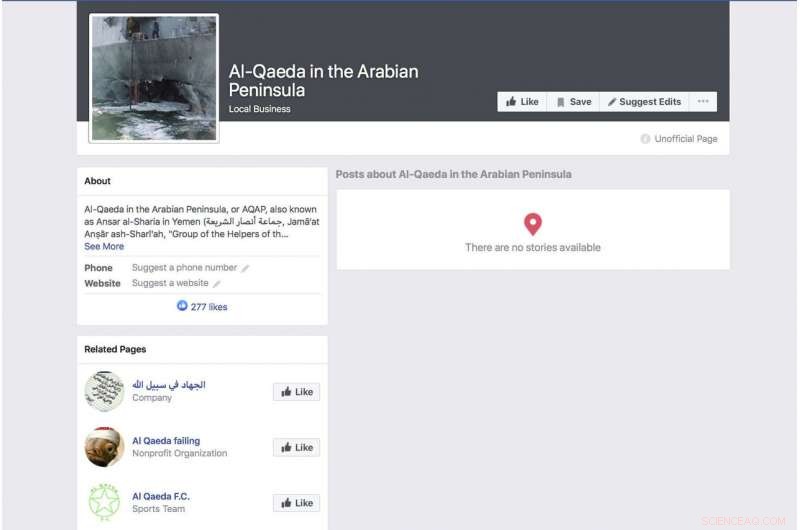

Une page Facebook générée automatiquement pour un groupe s'identifiant comme le groupe terroriste "Al-Qaïda dans la péninsule arabique" affiche une photo du navire de guerre bombardé de la marine américaine USS Cole. La page était toujours en ligne mardi, 7 mai 2019, lorsque la capture d'écran a été effectuée. Facebook dit avoir mis en place des systèmes robustes pour supprimer le contenu des groupes extrémistes, mais une plainte scellée d'un dénonciateur examinée par l'AP indique que le contenu interdit reste sur le Web et facile à trouver. (Facebook via AP)

La plainte arrive alors que Facebook essaie de garder une longueur d'avance sur un nombre croissant de critiques sur ses pratiques en matière de confidentialité et sa capacité à maintenir les discours de haine, meurtres et suicides diffusés en direct hors de son service. Face aux critiques, Le PDG Mark Zuckerberg s'est dit fier de la capacité de l'entreprise à éliminer automatiquement les messages violents grâce à l'intelligence artificielle. Lors d'un appel de résultats le mois dernier, par exemple, il a répété une formulation soigneusement formulée que Facebook a utilisée.

« Dans des domaines comme le terrorisme, pour les contenus liés à al-Qaida et à Daech, désormais, 99 % du contenu que nous retirons dans la catégorie que nos systèmes signalent de manière proactive avant que quiconque ne le voie, " a-t-il dit. Puis il a ajouté:"C'est à quoi ressemble vraiment bien."

Zuckerberg n'a pas fourni d'estimation de la quantité totale de matériel interdit qui est supprimée.

La recherche derrière la plainte de la SEC vise à mettre en lumière les défauts flagrants de l'approche de l'entreprise. L'année dernière, les chercheurs ont commencé à surveiller les utilisateurs qui se sont explicitement identifiés comme membres de groupes extrémistes. Ce n'était pas difficile à documenter. Certaines de ces personnes mentionnent même les groupes extrémistes comme leurs employeurs. Un profil annoncé par le drapeau noir d'un groupe affilié à al-Qaida mentionnait son employeur, peut-être facétieux, comme Facebook. Le profil qui comprenait la vidéo générée automatiquement avec le drapeau brûlé contenait également une vidéo du chef d'al-Qaida Ayman al-Zawahiri exhortant les groupes djihadistes à ne pas se battre entre eux.

Bien que l'étude soit loin d'être exhaustive, en partie parce que Facebook rend rarement une grande partie de ses données accessibles au public, les chercheurs impliqués dans le projet affirment que la facilité d'identification de ces profils à l'aide d'une recherche par mot clé de base et le fait que si peu d'entre eux ont été supprimés suggèrent que les affirmations de Facebook selon lesquelles ses systèmes capturent la plupart des contenus extrémistes ne sont pas exactes.

Amr Al Azm, professeur d'histoire et d'anthropologie du Moyen-Orient à la Shawnee State University, prend la parole à son bureau le 25 avril, 2019, à Portsmouth, Ohio. Facebook donne l'impression d'arrêter la grande majorité des publications extrémistes avant que les utilisateurs ne les voient. Mais une plainte confidentielle d'un dénonciateur auprès de la Securities and Exchange Commission obtenue par l'Associated Press allègue que la société de médias sociaux a exagéré son succès. "Je veux dire que ça pousse l'imagination au-delà de l'incrédulité, " dit, Al Azm l'un des chercheurs impliqués dans le projet. "Si un petit groupe de chercheurs peut trouver des centaines de pages de contenu par de simples recherches, pourquoi une entreprise géante avec toutes ses ressources ne peut-elle pas le faire ?" (AP Photo/John Minchillo)

"Je veux dire, c'est juste pousser l'imagination au-delà de l'incrédulité, " dit Amr Al Azm, l'un des chercheurs impliqués dans le projet. "Si un petit groupe de chercheurs peut trouver des centaines de pages de contenu par de simples recherches, pourquoi une entreprise géante avec toutes ses ressources ne peut-elle pas le faire ? »

Al Azm, professeur d'histoire et d'anthropologie à la Shawnee State University dans l'Ohio, a également dirigé un groupe en Syrie documentant le pillage et la contrebande d'antiquités.

Facebook concède que ses systèmes ne sont pas parfaits, mais dit qu'il fait des améliorations.

« Après de lourds investissements, nous détectons et supprimons le contenu terroriste avec un taux de réussite bien plus élevé qu'il y a deux ans, " La société a déclaré dans un communiqué. "Nous ne prétendons pas tout trouver et nous restons vigilants dans nos efforts contre les groupes terroristes à travers le monde."

Réagissant au signalement de l'AP, le représentant Bennie Thompson, D-Mlle., le président du House Homeland Security Committee a exprimé sa frustration que Facebook ait fait si peu de progrès dans le blocage du contenu malgré les assurances qu'il a reçues de la société.

Une page Facebook pour l'utilisateur Ramadan kareem, qui, une fois traduit en anglais, répertorie l'utilisateur comme travaillant pour « l'État islamique à Sham et en Irak ». La page était toujours en ligne mardi, 7 mai 2019, lorsque la capture d'écran a été effectuée. Facebook dit avoir mis en place des systèmes robustes pour supprimer le contenu des groupes extrémistes, mais une plainte scellée d'un dénonciateur examinée par l'AP indique que le contenu interdit reste sur le Web et facile à trouver. (Facebook via AP)

"C'est encore un autre exemple profondément inquiétant de l'incapacité de Facebook à gérer ses propres plates-formes - et de la mesure dans laquelle il doit nettoyer son acte, ", a-t-il déclaré. " Facebook ne doit pas seulement débarrasser ses plateformes de contenu terroriste et extrémiste, mais il doit aussi pouvoir éviter qu'il ne s'amplifie."

Mais comme une indication frappante de la facilité avec laquelle les utilisateurs peuvent échapper à Facebook, une page d'un utilisateur appelé "Nawan al-Farancsa" a un en-tête dont le lettrage blanc sur fond noir dit en anglais "The Islamic State". La banderole est ponctuée d'une photo d'un champignon atomique s'élevant d'une ville.

Le profil aurait dû attirer l'attention de Facebook, ainsi que des agences de contre-espionnage. Il a été créé en juin 2018, répertorie l'utilisateur comme venant de Tchétchénie, une fois un point chaud militant. Il dit qu'il a vécu à Heidelberg, Allemagne, et a étudié dans une université en Indonésie. Certains amis de l'utilisateur ont également publié du contenu militant.

La page, toujours en place ces derniers jours, apparemment échappé aux systèmes de Facebook, en raison d'une évasion évidente et de longue date de la modération que Facebook devrait être apte à reconnaître :les lettres n'étaient pas du texte consultable mais intégrées dans un bloc graphique. Mais la société affirme que sa technologie analyse l'audio, vidéo et texte, y compris lorsqu'ils sont intégrés, pour les images qui reflètent la violence, armes ou logos de groupes interdits.

Le géant des réseaux sociaux a enduré deux années difficiles à partir de 2016, lorsque l'utilisation par la Russie des médias sociaux pour se mêler des élections présidentielles américaines est devenue une priorité. Zuckerberg a d'abord minimisé le rôle joué par Facebook dans l'opération d'influence des services secrets russes, mais la société s'est excusée plus tard.

Une page Facebook pour un utilisateur qui se traduit en anglais par "Lumières d'amertume" qui répertorie l'utilisateur en tant que médecin de l'État islamique. La page était toujours en ligne mardi, 7 mai 2019, lorsque la capture d'écran a été effectuée. Facebook dit avoir mis en place des systèmes robustes pour supprimer le contenu des groupes extrémistes, mais la plainte d'un dénonciateur examinée par l'AP indique que le contenu interdit reste sur le Web et facile à trouver. (Facebook via AP)

Facebook dit qu'il en emploie maintenant 30, 000 personnes qui travaillent sur ses pratiques de sûreté et de sécurité, examiner le matériel potentiellement dangereux et tout ce qui pourrait ne pas appartenir au site. Toujours, l'entreprise mise beaucoup sur l'intelligence artificielle et la capacité de ses systèmes à éliminer les mauvaises choses sans l'aide de l'homme. La nouvelle recherche suggère que l'objectif est loin et certains critiques prétendent que l'entreprise ne fait pas d'efforts sincères.

Lorsque le matériau n'est pas retiré, il est traité de la même manière que n'importe quoi d'autre publié par les 2,4 milliards d'utilisateurs de Facebook—célébré dans des vidéos animées, liés et catégorisés et recommandés par des algorithmes.

Mais ce ne sont pas seulement les algorithmes qui sont à blâmer. Les chercheurs ont découvert que certains extrémistes utilisent le "Frame Studio" de Facebook pour publier de la propagande militante. L'outil permet aux gens de décorer leurs photos de profil dans des cadres graphiques, pour soutenir des causes ou célébrer des anniversaires, par exemple. Facebook dit que ces images encadrées doivent être approuvées par l'entreprise avant d'être publiées.

Hany Farid, un expert en criminalistique numérique à l'Université de Californie, Berkeley, qui conseille le Counter-Extremism Project, un groupe basé à New York et à Londres axé sur la lutte contre les messages extrémistes, dit que le système d'intelligence artificielle de Facebook est défaillant. Il dit que l'entreprise n'est pas motivée pour s'attaquer au problème car cela coûterait cher.

« Toute l'infrastructure est fondamentalement défectueuse, " Il a dit. " Et il y a très peu d'appétit pour y remédier parce que ce que Facebook et les autres sociétés de médias sociaux savent, c'est qu'une fois qu'ils commencent à être responsables du matériel sur leurs plateformes, cela ouvre toute une boîte de vers. "

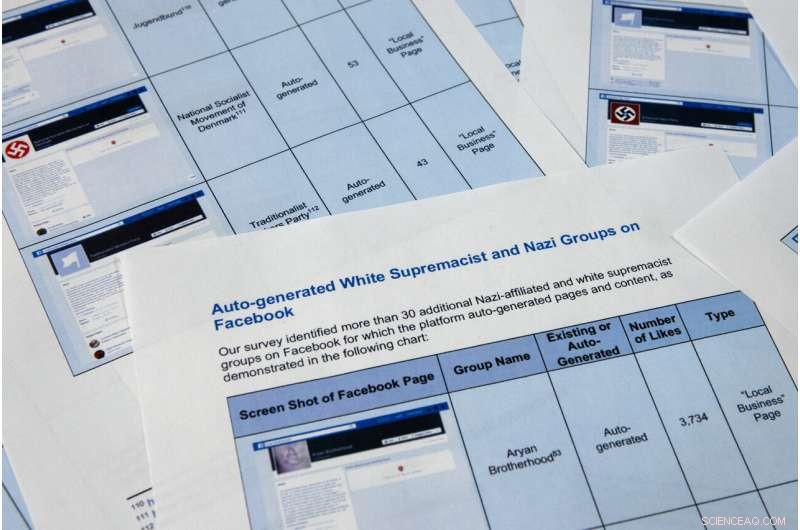

Des pages d'un rapport confidentiel d'un dénonciateur obtenu par l'Associated Press sont photographiées mardi, 7 mai 2019, à Washington. Facebook aime donner l'impression qu'il arrête la grande majorité des messages extrémistes avant que les utilisateurs ne les voient., mais la plainte confidentielle du dénonciateur auprès de la Securities and Exchange Commission allègue que la société de médias sociaux a exagéré son succès. Encore pire, cela montre que l'entreprise utilise la propagande de groupes militants pour générer automatiquement des vidéos et des pages qui pourraient être utilisées pour le réseautage par des extrémistes. (Photo AP/Jon Elswick)

Des pages d'un rapport confidentiel d'un dénonciateur obtenu par l'Associated Press sont photographiées mardi, 7 mai 2019, à Washington. Facebook aime donner l'impression qu'il arrête la grande majorité des messages extrémistes avant que les utilisateurs ne les voient., mais la plainte confidentielle du dénonciateur auprès de la Securities and Exchange Commission allègue que la société de médias sociaux a exagéré son succès. Encore pire, cela montre que l'entreprise utilise la propagande de groupes militants pour générer automatiquement des vidéos et des pages qui pourraient être utilisées pour le réseautage par des extrémistes. Les chercheurs de la plainte de la SEC ont identifié plus de 30 pages générées automatiquement pour les groupes suprémacistes blancs, dont Facebook interdit le contenu. (Photo AP/Jon Elswick)

En ce 11 avril 2018, fichier photo, Le PDG de Facebook, Mark Zuckerberg, témoigne devant une audience de House Energy and Commerce à Capitol Hill à Washington. Facebook donne l'impression d'arrêter la grande majorité des publications extrémistes avant que les utilisateurs ne les voient. Mais une plainte confidentielle d'un dénonciateur auprès de la Securities and Exchange Commission obtenue par l'Associated Press allègue que la société de médias sociaux a exagéré son succès. (AP Photo/Andrew Harnik, Déposer)

Une autre fonction de génération automatique de Facebook qui a mal tourné récupère les informations sur l'emploi des pages des utilisateurs pour créer des pages professionnelles. La fonction est censée produire des pages destinées à aider les entreprises à se mettre en réseau, mais dans de nombreux cas, ils servent d'espace d'atterrissage de marque pour les groupes extrémistes. La fonction permet aux utilisateurs de Facebook d'aimer les pages d'organisations extrémistes, dont al-Qaida, le groupe État islamique et le groupe somalien al-Shabab, fournir efficacement une liste de sympathisants aux recruteurs.

En haut d'une page générée automatiquement pour al-Qaida dans la péninsule arabique, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. En mars, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, 7 mai 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook via AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Par exemple, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " dit, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 La Presse Associée. Tous les droits sont réservés.