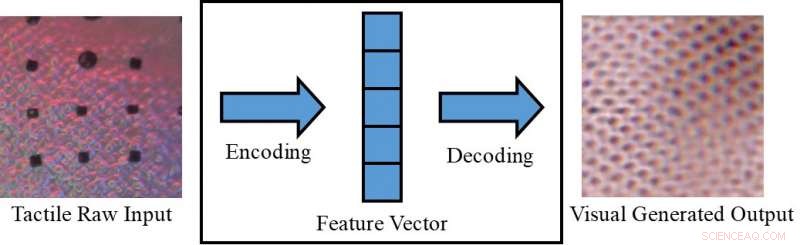

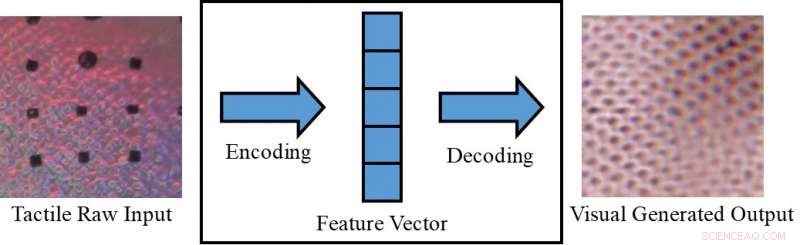

Conversion d'une image tactile en une image visuelle. Crédit :Lee, Bollegala &Luo.

Percevoir un objet uniquement visuellement (par exemple sur un écran) ou uniquement en le touchant, peut parfois limiter ce que nous pouvons en déduire. Êtres humains, cependant, avoir la capacité innée d'intégrer des stimuli visuels et tactiles, tirer parti de toutes les données sensorielles disponibles pour accomplir leurs tâches quotidiennes.

Des chercheurs de l'Université de Liverpool ont récemment proposé un nouveau cadre pour générer des données sensorielles intermodales, ce qui pourrait aider à reproduire à la fois des informations visuelles et tactiles dans des situations où l'une des deux n'est pas directement accessible. Leur cadre pourrait, par exemple, permettre aux gens de percevoir des objets sur un écran (par exemple des vêtements sur des sites de commerce électronique) à la fois visuellement et tactilement.

« Dans notre expérience quotidienne, nous pouvons créer cognitivement une visualisation d'un objet basée sur une réponse tactile, ou une réponse tactile de la visualisation de la texture d'une surface, " Dr Shan Luo, l'un des chercheurs qui a mené l'étude, a déclaré TechXplore. « Ce phénomène perceptif, appelé synesthésie, dans lequel la stimulation d'un sens provoque une réaction involontaire dans un ou plusieurs des autres sens, peut être utilisé pour inventer un sens inaccessible. Par exemple, quand on saisit un objet, notre vision sera obstruée par la main, mais une réponse tactile sera générée pour « voir » les fonctionnalités correspondantes."

Le phénomène de perception décrit par le Dr Luo se produit généralement lorsqu'une source de perception n'est pas disponible (par exemple, en touchant des objets à l'intérieur d'un sac sans pouvoir les voir). Dans de telles situations, les humains pourraient « toucher pour voir » ou « voir pour ressentir, " interpréter des caractéristiques liées à un sens particulier sur la base d'informations recueillies à l'aide de leurs autres sens. S'il est reproduit dans des machines, ce mécanisme visuo-tactile pourrait avoir plusieurs applications intéressantes, notamment dans les domaines de la robotique et du e-commerce.

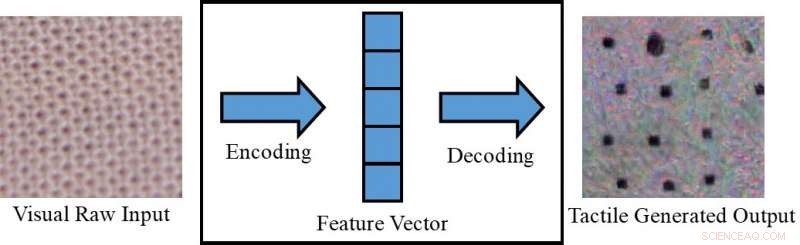

Conversion d'une image visuelle en une image tactile. Crédit :Lee, Bollegala &Luo.

Si les robots étaient capables d'intégrer la perception visuelle et tactile, ils pourraient planifier plus efficacement leurs stratégies de saisie et de manipulation en fonction des caractéristiques visuelles des objets avec lesquels ils travaillent (par exemple, forme, Taille, etc.). En d'autres termes, les robots percevraient les propriétés tactiles globales des objets avant de les saisir, à l'aide d'informations visuelles recueillies par des caméras. Tout en saisissant un objet hors du champ de vision de la caméra, d'autre part, ils utiliseraient des réponses de type tactile pour compenser le manque d'informations visuelles disponibles.

S'il est associé à un appareil tactile, qui n'a pas encore été développé, le cadre proposé par le Dr Luo et ses collègues pourrait également être utilisé dans le commerce électronique, par exemple, permettant aux clients de sentir le tissu des vêtements avant de les acheter. Avec cette application à l'esprit, les chercheurs ont utilisé des réseaux contradictoires génératifs conditionnels pour générer des images pseudo visuelles à l'aide de données tactiles et vice versa (c'est-à-dire pour générer des sorties tactiles à l'aide de données visuelles).

« Sur les places de marché en ligne, les clients achètent en visionnant des photos de vêtements ou d'autres articles, " dit le Dr Luo. " Cependant, ils sont incapables de toucher ces objets pour sentir leurs matériaux. Sentir un article est assez important lors de l'achat, en particulier lors de l'achat d'articles délicats, comme les sous-vêtements. Permettre aux utilisateurs de sentir les objets chez eux, à l'aide d'un dispositif tactile encore à développer, le schéma de génération de données sensorielles intermodales proposé dans notre article peut aider les clients du commerce électronique à faire des choix plus éclairés."

Le Dr Luo et ses collègues ont évalué leur modèle sur l'ensemble de données VITac, qui contient des macro-images et des lectures tactiles (capturées à l'aide d'un capteur GelSight) de 100 types de tissus différents. Ils ont découvert qu'il pouvait prédire efficacement les sorties sensorielles d'un sens (c'est-à-dire la vision ou le toucher) en utilisant des données pertinentes pour l'autre.

Capteur GelSight. Crédit :Lee, Bollegala &Luo.

« Nous prenons l'exemple de la perception de la texture :des images visuelles d'entrée d'une texture de tissu sont utilisées pour générer une lecture pseudo tactile du même morceau de tissu ; à l'inverse, des lectures tactiles d'un tissu sont utilisées pour prédire une image visuelle du même tissu, " expliqua le Dr Luo. " Les textures des tissus, c'est à dire., les schémas de répartition des fils, apparaissent de manière similaire dans une image visuelle et une lecture de distribution de pression (c'est-à-dire tactile). Cependant, ce travail peut également être étendu pour réaliser une génération de données visuelle-tactile cross-modale pour la perception d'autres propriétés d'objets, en considérant les différences entre les deux domaines.

L'étude menée par le Dr Luo et ses collègues a obtenu des résultats remarquables en générant des motifs tactiles et visuels réalistes pour différents tissus en l'absence d'informations tactiles ou visuelles, par conséquent. En utilisant leur cadre, les chercheurs ont réussi à « répliquer » des éléments tactiles de tissus en utilisant des données visuelles, et vice versa.

« À notre meilleure connaissance, ce travail est la première tentative pour réaliser la génération robotique de données visuelles-tactiles cross-modales, qui peut également être étendue à la génération de données intermodales pour d'autres modalités, " a déclaré le Dr Luo. " Les implications pratiques de notre étude sont que nous pouvons utiliser d'autres sens pour créer un sens inaccessible. "

À l'avenir, le cadre proposé par le Dr Luo et ses collègues pourrait être utilisé pour améliorer les stratégies de préhension et de manipulation chez les robots, ainsi que pour améliorer les expériences d'achat en ligne. Leur méthode pourrait également être utilisée pour étendre les ensembles de données pour les tâches de classification, en générant des données sensorielles qui seraient autrement inaccessibles.

Crédit :Lee, Bollegala &Luo.

« Dans les recherches futures, nous essaierons d'appliquer notre méthode à un certain nombre de tâches différentes, telles que la classification visuelle et tactile dans un environnement réel, avec des objets qui varient en apparence (par exemple, la forme, couleur, etc.), " a déclaré le Dr Luo. De plus, la méthode de génération de données visuo-tactiles proposée sera utilisée pour faciliter les tâches robotiques, comme la préhension et la manipulation."

Le document décrivant cette étude récente, prépublié sur arXiv, sera présenté à la Conférence internationale 2019 sur la robotique et l'automatisation (ICRA), qui aura lieu à Montréal, Canada, entre le 20 et le 24 mai. À la conférence, Le Dr Luo animera également un atelier lié au sujet de son étude, appelé « ViTac :Intégration de la vision et du toucher pour une perception multimodale et intermodale ».

© 2019 Réseau Science X