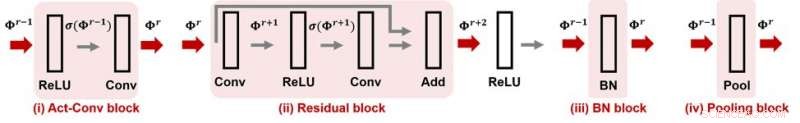

Figure 1. CNN-Cert prend en charge de nombreux modules et opérations de couche populaires dans les réseaux de neurones convolutifs. Crédit :IBM

Lorsque vous achetez une montre, vous remarquerez peut-être son indice de résistance à l'eau, ce qui indique que la montre est garantie pour être étanche à un certain niveau. Et votre réseau de neurones ? Peut-on garantir qu'un réseau de neurones est "à l'épreuve des attaques", ce qui signifie que sa fonctionnalité est robuste contre les perturbations antagonistes ? Si c'est le cas, comment cela peut-il être quantifié avec un nombre de résistance à l'attaque ? À l'AAAI 2019, notre groupe de chercheurs du MIT et d'IBM Research propose une méthode efficace et efficiente pour certifier la résistance aux attaques des réseaux de neurones convolutifs à des données d'entrée données. Cet article est sélectionné pour une présentation orale à l'AAAI 2019 (30 janvier, 14h00-15h30 @ corail 1).

Les modèles actuels de réseaux de neurones profonds sont connus pour être vulnérables aux perturbations antagonistes. Une perturbation soigneusement conçue mais petite des données d'entrée pourrait facilement manipuler la prédiction de la sortie du modèle, y compris les tâches d'apprentissage automatique telles que la reconnaissance d'objets, traduction vocale, sous-titrage des images, et classement de texte, pour n'en nommer que quelques-uns. Un manque de robustesse aux perturbations contradictoires entraîne de nouveaux défis dans la recherche sur l'IA et peut nuire à notre confiance dans les systèmes d'IA.

Étant donné un réseau de neurones et considérant un modèle de menace contradictoire dans lequel la force d'attaque est caractérisée par la norme Lp de la perturbation, pour toute saisie de données, sa robustesse contradictoire peut être quantifiée comme la force d'attaque minimale requise pour modifier la prédiction du modèle (voir la figure 1 dans le post précédent pour une illustration visuelle). Ici, un certificat de robustesse à l'épreuve des attaques pour une entrée spécifie une force d'attaque et offre la résistance aux attaques garantie suivante :sous le modèle de menace normé, aucune perturbation antagoniste ne peut altérer la prédiction de l'entrée si leur force d'attaque est inférieure à . En d'autres termes, plus grand ε signifie que l'entrée est plus robuste. Cette certification de robustesse peut être cruciale dans les applications d'IA critiques pour la sécurité ou sensibles aux coûts nécessitant une précision et une fiabilité élevées, tels que les systèmes de conduite autonome.

Notre méthode proposée, CNN-Cert, fournit un cadre général et efficace pour certifier le niveau de robustesse contradictoire des réseaux de neurones convolutifs à des données d'entrée données. Notre framework est général :nous pouvons gérer différentes architectures dont des couches convolutives, couches de mise en commun maximale, couche de normalisation par lots, blocs résiduels, ainsi que des fonctions d'activation générales telles que ReLU, tanh, sigmoïde et arctan. La figure 1 montre quelques blocs de construction couramment utilisés pris en compte dans notre cadre CNN-Cert. La technique clé dans CNN-Cert consiste à dériver une sortie de réseau explicite liée en considérant les relations entrée/sortie de chaque bloc de construction, marqués par des flèches rouges. La couche d'activation peut être des activations générales autres que ReLU. Notre approche est également efficace en exploitant la structure particulière des couches convolutives, nous obtenons jusqu'à 17 et 11 fois d'accélération par rapport aux algorithmes de certification de pointe et 366 fois d'accélération par rapport à une approche dual-LP standard tandis que notre méthode obtient des limites de résistance aux attaques similaires voire meilleures .

Cette histoire est republiée avec l'aimable autorisation d'IBM Research. Lisez l'histoire originale ici.