Les joueurs de basket-ball Darren Collision (à gauche) et Gordon Hayward (à droite). Crédit :basket-reference.com

La technologie de reconnaissance faciale a progressé au point où elle interprète désormais les émotions dans les expressions faciales. Ce type d'analyse est de plus en plus utilisé dans la vie quotidienne. Par exemple, les entreprises peuvent utiliser un logiciel de reconnaissance faciale pour les aider à prendre des décisions d'embauche. D'autres programmes scannent les visages dans les foules pour identifier les menaces à la sécurité publique.

Malheureusement, cette technologie peine à interpréter les émotions des visages noirs. Ma nouvelle étude, publié le mois dernier, montre que la technologie d'analyse émotionnelle attribue plus d'émotions négatives aux visages des hommes noirs qu'aux visages des hommes blancs.

Ce n'est pas la première fois que les programmes de reconnaissance faciale se révèlent biaisés. Google a qualifié les visages noirs de gorilles. Les caméras ont identifié des visages asiatiques clignotants. Les programmes de reconnaissance faciale ont eu du mal à identifier correctement le sexe des personnes à la peau plus foncée.

Mon travail contribue à un appel croissant à mieux comprendre le biais caché dans les logiciels d'intelligence artificielle.

Mesurer le biais

Examiner les biais dans les systèmes de reconnaissance faciale qui analysent les émotions des gens, J'ai utilisé un ensemble de données de 400 photos de joueurs NBA de la saison 2016 à 2017, parce que les joueurs sont similaires dans leurs vêtements, l'athlétisme, âge et sexe. Aussi, puisqu'il s'agit de portraits professionnels, les joueurs regardent la caméra sur la photo.

J'ai passé les images à travers deux types bien connus de logiciels de reconnaissance émotionnelle. Les deux ont attribué aux joueurs noirs des scores émotionnels plus négatifs en moyenne, peu importe combien ils souriaient.

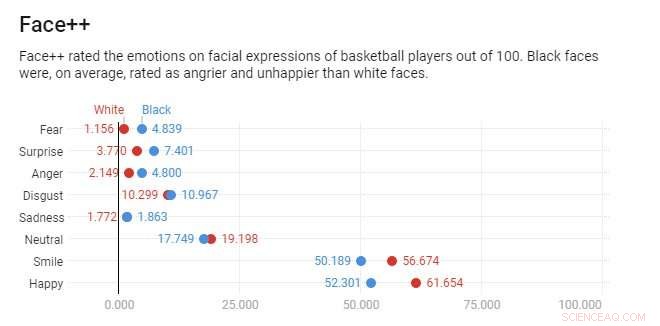

Crédit :Graphique :La conversation, CC-BY-ND Source :SSRN (2018)

Par exemple, Considérez les photos officielles de la NBA de Darren Collison et Gordon Hayward. Les deux joueurs sourient, et, selon le programme de reconnaissance et d'analyse faciale Face++, Darren Collison et Gordon Hayward ont des scores de sourire similaires – 48,7 et 48,1 sur 100, respectivement.

Cependant, Face ++ évalue l'expression de Hayward à 59,7 pour cent de heureux et 0,13 pour cent de colère et l'expression de Collison à 39,2 pour cent de heureux et 27 pour cent de colère. Collison est considéré comme presque aussi en colère qu'il est heureux et bien plus en colère que Hayward – malgré le programme de reconnaissance faciale lui-même reconnaissant que les deux joueurs sourient.

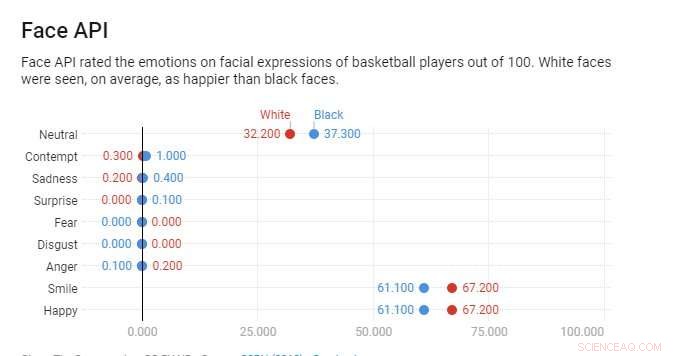

En revanche, L'API Face de Microsoft considérait les deux hommes comme heureux. Toujours, Collison est considéré comme moins heureux que Hayward, avec des scores de bonheur de 98 et 93 pour cent, respectivement. Malgré son sourire, Collison est même marqué avec une petite quantité de mépris, alors que Hayward n'en a pas.

Sur toutes les photos de la NBA, le même schéma se dégage. En moyenne, Face ++ évalue les visages noirs deux fois plus en colère que les visages blancs. Face API évalue les visages noirs comme trois fois plus méprisants que les visages blancs. Après avoir fait correspondre les joueurs en fonction de leurs sourires, les deux programmes d'analyse faciale sont encore plus susceptibles d'attribuer les émotions négatives de colère ou de mépris aux visages noirs.

Stéréotypé par l'IA

Mon étude montre que les programmes de reconnaissance faciale présentent deux types de biais distincts.

Crédit :Graphique :La conversation, CC-BY-ND Source :SSRN (2018)

D'abord, les visages noirs étaient systématiquement notés comme plus en colère que les visages blancs pour chaque sourire. Face++ a montré ce type de biais. Seconde, les visages noirs étaient toujours notés comme plus en colère s'il y avait une ambiguïté sur leur expression faciale. Face API affichait ce type de disparité. Même si les visages noirs sourient partiellement, mon analyse a montré que les systèmes supposaient plus d'émotions négatives que leurs homologues blancs avec des expressions similaires. Les scores émotionnels moyens étaient beaucoup plus proches d'une race à l'autre, mais il y avait encore des différences notables pour les visages en noir et blanc.

Cette observation rejoint d'autres recherches, ce qui suggère que les professionnels noirs doivent amplifier les émotions positives pour recevoir la parité dans leurs évaluations de performance au travail. Des études montrent que les gens perçoivent les hommes noirs comme plus menaçants physiquement que les hommes blancs, même quand ils sont de la même taille.

Certains chercheurs soutiennent que la technologie de reconnaissance faciale est plus objective que les humains. Mais mon étude suggère que la reconnaissance faciale reflète les mêmes préjugés que les gens. Les expressions faciales des hommes noirs sont marquées avec des émotions associées à des comportements menaçants plus souvent que les hommes blancs, même quand ils sourient. Il y a de bonnes raisons de croire que l'utilisation de la reconnaissance faciale pourrait formaliser des stéréotypes préexistants en algorithmes, en les intégrant automatiquement dans la vie de tous les jours.

Jusqu'à ce que la reconnaissance faciale évalue les visages en noir et blanc de la même manière, les Noirs peuvent avoir besoin d'exagérer leurs expressions faciales positives – essentiellement de sourire davantage – pour réduire l'ambiguïté et les interprétations potentiellement négatives de la technologie.

Bien qu'innovant, l'intelligence artificielle peut perpétrer et exacerber les dynamiques de pouvoir existantes, conduisant à un impact disparate entre les groupes raciaux/ethniques. Une certaine responsabilité sociétale est nécessaire pour garantir l'équité envers tous les groupes, car la reconnaissance faciale, comme la plupart des intelligences artificielles, est souvent invisible pour les personnes les plus affectées par ses décisions.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.