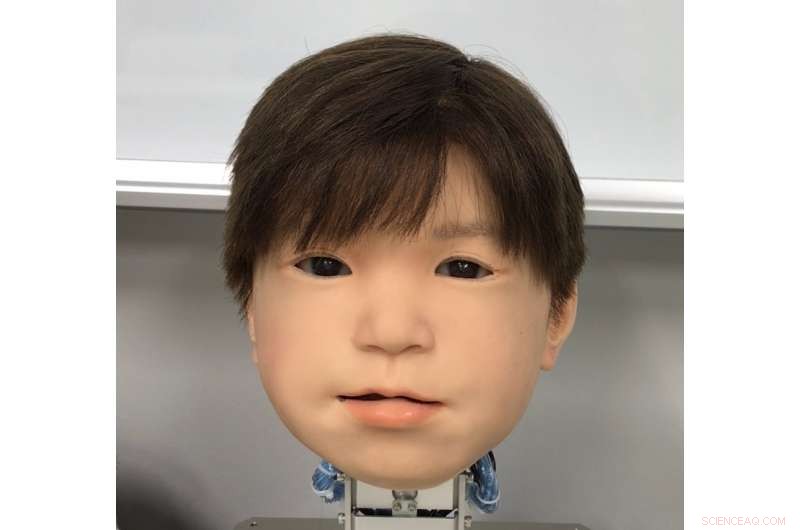

Il a récemment développé le visage du robot Android enfant Affetto. Le visage d'Affetto a été révélé pour la première fois dans une recherche publiée en 2011. Crédit :Université d'Osaka

L'affection du Japon pour les robots n'est pas un secret. Mais le sentiment est-il réciproque chez les incroyables androïdes du pays ? Les roboticiens sont maintenant sur le point de donner aux androïdes de plus grandes expressions faciales avec lesquelles communiquer.

Malgré les avancées, capturer des expressions humanistes dans un visage robotique reste un défi insaisissable. Bien que leurs propriétés système aient été généralement abordées, Les expressions faciales des androïdes n'ont pas été examinées en détail. Cela est dû à des facteurs tels que la vaste gamme et l'asymétrie des mouvements naturels du visage humain, les restrictions des matériaux utilisés dans la peau d'androïde, et l'ingénierie et les mathématiques complexes qui conduisent les mouvements des robots.

Un trio de chercheurs de l'Université d'Osaka a maintenant trouvé une méthode pour identifier et évaluer quantitativement les mouvements du visage sur leur tête d'enfant robot androïde. Nommé Affetto, le modèle de première génération a été rapporté dans une publication de 2011. Les chercheurs ont maintenant développé un système pour rendre l'Affetto de deuxième génération plus expressif. Leurs découvertes offrent aux androïdes un moyen d'exprimer de plus grandes gammes d'émotions, et finalement avoir une interaction plus profonde avec les humains.

Les chercheurs ont rapporté leurs découvertes dans le journal Frontières de la robotique et de l'IA .

"Les déformations de surface sont un problème clé dans le contrôle des visages androïdes, " explique Minoru Asada, co-auteur de l'étude. " Les mouvements de la peau douce de leur visage créent de l'instabilité, et c'est un gros problème matériel avec lequel nous sommes aux prises. Nous avons cherché un meilleur moyen de le mesurer et de le contrôler."

Les chercheurs ont étudié 116 points faciaux différents sur Affetto pour mesurer son mouvement tridimensionnel. Les points faciaux étaient sous-tendus par des unités dites de déformation. Chaque unité comprend un ensemble de mécanismes qui créent une contorsion faciale distinctive, comme l'abaissement ou l'élévation d'une partie d'une lèvre ou d'une paupière. Les mesures de ces derniers ont ensuite été soumises à un modèle mathématique pour quantifier leurs modèles de mouvement de surface.

Alors que les chercheurs ont rencontré des difficultés pour équilibrer la force appliquée et ajuster la peau synthétique, ils ont pu utiliser leur système pour ajuster les unités de déformation pour un contrôle précis des mouvements de la surface du visage d'Affetto.

"Les visages de robots Android ont persisté à être un problème de boîte noire :ils ont été implémentés mais n'ont été jugés qu'en termes vagues et généraux, ", a déclaré le premier auteur de l'étude Hisashi Ishihara. "Nos résultats précis nous permettront de contrôler efficacement les mouvements du visage androïdes pour introduire des expressions plus nuancées, comme sourire et froncer les sourcils."