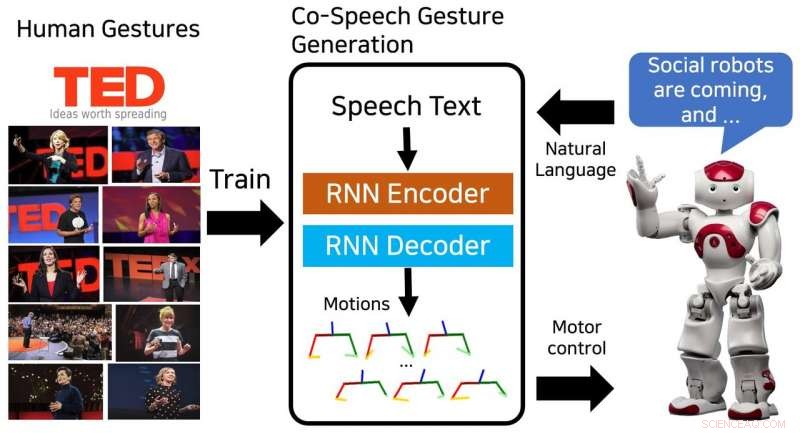

Le modèle proposé génère une séquence de poses du haut du corps et est entraîné sur les gestes humains à partir des conférences TED. Crédit :Yoon et al.

Des chercheurs de l'Electronics and Telecommunications Research Institute (ETRI) en Corée du Sud ont récemment développé un modèle de réseau neuronal capable de générer des séquences de gestes de co-discours. Leur modèle, formé sur 52 heures de conférences TED, produit avec succès des gestes de type humain qui correspondent au contenu de la parole.

« Les appareils intelligents avec lesquels nous interagissons sont passés des ordinateurs personnels aux téléphones portables et aux haut-parleurs intelligents, " Youngwoo Yoon, l'un des chercheurs qui a mené l'étude, a déclaré TechXplore. "Nous pensons que les robots sociaux pourraient être la prochaine plate-forme d'interaction. Le mouvement physique est l'une des principales différences entre les robots sociaux et les autres appareils intelligents, ouvrant de nouvelles possibilités d'émulation de comportements humains ou animaux, ce qui peut augmenter l'intimité."

Les gestes de co-discours pourraient grandement améliorer la qualité des interactions entre les humains et les robots sociaux. La plupart des robots existants produisent des gestes en utilisant des méthodes d'association parole-geste basées sur des règles. Cependant, ces techniques demandent des efforts considérables, car ils sont basés sur l'expertise et les connaissances humaines.

"Nous voulions générer des comportements sociaux naturels et humains, en particulier les gestes de la main en parlant, " a déclaré Yoon. " Observer les autres est une façon très naturelle d'apprendre un nouveau comportement, nous avons donc proposé un modèle de génération de gestes basé sur l'apprentissage qui a été formé sur un ensemble de données de conférences TED. »

Le modèle conçu par Yoon et ses collègues a été formé sur un ensemble de données contenant 52 heures de séquences vidéo de discussions TED. Après l'entrainement, le modèle pourrait générer des séquences de gestes humains et des poses du haut du corps pour correspondre au texte écrit de la parole.

"Concevoir les comportements sociaux des robots est difficile et chronophage car il faut prendre en compte les contextes, naturel, l'esthétique du mouvement, l'espace de contrôle des robots, et un certain nombre d'autres facteurs, " a expliqué Yoon. " Des études récentes sur l'apprentissage de bout en bout ont mis en lumière le potentiel des intelligences artificielles à générer des comportements aussi complexes. Après avoir vu des applications réussies dans la conduite autonome et la génération de mouvements du visage, nous avons décidé d'appliquer l'apprentissage de bout en bout à la génération de gestes de co-discours."

Le modèle de réseau de neurones développé par Yoon et ses collègues a réussi à générer plusieurs types de gestes, y compris iconique, métaphorique, déictique, et battre des gestes. De plus, il était capable de générer des séquences continues de gestes pour des textes vocaux de n'importe quelle longueur.

Les chercheurs ont découvert que leur méthode surpassait les méthodes de base en créant des gestes qui ressemblent à ceux des humains. Dans une évaluation subjective, 46 personnes recrutées sur Amazon Mechanical Turk ont estimé que les gestes générés étaient humains et correspondaient étroitement au contenu du discours.

"Nous avons découvert que les robots peuvent acquérir des compétences sociales, " Yoon a déclaré. "Pour la génération de gestes de co-discours, le modèle formé sur le jeu de données à grande échelle est assez général, ainsi le robot peut faire des gestes humains pour n'importe quel discours. Nous pensons que cette approche peut être appliquée à d'autres compétences sociales, ainsi qu'aux personnages des jeux vidéo et des mondes VR."

L'étude menée par Yoon et ses collègues a mis en évidence le potentiel de l'apprentissage de bout en bout pour la génération de gestes de co-discours. À l'avenir, il pourrait être utilisé pour améliorer les interactions homme-robot et pourrait également inspirer des recherches similaires, car l'ensemble de données des discussions TED qu'ils ont utilisé est accessible au public. Les chercheurs prévoient maintenant de faire avancer leur étude, en générant des gestes personnalisés pour différents robots.

"Les robots peuvent avoir leur propre personnalité, comme les gens, " a déclaré Yoon. " Une méthode de génération de gestes personnalisée pourrait garantir que différents robots s'expriment avec différents styles de gestes, selon leur personnalité."

© 2018 Réseau Science X