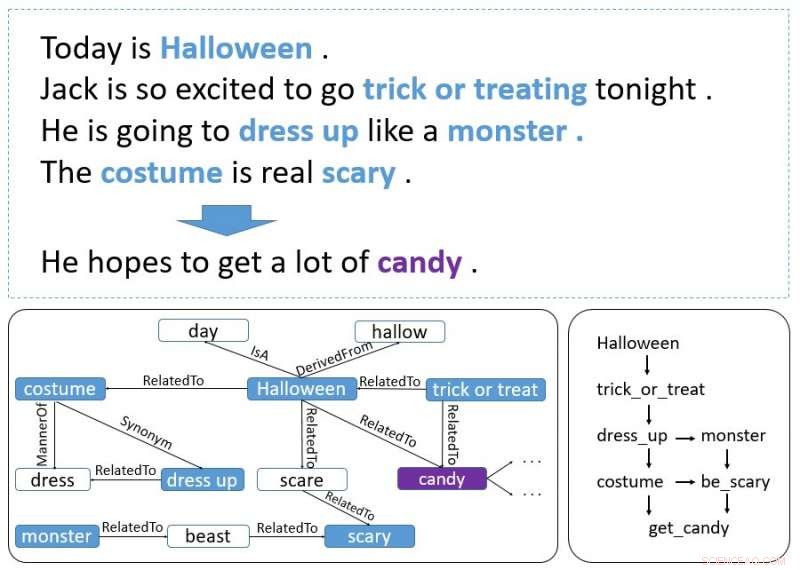

Un exemple d'histoire. Les mots en gras sont des événements et des entités. Le graphique en bas à gauche est extrait de ConceptNet et le graphique en bas à droite représente comment les événements et les entités forment l'indice de contexte. Crédit :Guan, Wang &Huang

Des chercheurs du AI Lab de l'Université Tsinghua ont récemment développé un modèle basé sur un encodeur incrémental qui peut générer des fins d'histoire. Un encodeur incrémental est un type d'algorithme de compression d'encodage qui est souvent utilisé pour compresser des données triées, telles que des listes de mots ou de phrases.

Le nouveau modèle, décrit dans un article prépublié sur arXiv, utilise un schéma de codage incrémentiel avec une attention multi-sources pour traiter les indices contextuels couvrant toute une histoire, générer une fin appropriée.

Initialement, les chercheurs se sont intéressés au Story Cloze Test (SCT), dans lequel un système choisit une fin correcte pour une histoire parmi deux possibilités disponibles. Des recherches antérieures se sont concentrées sur ce test particulier pour développer des outils de génération de fin d'histoire, mais l'étude récente pousse cette idée un peu plus loin.

"Nous pensions, pourquoi ne pas développer un modèle qui peut générer une fin à lui seul ? Nous avons donc proposé la tâche de génération de fin d'histoire, " Yansen Wang, l'un des chercheurs qui a mené l'étude a déclaré à TechXplore. "Toutefois, bientôt, nous avons constaté que générer une fin d'histoire raisonnable est une tâche beaucoup plus difficile que l'originale car elle nécessite de capturer des informations de logique et de causalité qui peuvent s'étendre sur plusieurs phrases d'un contexte d'histoire. L'utilisation du bon sens est également nécessaire dans cette tâche, ce qui n'est pas aussi important si deux fins possibles sont données."

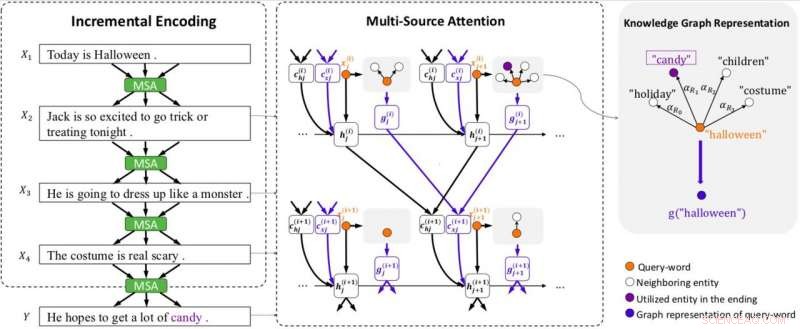

Présentation du modèle. Le modèle est équipé d'un codage incrémental (IE) et d'une attention multi-source (MSA) (y compris une attention graphique pour représenter des graphiques de connaissances). MSA produit des vecteurs de contexte d'état (c (i) hj ) en s'occupant des états cachés (h (i) j ), et des vecteurs de contexte de connaissance (c (i) xj ) en s'occupant des vecteurs graphiques (g (i) j ) de la phrase précédente. IE utilise les vecteurs de contexte d'état et de connaissance pour créer des codages de contexte de manière incrémentielle. Chaque graphe est représenté par un vecteur (g (i) j ) utilisant l'attention du graphe. x (i) j désigne le j-ième mot de la phrase i. Crédit :Guan, Wang &Huang

Pour relever ces deux défis, les chercheurs ont développé un schéma de codage incrémentiel avec un mécanisme d'attention multi-sources qui peut générer des fins d'histoire efficaces. Ce système fonctionne en encodant le contexte d'une histoire de manière incrémentale, avec son mécanisme d'attention multi-source utilisant à la fois des indices contextuels et des connaissances de bon sens.

"Le schéma de codage incrémental que nous avons développé peut coder les états précédents contenant des informations et des relations entre les mots de manière incrémentielle, " a déclaré Wang. " Le mécanisme d'attention multi-source trouvera et capturera l'ordre chronologique ou la relation causale entre les entités ou les événements dans les phrases adjacentes. Pour utiliser les connaissances de bon sens, une tête de l'attention multi-source indiquera une représentation logique des mots, qui contient des connaissances de bon sens extraites de ConceptNet."

La conception de ce modèle s'est avérée une tâche difficile et complexe, car plusieurs défis devaient être surmontés pour s'assurer que le système produisait des fins sensées. En réalité, une fin d'histoire efficace doit prendre en compte plusieurs aspects de l'histoire, cadrent bien avec son contexte et ont également un sens raisonnable.

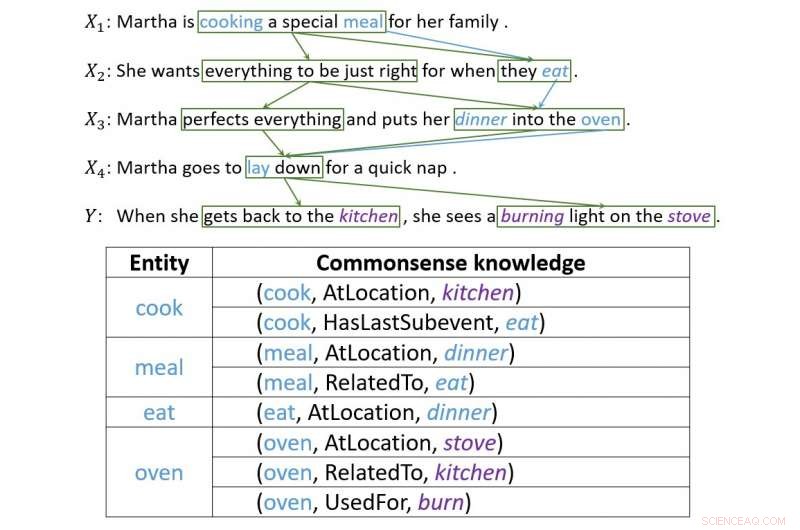

"La génération de fin d'histoire nécessite de capturer la logique et la causalité de l'information, " Expliqua Wang. " Ce genre d'information n'est pas seulement point à point. Dans la plupart des cas, il forme une structure plus complexe, que les gens appellent « indice de contexte ». Nous avons passé beaucoup de temps à concevoir notre modèle, puis le schéma de codage incrémental est apparu. L'attention entre les phrases forme naturellement une structure en forme de filet, et les informations logiques transmises par l'attention sont exactement ce que nous voulions."

Un exemple illustrant comment l'encodage incrémentiel établit des connexions entre les indices contextuels. Crédit :Guan, Wang &Huang

Les chercheurs ont évalué leur modèle et l'ont comparé à d'autres systèmes de génération de fin d'histoire. Ils ont découvert qu'il pouvait générer des fins d'histoire beaucoup plus appropriées et raisonnables que les lignes de base de pointe.

"Lors du test du modèle, nous avons obtenu des résultats charmants, " Wang a dit. " Dans les expériences suivantes, nous avons également constaté que ce schéma pourrait transmettre plus d'informations, y compris les connaissances de bon sens, seulement si nous pouvons représenter correctement ce genre d'information. Cela démontre la flexibilité de notre programme. »

Le modèle conçu par Wang et ses collègues prouve à quel point les dernières technologies peuvent aller, même dans des tâches qui jusqu'à présent ont été principalement accomplies par des humains. Bien qu'il ait obtenu des résultats très prometteurs, les chercheurs pensent qu'il y a encore beaucoup de place pour l'amélioration.

"Nous essayons maintenant d'appliquer ce cadre sur des corpus d'histoires plus longues, puisque la longueur des histoires dans SCT n'est pas trop longue, " dit Wang. " Qui plus est, étant donné que le cadre de codage incrémental peut transporter différents types d'informations, nous essayons de l'appliquer à d'autres types de tâches qui impliquent la transmission d'informations à long terme, comme la génération de conversations multitours."

© 2018 Tech Xplore