Alex Jones a affirmé que le fait d'avoir été déformé avait nui à ses revenus. Crédit :Vic Hinterlang/Shutterstock

Le théoricien du complot et personnalité médiatique d'extrême droite américaine Alex Jones a récemment été condamné à verser 45 millions de dollars américains (37 millions de livres sterling) de dommages et intérêts à la famille d'un enfant tué lors de la fusillade de l'école Sandy Hook en 2012.

Jones avait affirmé que le fait d'être banni ou "déformé" des principaux sites de médias sociaux pour ses opinions extrêmes l'affectait négativement financièrement, comparant la situation à une "prison". Mais pendant le procès, l'économiste médico-légal Bernard Pettingill a estimé que le site Web de conspiration de Jones, InfoWars, avait rapporté plus d'argent après avoir été banni de Facebook et Twitter en 2018.

Alors, la déplateforme en ligne fonctionne-t-elle réellement ? Il n'est pas possible de mesurer l'influence d'une manière scientifiquement rigoureuse, il est donc difficile de dire ce qui arrive à l'influence globale d'une personne ou d'un groupe lorsqu'ils sont déformés. Dans l'ensemble, la recherche suggère que la déplateforme peut réduire l'activité d'acteurs néfastes sur ces sites. Cependant, cela a un prix. Au fur et à mesure que les personnes et les groupes déprimés migrent ailleurs, ils peuvent perdre des adeptes, mais aussi devenir plus haineux et toxiques.

En règle générale, la déplateforme implique des actions prises par les sites de médias sociaux eux-mêmes. Mais cela peut être fait par des tiers comme les institutions financières fournissant des services de paiement sur ces plateformes, comme PayPal.

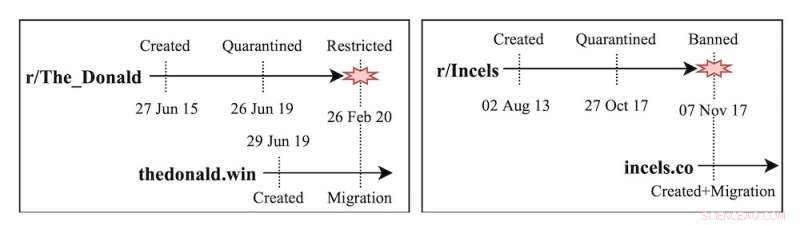

Fermer un groupe est aussi une forme de déplateforme, même si les personnes qui en font partie sont toujours libres d'utiliser les sites. Par exemple, le subreddit The_Donald (un forum sur le site Web Reddit) a été fermé pour avoir hébergé du contenu haineux et menaçant, comme un message encourageant les membres à assister à un rassemblement de suprémacistes blancs.

Tracés de Jhaver et al. Affichage des niveaux d'activité et des scores de toxicité sévère des partisans de trois célébrités Twitter déplatformées avant et après la déplateforme.

La déplateforme fonctionne-t-elle ?

La recherche montre que la déplateforme a des effets positifs sur la plateforme dont la personne ou le groupe a été expulsé. Lorsque Reddit a interdit certains forums victimisant les personnes en surpoids et les Afro-Américains, de nombreux utilisateurs qui étaient actifs sur ces subreddits haineux ont complètement cessé de publier sur Reddit. Ceux qui sont restés actifs ont publié des contenus moins extrêmes.

Mais le groupe ou la personne déformée peut migrer. Alex Jones continue de travailler en dehors des réseaux sociaux grand public, opérant principalement via son site Web InfoWars et ses podcasts. Une interdiction de la grande technologie peut être considérée comme une punition pour avoir défié le statu quo de manière non censurée, renforçant les liens et le sentiment d'appartenance entre les adeptes.

Gab a été créé comme un réseau social alternatif en 2016, accueillant les utilisateurs qui ont été bannis d'autres plateformes. Depuis l'insurrection du Capitole des États-Unis, Gab a tweeté à propos de ces interdictions en signe d'honneur, et a déclaré qu'il avait constaté une augmentation du nombre d'utilisateurs et de demandes d'emploi.

Les recherches de mon équipe ont porté sur les subreddits The_Donald et Incels (une communauté masculine en ligne hostile aux femmes), qui ont migré vers des sites Web autonomes après avoir été bannis de Reddit. Nous avons constaté qu'à mesure que les communautés dangereuses migraient sur différentes plates-formes, leur empreinte devenait plus petite, mais les utilisateurs devenaient beaucoup plus extrêmes. De même, les utilisateurs qui ont été bannis de Twitter ou de Reddit ont montré un niveau accru d'activité et de toxicité lors de leur déménagement à Gab.

D'autres études sur la naissance de réseaux sociaux marginaux comme Gab, Parler ou Gettr ont trouvé des schémas relativement similaires. Ces plateformes se présentent comme des bastions de la liberté d'expression, accueillant des utilisateurs bannis ou suspendus d'autres réseaux sociaux. Les recherches montrent que non seulement l'extrémisme augmente en raison d'une modération laxiste, mais aussi que les premiers utilisateurs du site ont une influence disproportionnée sur la plate-forme.

Les conséquences involontaires de la déplateforme ne se limitent pas aux communautés politiques, mais s'étendent à la désinformation sur la santé et aux groupes de théorie du complot. Par exemple, lorsque Facebook a interdit les groupes discutant des vaccins COVID-19, les utilisateurs sont allés sur Twitter et ont publié encore plus de contenu anti-vaccin.

Chronologie de la création, de la mise en quarantaine et de l'interdiction des sous-reddits Incels et The_Donald.

Solutions alternatives

Que peut-on faire d'autre pour éviter la concentration de haine en ligne que la déplateforme peut encourager ? Les réseaux sociaux ont expérimenté des interventions de modération douce qui ne suppriment pas le contenu ni n'interdisent les utilisateurs. Ils limitent la visibilité du contenu (interdiction de l'ombre), restreignent la capacité des autres utilisateurs à interagir avec le contenu (réponse ou partage) ou ajoutent des étiquettes d'avertissement.

Ces approches donnent des résultats encourageants. Certaines étiquettes d'avertissement ont incité les utilisateurs du site à démystifier les fausses allégations. La modération douce réduit parfois les interactions des utilisateurs et l'extrémisme dans les commentaires.

Cependant, il existe un potentiel de biais de popularité (agir ou ignorer le contenu en fonction du buzz qui l'entoure) sur les sujets sur lesquels des plateformes comme Twitter décident d'intervenir. Pendant ce temps, les étiquettes d'avertissement semblent fonctionner moins efficacement pour les faux messages s'ils penchent à droite.

Il n'est pas non plus clair si la modération douce crée des voies supplémentaires de harcèlement, par exemple en se moquant des utilisateurs qui obtiennent des étiquettes d'avertissement sur leurs messages ou en aggravant les utilisateurs qui ne peuvent pas repartager du contenu.

Exemples de modération douce sur Twitter :étiquettes d'avertissement et interdiction des ombres.

J'ai hâte

Un aspect crucial de la déplateforme est le timing. Plus tôt les plateformes agissent pour empêcher les groupes d'utiliser les plateformes grand public pour développer des mouvements extrémistes, mieux c'est. Une action rapide pourrait en théorie freiner les efforts des groupes pour rassembler et radicaliser de larges bases d'utilisateurs.

Mais cela nécessiterait également un effort coordonné des plateformes grand public ainsi que des autres médias pour fonctionner. Les talk-shows radio et les informations par câble jouent un rôle crucial dans la promotion des récits marginaux aux États-Unis.

Nous avons besoin d'un dialogue ouvert sur le compromis de déplateforme. En tant que société, nous devons discuter si nos communautés devraient avoir moins de personnes exposées aux groupes extrémistes, même si ceux qui s'engagent deviennent de plus en plus isolés et radicalisés.

À l'heure actuelle, la déplateforme est presque exclusivement gérée par de grandes entreprises technologiques. Les entreprises technologiques ne peuvent pas résoudre le problème seules, mais les chercheurs ou les politiciens non plus. Les plateformes doivent travailler avec les régulateurs, les organisations de défense des droits civiques et les chercheurs pour faire face aux contenus extrêmes en ligne. Le tissu social peut en dépendre.

Cet article est republié de The Conversation sous une licence Creative Commons. Lire l'article d'origine. Repenser nécessaire pour arrêter la diffusion de matériel haineux en ligne