Crédit : La conversation

Un rapport interne de Facebook a révélé que les algorithmes de la plate-forme de médias sociaux - les règles que ses ordinateurs suivent pour décider du contenu que vous voyez - ont permis aux campagnes de désinformation basées en Europe de l'Est d'atteindre près de la moitié de tous les Américains à l'approche de l'élection présidentielle de 2020, selon un rapport dans Technology Review.

Les campagnes ont produit les pages les plus populaires pour le contenu chrétien et noir américain, et globalement atteint 140 millions d'utilisateurs américains par mois. Soixante-quinze pour cent des personnes exposées au contenu n'avaient suivi aucune des pages. Les gens ont vu le contenu parce que le système de recommandation de contenu de Facebook l'a intégré à leurs fils d'actualité.

Les plateformes de médias sociaux s'appuient fortement sur le comportement des gens pour décider du contenu que vous voyez. En particulier, ils recherchent du contenu auquel les gens réagissent ou « interagissent » en appréciant, commenter et partager. Fermes de trolls, les organisations qui diffusent du contenu provocateur, exploitez cela en copiant le contenu à fort engagement et en le publiant comme le leur.

En tant qu'informaticien qui étudie la façon dont un grand nombre de personnes interagissent à l'aide de la technologie, Je comprends la logique d'utiliser la sagesse des foules dans ces algorithmes. Je vois également des pièges importants dans la façon dont les sociétés de médias sociaux le font dans la pratique.

A la veille des élections de 2020, les fermes à trolls exploitaient de vastes réseaux de pages sur FB ciblant Christian, Le noir, &Amérindiens. Un rapport interne retraçant la situation l'a décrite comme "vraiment horrible". Certaines pages restent deux ans plus tard. https://t.co/Wa43f8rG0N

– Karen Hao (@_KarenHao) 17 septembre, 2021

Des lions de la savane aux likes sur Facebook

Le concept de la sagesse des foules suppose qu'en utilisant les signaux des actions des autres, les opinions et les préférences comme guide conduiront à des décisions judicieuses. Par exemple, les prédictions collectives sont normalement plus précises que les prédictions individuelles. L'intelligence collective est utilisée pour prédire les marchés financiers, des sports, élections et même des épidémies.

Au cours de millions d'années d'évolution, ces principes ont été codés dans le cerveau humain sous la forme de biais cognitifs accompagnés de noms tels que familiarité, simple exposition et effet d'entraînement. Si tout le monde se met à courir, vous devriez également commencer à courir; peut-être que quelqu'un a vu un lion venir et courir pourrait vous sauver la vie. Vous ne savez peut-être pas pourquoi, mais il est plus sage de poser des questions plus tard.

Votre cerveau capte des indices de l'environnement, y compris de vos pairs, et utilise des règles simples pour traduire rapidement ces signaux en décisions : Partez avec le gagnant, suivre la majorité, copier votre voisin. Ces règles fonctionnent remarquablement bien dans des situations typiques car elles sont basées sur des hypothèses solides. Par exemple, ils supposent que les gens agissent souvent de manière rationnelle, il est peu probable que beaucoup se trompent, le passé prédit l'avenir, etc.

La technologie permet aux gens d'accéder aux signaux d'un plus grand nombre d'autres personnes, dont la plupart ne connaissent pas. Les applications d'intelligence artificielle font un usage intensif de ces signaux de popularité ou d'« engagement », de la sélection des résultats des moteurs de recherche à la recommandation de musique et de vidéos, et de la suggestion d'amis au classement des publications sur les fils d'actualité.

Tout ce qui est viral ne mérite pas d'être

Nos recherches montrent que pratiquement toutes les plateformes technologiques Web, tels que les réseaux sociaux et les systèmes de recommandation d'actualités, ont un fort biais de popularité. Lorsque les applications sont motivées par des indices tels que l'engagement plutôt que par des requêtes explicites de moteur de recherche, le biais de popularité peut entraîner des conséquences imprévues néfastes.

Les réseaux sociaux comme Facebook, Instagram, Twitter, YouTube et TikTok s'appuient fortement sur des algorithmes d'IA pour classer et recommander du contenu. Ces algorithmes prennent en entrée ce que vous aimez, commenter et partager, en d'autres termes, contenu avec lequel vous interagissez. L'objectif des algorithmes est de maximiser l'engagement en découvrant ce que les gens aiment et en le classant en haut de leurs flux.

En surface, cela semble raisonnable. Si les gens aiment les nouvelles crédibles, avis d'experts et vidéos amusantes, ces algorithmes devraient identifier un tel contenu de haute qualité. Mais la sagesse des foules fait ici une hypothèse clé :que recommander ce qui est populaire aidera un contenu de haute qualité à « bouillonner ».

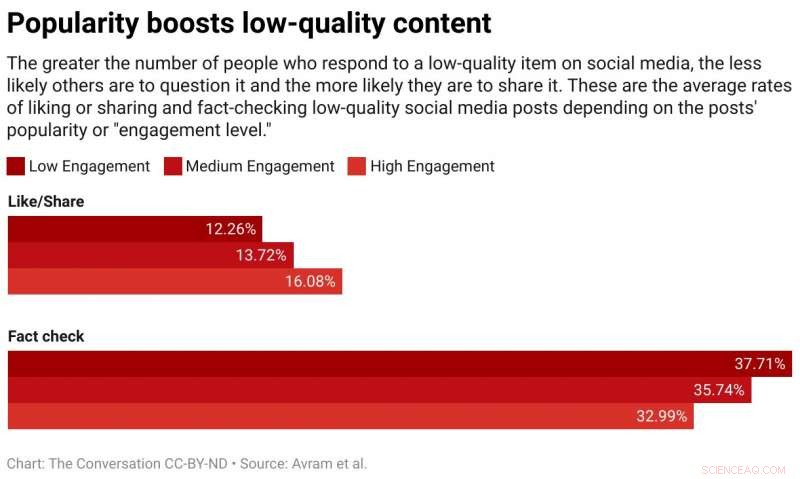

Nous avons testé cette hypothèse en étudiant un algorithme qui classe les éléments en utilisant un mélange de qualité et de popularité. Nous avons constaté qu'en général, le biais de popularité est plus susceptible de réduire la qualité globale du contenu. La raison en est que l'engagement n'est pas un indicateur fiable de qualité lorsque peu de personnes ont été exposées à un élément. Dans ces cas, l'engagement génère un signal bruyant, et l'algorithme est susceptible d'amplifier ce bruit initial. Une fois que la popularité d'un article de mauvaise qualité est suffisamment importante, il va continuer à s'amplifier.

Les algorithmes ne sont pas la seule chose affectée par le biais d'engagement, ils peuvent également affecter les gens. Les preuves montrent que l'information est transmise par « contagion complexe, " ce qui signifie que plus les gens sont exposés à une idée en ligne, plus ils sont susceptibles de l'adopter et de le partager. Lorsque les médias sociaux disent aux gens qu'un article devient viral, leurs biais cognitifs se manifestent et se traduisent par l'envie irrésistible d'y prêter attention et de le partager.

Des foules pas si sages

Nous avons récemment mené une expérience à l'aide d'une application d'alphabétisation appelée Fakey. C'est un jeu développé par notre laboratoire, qui simule un fil d'actualité comme ceux de Facebook et Twitter. Les joueurs voient un mélange d'articles actuels de fausses nouvelles, science indésirable, sources hyperpartisanes et complotistes, ainsi que les sources principales. Ils obtiennent des points pour partager ou aimer des informations provenant de sources fiables et pour signaler des articles peu crédibles à des fins de vérification des faits.

Nous avons constaté que les joueurs sont plus susceptibles d'aimer ou de partager et moins susceptibles de signaler des articles provenant de sources peu crédibles lorsque les joueurs peuvent voir que de nombreux autres utilisateurs ont interagi avec ces articles. L'exposition aux métriques d'engagement crée donc une vulnérabilité.

La sagesse des foules échoue parce qu'elle est fondée sur la fausse hypothèse que la foule est composée de divers, sources indépendantes. Il peut y avoir plusieurs raisons pour lesquelles ce n'est pas le cas.

D'abord, en raison de la tendance des gens à s'associer avec des personnes similaires, leurs quartiers en ligne ne sont pas très diversifiés. La facilité avec laquelle les utilisateurs de médias sociaux peuvent se désintéresser de ceux avec qui ils sont en désaccord pousse les gens dans des communautés homogènes, souvent appelées chambres d'écho.

Seconde, parce que les amis de beaucoup de gens sont amis les uns des autres, ils s'influencent mutuellement. Une expérience célèbre a démontré que savoir quelle musique vos amis aiment affecte vos propres préférences déclarées. Votre désir social de vous conformer fausse votre jugement indépendant.

Troisième, les signaux de popularité peuvent être joués. Au cours des années, les moteurs de recherche ont développé des techniques sophistiquées pour contrer ce que l'on appelle les « fermes de liens » et d'autres schémas visant à manipuler les algorithmes de recherche. Plateformes de médias sociaux, d'autre part, commencent tout juste à se renseigner sur leurs propres vulnérabilités.

Des personnes visant à manipuler le marché de l'information ont créé de faux comptes, comme les trolls et les robots sociaux, et organisé de faux réseaux. Ils ont inondé le réseau pour donner l'impression qu'une théorie du complot ou un candidat politique est populaire, tromper à la fois les algorithmes de la plate-forme et les biais cognitifs des gens. Ils ont même modifié la structure des réseaux sociaux pour créer des illusions sur les opinions majoritaires.

Réduire l'engagement

Que faire? Les plateformes technologiques sont actuellement sur la défensive. Ils deviennent plus agressifs pendant les élections en démantelant les faux comptes et la désinformation préjudiciable. Mais ces efforts peuvent s'apparenter à un jeu de taupe.

Un autre, approche préventive serait d'ajouter des frictions. En d'autres termes, ralentir le processus de diffusion de l'information. Les comportements à haute fréquence tels que le goût et le partage automatisés pourraient être inhibés par les tests ou les frais CAPTCHA. Non seulement cela réduirait les possibilités de manipulation, mais avec moins d'informations, les gens seraient en mesure de prêter plus d'attention à ce qu'ils voient. Cela laisserait moins de place au biais d'engagement pour affecter les décisions des gens.

Cela aiderait également si les sociétés de médias sociaux ajustaient leurs algorithmes pour se fier moins à l'engagement pour déterminer le contenu qu'elles vous servent. Peut-être que les révélations de la connaissance de Facebook sur les fermes de trolls exploitant l'engagement donneront l'impulsion nécessaire.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.