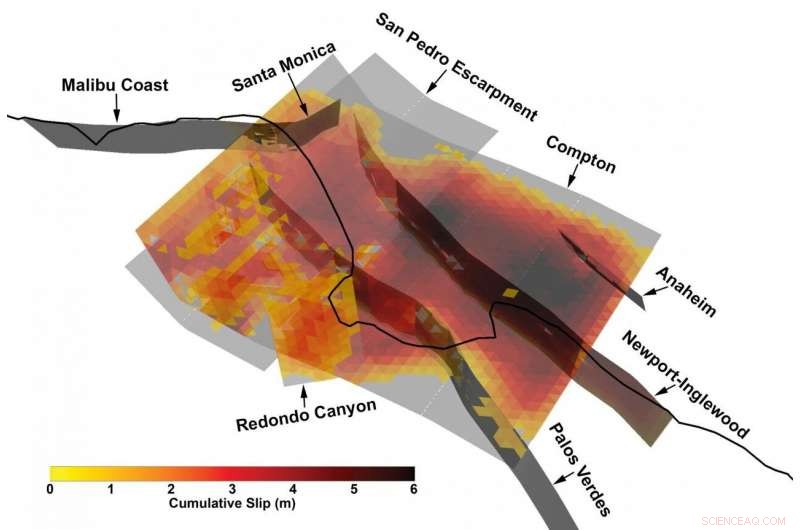

Vue 3D d'une rupture multi-failles particulièrement complexe du catalogue synthétique des tremblements de terre développé par le Southern California Earthquake Center à l'aide d'un nouveau cadre de modélisation des tremblements de terre. Crédit :Kevin Milner, Université de Californie du Sud

Les tremblements de terre massifs sont, Heureusement, événements rares. Mais cette rareté d'informations nous aveugle d'une certaine manière sur leurs risques, surtout lorsqu'il s'agit de déterminer le risque pour un emplacement ou une structure spécifique.

"Nous n'avons pas observé la plupart des événements possibles qui pourraient causer de gros dégâts, " a expliqué Kevin Milner, informaticien et chercheur en sismologie au Southern California Earthquake Center (SCEC) de l'Université de Californie du Sud. "En prenant le sud de la Californie comme exemple, nous n'avons pas eu de véritable tremblement de terre depuis 1857 - c'était la dernière fois que le sud de San Andreas a éclaté en un énorme tremblement de terre de magnitude 7,9. Un tremblement de terre de San Andreas pourrait affecter une zone beaucoup plus vaste que le tremblement de terre de Northridge de 1994, et d'autres grands tremblements de terre peuvent également se produire. C'est ce qui nous inquiète."

La façon traditionnelle de contourner ce manque de données consiste à creuser des tranchées pour en savoir plus sur les ruptures passées, rassembler des informations sur de nombreux tremblements de terre dans le monde et créer un modèle statistique de risque, ou en utilisant des superordinateurs pour simuler un tremblement de terre spécifique dans un endroit spécifique avec un haut degré de fidélité.

Cependant, un nouveau cadre de prévision de la probabilité et de l'impact des séismes sur l'ensemble d'une région, développé par une équipe de chercheurs associés au SCEC au cours de la dernière décennie, a trouvé un terrain d'entente et peut-être une meilleure façon de déterminer le risque.

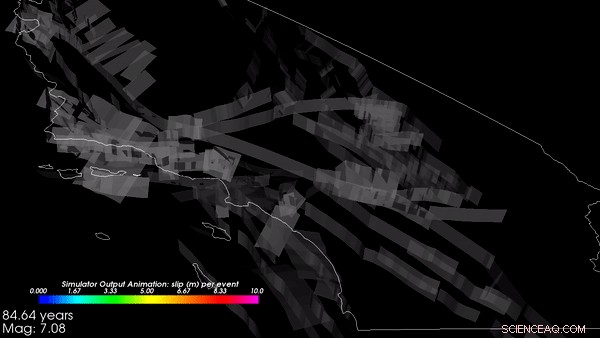

Une nouvelle étude dirigée par Milner et Bruce Shaw de l'Université de Columbia, publié dans le Bulletin de la Société sismologique d'Amérique en janvier 2021, présente les résultats d'un prototype de simulateur de séisme Rate-State, ou RSQSim, qui simule des centaines de milliers d'années d'histoire sismique en Californie. Couplé avec un autre code, CyberShake, le cadre peut calculer la quantité de secousses qui se produirait pour chaque séisme. Leurs résultats se comparent bien avec les séismes historiques et les résultats d'autres méthodes, et afficher une distribution réaliste des probabilités de tremblement de terre.

Selon les développeurs, la nouvelle approche améliore la capacité de déterminer l'ampleur d'un tremblement de terre dans un endroit donné, permettant aux développeurs de code du bâtiment, architectes, et des ingénieurs en structure pour concevoir des bâtiments plus résistants qui peuvent survivre aux tremblements de terre sur un site spécifique.

"Pour la première fois, nous avons tout un pipeline du début à la fin où l'occurrence des tremblements de terre et la simulation des mouvements du sol sont basées sur la physique, " a déclaré Milner. " Il peut simuler jusqu'à 100, des milliers d'années sur un système de failles vraiment compliqué."

Appliquer une puissance informatique massive aux gros problèmes

RSQSim transforme les représentations mathématiques des forces géophysiques en jeu dans les séismes - le modèle standard de la nucléation et de la propagation des ruptures - en algorithmes, puis les résout sur certains des supercalculateurs les plus puissants de la planète. La recherche à forte intensité de calcul a été rendue possible sur plusieurs années par des superordinateurs parrainés par le gouvernement au Texas Advanced Computing Center, y compris Frontera, le système le plus puissant de toutes les universités au monde, Blue Waters du National Center for Supercomputing Applications, et Sommet à l'installation informatique de leadership d'Oak Ridge.

« Une façon dont nous pourrions être en mesure de mieux prédire les risques est la modélisation basée sur la physique, en exploitant la puissance de systèmes comme Frontera pour exécuter des simulations, " a déclaré Milner. " Au lieu d'une distribution statistique empirique, nous simulons l'occurrence des tremblements de terre et la propagation de ses ondes."

"Nous avons fait beaucoup de progrès sur Frontera pour déterminer à quel type de tremblements de terre nous pouvons nous attendre, sur quelle faute, et à quelle fréquence, " a déclaré Christine Goulet, Directeur exécutif des sciences appliquées au SCEC, également impliqués dans les travaux. "Nous ne prescrivons ni ne disons au code quand les tremblements de terre vont se produire. Nous lançons une simulation de centaines de milliers d'années, et laissez simplement le code transférer le stress d'un défaut à un autre."

Les simulations ont commencé avec la topographie géologique de la Californie et ont simulé plus de 800, 000 années virtuelles comment les contraintes se forment et se dissipent lorsque les forces tectoniques agissent sur la Terre. A partir de ces simulations, le cadre a généré un catalogue - un enregistrement qu'un tremblement de terre s'est produit à un certain endroit avec une certaine magnitude et des attributs à un moment donné. Le catalogue que l'équipe SCEC a produit sur Frontera et Blue Waters était parmi les plus importants jamais réalisés, dit Goulet. Les sorties de RSQSim ont ensuite été introduites dans CyberShake qui a de nouveau utilisé des modèles informatiques de géophysique pour prédire combien de secousses (en termes d'accélération du sol, ou la vitesse, et durée) se produiraient à la suite de chaque séisme.

« Le cadre fournit une histoire complète du temps de glissement :où une rupture se produit et comment elle s'est développée, " expliqua Milner. " Nous avons découvert qu'il produisait des mouvements du sol réalistes, ce qui nous dit que la physique implémentée dans le modèle fonctionne comme prévu." Ils ont plus de travail prévu pour la validation des résultats, ce qui est critique avant l'acceptation pour les applications de conception.

Les chercheurs ont découvert que le cadre RSQSim produit de riches, des tremblements de terre variables dans l'ensemble - un signe qu'il produit des résultats raisonnables - tout en générant également des effets de source et de chemin reproductibles.

Un 3 choisi au hasard, Segment de 000 ans du catalogue simulé basé sur la physique des tremblements de terre en Californie, créé sur Frontera. Crédit :Kevin Milner, Université de Californie du Sud

"Pour beaucoup de sites, le risque de tremblement diminue, par rapport aux estimations de l'état de la pratique", a déclaré Milner. "Mais pour quelques sites qui ont des configurations spéciales de failles à proximité ou de caractéristiques géologiques locales, comme près de San Bernardino, le danger est monté. Nous travaillons à mieux comprendre ces résultats et à définir des approches pour les vérifier. »

Les travaux aident à déterminer la probabilité qu'un tremblement de terre se produise le long de l'une des centaines de failles sismiques de Californie, l'ampleur du tremblement de terre auquel on pouvait s'attendre, et comment cela peut déclencher d'autres tremblements de terre.

Le soutien au projet provient de l'U.S. Geological Survey (USGS), Fondation nationale des sciences (NSF), et le W.M. Fondation Keck. Frontera est la ressource nationale de classe dirigeante de la NSF. Le temps de calcul sur Frontera a été fourni par le biais d'un prix de partenariat communautaire à grande échelle (LSCP) décerné au SCEC, qui permet à des centaines d'universitaires américains d'accéder à la machine pour étudier de nombreux aspects de la science des tremblements de terre. Les bourses LSCP offrent des allocations prolongées pouvant aller jusqu'à trois ans pour soutenir les efforts de recherche à long terme. SCEC, qui a été fondé en 1991 et qui calcule sur les systèmes TACC depuis plus d'une décennie, est un excellent exemple d'un tel effort.

La création du catalogue a nécessité huit jours de calcul continu sur Frontera et en a utilisé plus de 3, 500 processeurs en parallèle. Simuler le tremblement de terre sur 10 sites à travers la Californie a nécessité une quantité de calcul comparable sur Summit, le deuxième supercalculateur le plus rapide au monde.

« L'adoption par la communauté au sens large sera naturellement lente, " a déclaré Milner. " Parce que de tels résultats auront un impact sur la sécurité, cela fait partie de notre diligence raisonnable de nous assurer que ces résultats sont techniquement défendables par l'ensemble de la communauté, " a ajouté Goulet. Mais des résultats de recherche comme ceux-ci sont importants pour aller au-delà des codes du bâtiment généralisés qui, dans certains cas, peuvent représenter de manière inadéquate le risque auquel une région est confrontée alors que dans d'autres cas, ils sont trop conservateurs.

« L'espoir est que ces types de modèles nous aideront à mieux caractériser l'aléa sismique. Nous dépensons donc nos ressources pour construire de solides, en sécurité, des bâtiments résilients là où ils sont le plus nécessaires, ", a déclaré Milner.