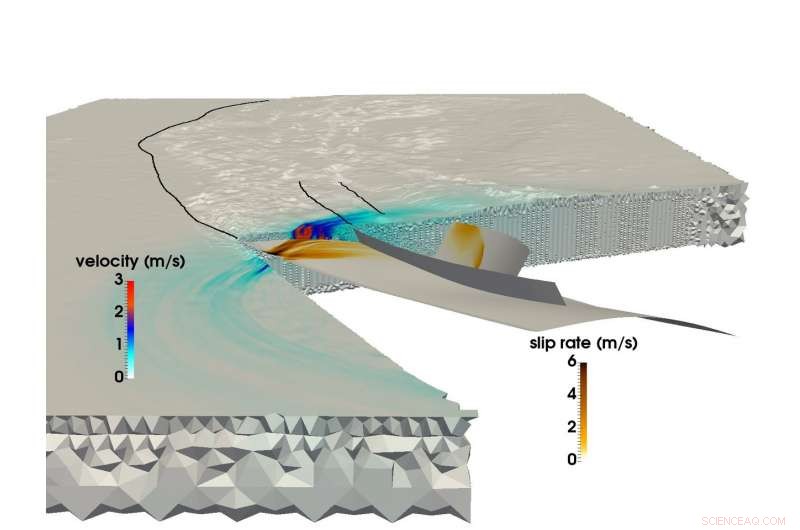

En utilisant le supercalculateur SuperMUC de LRZ, une équipe de recherche conjointe de l'Université technique de Munich et de Ludwigs-Maximilians-Uni Munich a pu créer la plus grande simulation multiphysique d'un tremblement de terre et d'un tsunami. Cette image montre la propagation de la rupture et le champ d'ondes sismiques résultant lors du séisme de Sumatra-Andaman en 2004. Crédit :C. Uphoff, S.Rettenberger, Monsieur Bader, Université technique de Munich. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

Juste avant 8h00 heure locale le 26 décembre, 2004, les habitants de l'Asie du Sud-Est commençaient leurs jours lorsque le troisième plus fort tremblement de terre enregistré de l'histoire a déclenché un 1, Une déchirure de 500 kilomètres dans le fond de l'océan au large des côtes de l'île indonésienne de Sumatra.

Le séisme a duré entre 8 et 10 minutes (l'un des plus longs jamais enregistrés), et soulevé le fond de l'océan de plusieurs mètres, créant un tsunami avec des vagues de 30 mètres qui ont dévasté des communautés entières. L'événement a causé près de 200, 000 décès dans 15 pays, et libéré autant d'énergie au-dessus et au-dessous du sol que plusieurs siècles d'utilisation de l'énergie aux États-Unis.

Le tremblement de terre de Sumatra-Andaman, comme on l'appelle, était aussi surprenant que violent. Malgré des avancées majeures dans les systèmes de surveillance et d'alerte aux tremblements de terre au cours des 50 dernières années, les scientifiques de la Terre n'ont pas été en mesure de le prédire car il existe relativement peu de données sur des événements sismologiques à grande échelle. Les chercheurs disposent d'une mine d'informations sur les activités semi-régulières, tremblements de terre de force faible à moyenne, mais des catastrophes telles que le Sumatra-Andaman - des événements qui ne se produisent que tous les deux cents ans - sont trop rares pour créer des ensembles de données fiables.

Afin de mieux comprendre ces événements, et, espérons-le, fournir de meilleures méthodes de prédiction et d'atténuation, une équipe de chercheurs de la Ludwig-Maximilians-Universität Munich (LMU) et de l'Université technique de Munich (TUM) utilise les ressources de calcul intensif du Leibniz Supercomputing Center (LRZ) pour mieux comprendre ces rares, phénomènes sismiques extrêmement dangereux.

"Notre motivation générale est de mieux comprendre l'ensemble du processus expliquant pourquoi certains tremblements de terre et les tsunamis qui en résultent sont tellement plus importants que d'autres, " a déclaré le professeur TUM Dr. Michael Bader. " Parfois, nous voyons des tsunamis relativement petits lorsque les tremblements de terre sont importants, ou des tsunamis étonnamment importants liés à des tremblements de terre relativement faibles. La simulation est l'un des outils pour avoir un aperçu de ces événements."

L'équipe s'efforce de réaliser des simulations "couplées" à la fois des tremblements de terre et des tsunamis ultérieurs. Il a récemment terminé sa plus grande simulation de tremblement de terre à ce jour. En utilisant le supercalculateur SuperMUC du LRZ, l'équipe a pu simuler 1, 500 kilomètres de mécanique de rupture non linéaire - la source du séisme - couplée à des ondes sismiques se propageant jusqu'en Inde et en Thaïlande pendant un peu plus de 8 minutes du séisme de Sumatra-Andaman. Grâce à plusieurs innovations informatiques internes, l'équipe a réalisé une amélioration de 13 fois dans le temps de résolution. En reconnaissance de cette réalisation, le projet a été nominé pour le prix du meilleur article au SC17, l'une des plus importantes conférences mondiales sur le calcul intensif, tenue cette année du 12 au 17 novembre à Denver, Colorado.

Séismes de méga-poussée, simulations à grande échelle

Les tremblements de terre se produisent lorsque la roche sous la surface de la Terre se brise soudainement, souvent en raison du mouvement lent des plaques tectoniques.

Un prédicteur approximatif de la capacité d'un tremblement de terre océanique à déclencher un grand tsunami est de savoir si les plaques se frottent les unes contre les autres ou entrent en collision frontale. Si deux plaques ou plus entrent en collision, une plaque forcera souvent l'autre en dessous. Les régions où ce processus se produit sont appelées zones de subduction et peuvent héberger de très grandes, failles à faible pendage, appelées « megathrusts ». La libération d'énergie à travers ces énormes zones de faiblesse a tendance à créer de violents tsunamis, alors que le fond de l'océan s'élève considérablement, déplacer temporairement de grandes quantités d'eau.

Jusque récemment, bien que, les chercheurs faisant de la géophysique informatique ont eu de grandes difficultés à simuler des séismes de subduction au niveau de détail et de précision nécessaire. Les simulations de séismes à grande échelle sont généralement difficiles, mais les événements de subduction sont encore plus complexes.

"La modélisation des séismes est un problème multi-échelles dans l'espace et dans le temps, " a déclaré le Dr Alice Gabriel, le chercheur principal du côté LMU de l'équipe. « La réalité est complexe, c'est-à-dire que la prise en compte de la complexité observée des sources sismiques passe invariablement par l'utilisation de méthodes numériques, logiciel de simulation très performant, et, bien sûr, calcul haute performance (HPC). Ce n'est qu'en exploitant le HPC que nous pouvons créer des modèles capables à la fois de résoudre le relâchement dynamique des contraintes et les ruptures se produisant lors d'un tremblement de terre tout en simulant également le déplacement du fond marin sur des milliers de kilomètres. »

Lorsque les chercheurs simulent un tremblement de terre, ils utilisent une grille de calcul pour diviser la simulation en plusieurs petits morceaux. Ils calculent ensuite des équations spécifiques pour divers aspects de la simulation, tels que les secousses sismiques générées ou le déplacement du fond océanique, entre autres, sur des "pas de temps, " ou des instantanés de simulation au fil du temps qui aident à le mettre en mouvement, un peu comme un flip book.

Plus la grille est fine, plus la simulation est précise, mais plus il devient exigeant en termes de calcul. En outre, plus la géométrie du séisme est complexe, plus la grille devient complexe, complique encore le calcul. Pour simuler des séismes de subduction, les informaticiens doivent créer une grande grille qui peut également représenter avec précision les angles très faibles auxquels les deux plaques continentales se rencontrent. Cela nécessite que les cellules de la grille autour de la zone de subduction soient très petites, et souvent de forme mince.

Contrairement aux tremblements de terre continentaux, qui ont été mieux documentés par le calcul et l'observation, les événements de subduction se produisent souvent au plus profond de l'océan, ce qui signifie qu'il est beaucoup plus difficile de contraindre une simulation par des observations de tremblement de terre et détaillées, des données fiables provenant d'observations directes et d'expériences en laboratoire.

Par ailleurs, le calcul d'un couplé, la simulation séisme-tsunami à grande échelle nécessite l'utilisation de données provenant d'une grande variété de sources. Les chercheurs doivent tenir compte de la forme du fond marin, la forme et la résistance de la limite de plaque rompue par le séisme et le comportement matériel de la croûte terrestre à chaque niveau, entre autres aspects. L'équipe a passé les dernières années à développer des méthodes pour intégrer plus efficacement ces sources de données disparates dans un modèle cohérent.

Pour réduire l'énorme temps de calcul, l'équipe a exploité une méthode appelée « pas de temps local ». Dans les zones où les simulations nécessitent beaucoup plus de détails spatiaux, les chercheurs doivent également « ralentir » la simulation en effectuant plus de pas de temps dans ces domaines. D'autres sections qui nécessitent moins de détails peuvent exécuter des pas de temps beaucoup plus grands et donc beaucoup moins longs.

Si l'équipe devait exécuter toute sa simulation à un petit pas de temps uniforme, il aurait fallu environ 3 millions d'itérations individuelles. Cependant, seules quelques cellules de la grille de calcul nécessitaient cette taille de pas de temps. Les parties principales pourraient être calculées avec des pas de temps beaucoup plus grands, certains ne nécessitant que 3000 pas de temps. Cela a considérablement réduit la demande de calcul et a permis à une grande partie de l'accélération de 13 fois de l'équipe. Cette avancée a également conduit à ce que la simulation de l'équipe soit la plus grande, la plus longue simulation de principes premiers d'un séisme de ce type.

Mouvement vers l'avant

En raison de sa collaboration étroite avec le personnel de LRZ, l'équipe a eu l'occasion d'utiliser l'ensemble de la machine SuperMUC pour ses simulations. Bader a indiqué que ces courses à très grande échelle sont inestimables pour que l'équipe puisse approfondir ses recherches. « Il y a une grande différence si vous utilisez un quart de machine ou une machine complète, comme ce dernier facteur de 4 révèle souvent les goulots d'étranglement critiques, " il a dit.

La capacité de l'équipe à tirer pleinement parti des ressources de calcul intensif de la génération actuelle l'a enthousiasmée pour l'avenir. Il n'est pas nécessairement important que les machines de la prochaine génération offrent aux chercheurs du LMU-TUM la possibilité d'exécuter des simulations « plus grandes » :les simulations actuelles peuvent simuler efficacement une zone géographique suffisamment grande. Plutôt, l'équipe est enthousiasmée par la possibilité de modifier les données d'entrée et d'exécuter de nombreuses autres itérations pendant un temps de calcul défini.

"Nous avons fait une simulation individuelle, essayer de deviner avec précision la configuration de départ, telles que les contraintes et forces initiales, mais tout cela est encore incertain, " Bader a déclaré. "Nous aimerions donc exécuter notre simulation avec de nombreux paramètres différents pour voir comment de légers changements dans le système de défaillance ou d'autres facteurs auraient un impact sur l'étude. Il s'agirait d'études de paramètres plus vastes, ce qui est une autre couche de performances qu'un ordinateur devrait fournir."

Gabriel a également mentionné que les machines de la prochaine génération seront, espérons-le, capables de simuler des des scénarios en temps réel qui peuvent aider à prévoir les dangers liés aux régions susceptibles de répliques. L'équipe est ravie de voir les architectures de nouvelle génération au LRZ et dans les autres centres Gauss Center for Supercomputing, le High-Performance Computing Center de Stuttgart et le Jülich Supercomputing Center.

De l'avis de Bader, le travail récent de l'équipe représente non seulement sa simulation à plus grande échelle à ce jour, mais aussi la collaboration de plus en plus forte entre les scientifiques du domaine et les informaticiens du groupe. "Cet article a une forte composante sismologie et une forte composante HPC, " at-il dit. " C'est vraiment un papier 50-50 pour nous. Notre collaboration se passe bien, et c'est parce qu'il ne s'agit pas d'obtenir le nôtre ou le leur. Les deux groupes en profitent, et c'est vraiment un beau travail commun."