Dans le jeu d'exploration scout, pour s'aligner sur les valeurs humaines, le robot apprend des réactions humaines aux propositions. Crédit d'image :Mme Zhen Chen@BIGAI.

Les méthodes d'intelligence artificielle (IA) sont devenues de plus en plus avancées au cours des dernières décennies, atteignant des résultats remarquables dans de nombreuses tâches du monde réel. Néanmoins, la plupart des systèmes d'IA existants ne partagent pas leurs analyses et les étapes qui ont conduit à leurs prédictions avec les utilisateurs humains, ce qui peut rendre leur évaluation fiable extrêmement difficile.

Un groupe de chercheurs de l'UCLA, de l'UCSD, de l'Université de Pékin et de l'Institut d'intelligence artificielle générale de Pékin (BIGAI) a récemment développé un nouveau système d'IA capable d'expliquer ses processus de prise de décision aux utilisateurs humains. Ce système, présenté dans un article publié dans Science Robotics , pourrait être une nouvelle étape vers la création d'une IA plus fiable et compréhensible.

"Le domaine de l'IA explicable (XAI) vise à établir une confiance collaborative entre les robots et les humains, et le projet DARPA XAI a servi de catalyseur pour faire avancer la recherche dans ce domaine", a déclaré le Dr Luyao Yuan, l'un des premiers auteurs de l'article. , a déclaré TechXplore. "Au début du projet DARPA XAI, les équipes de recherche se concentrent principalement sur l'inspection des modèles pour les tâches de classification en révélant le processus de décision des systèmes d'IA à l'utilisateur ; par exemple, certains modèles peuvent visualiser certaines couches de modèles CNN, prétendant atteindre un certain niveau de XAI."

Le Dr Yuan et ses collègues ont participé au projet DARPA XAI, qui visait spécifiquement à développer de nouveaux systèmes XAI prometteurs. Tout en participant au projet, ils ont commencé à réfléchir à ce que signifierait XAI au sens large, notamment aux effets qu'il pourrait avoir sur les collaborations entre l'homme et la machine.

Le récent article de l'équipe s'appuie sur l'un de leurs travaux précédents, également publié dans Science Robotics , où l'équipe a exploré l'impact que les systèmes explicables pourraient avoir sur les perceptions et la confiance d'un utilisateur dans l'IA lors d'interactions homme-machine. Dans leur étude précédente, l'équipe a mis en œuvre et testé physiquement un système d'IA (c'est-à-dire dans le monde réel), tandis que dans leur nouvelle étude, ils l'ont testé dans des simulations.

"Notre paradigme contraste avec presque tous ceux proposés par les équipes du programme DARPA XAI, qui se concentraient principalement sur ce que nous appelons le paradigme machine passive-utilisateur actif", a déclaré le professeur Yixin Zhu, l'un des superviseurs du projet, à TechXplore. "Dans ces paradigmes, les utilisateurs humains doivent activement vérifier et tenter de comprendre ce que fait la machine (donc 'utilisateur actif') en tirant parti de certains modèles qui révèlent le processus de prise de décision potentiel des modèles d'IA."

Les systèmes XAI qui suivent ce que le professeur Zhu appelle le paradigme « utilisateur passif-machine active » exigent que les utilisateurs se connectent constamment à l'IA pour comprendre les processus qui sous-tendent ses décisions. Dans ce contexte, la compréhension d'un utilisateur des processus d'une IA et la confiance dans ses prédictions n'ont pas d'impact sur les futurs processus de prise de décision de l'IA, c'est pourquoi la machine est qualifiée de "passive".

En revanche, le nouveau paradigme introduit par le Dr Yuan, le professeur Zhu et leurs collègues suit ce que l'équipe appelle un paradigme d'utilisateur actif-machine actif. Cela signifie essentiellement que leur système peut activement apprendre et adapter sa prise de décision en fonction des commentaires qu'il reçoit des utilisateurs à la volée. Cette capacité à s'adapter au contexte est caractéristique de ce que l'on appelle souvent la troisième/prochaine vague d'IA.

"Pour que les systèmes d'IA assistent leurs utilisateurs comme nous l'attendons, les systèmes actuels exigent que l'utilisateur code dans des objectifs définis par des experts", a déclaré le Dr Yuan. "Cela limite le potentiel de l'équipe homme-machine, car de tels objectifs peuvent être difficiles à définir dans de nombreuses tâches, rendant les systèmes d'IA inaccessibles à la plupart des gens. Pour résoudre ce problème, notre travail permet aux robots d'estimer les intentions et les valeurs des utilisateurs pendant la collaboration. en temps réel, ce qui évite d'avoir à coder au préalable des objectifs complexes et spécifiques pour les robots, offrant ainsi un meilleur paradigme d'association homme-machine."

Le but du système créé par le Dr Yuan et ses collègues est d'atteindre ce qu'on appelle « l'alignement des valeurs ». Cela signifie essentiellement qu'un utilisateur humain peut comprendre pourquoi un robot ou une machine agit d'une manière spécifique ou parvient à des conclusions spécifiques, et la machine ou le robot peut déduire pourquoi l'utilisateur humain agit d'une manière spécifique. Cela peut améliorer considérablement la communication homme-robot.

"Cette nature bidirectionnelle et ces performances en temps réel sont les plus grands défis du problème et le point culminant de nos contributions", a déclaré le professeur Zhu. "En rassemblant les points ci-dessus, je pense que vous comprendrez maintenant pourquoi le titre de notre article est" Alignement bidirectionnel in situ des valeurs homme-robot ".

Pour former et tester leur système XAI, les chercheurs ont conçu un jeu appelé "exploration scoute", dans lequel les humains doivent accomplir une tâche en équipe. L'un des aspects les plus importants de ce jeu est que les humains et les robots doivent aligner leurs soi-disant "fonctions de valeur".

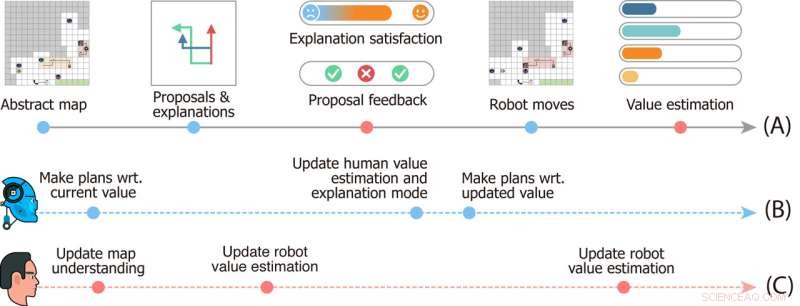

Conception de l'étude du jeu d'exploration Scout. La chronologie (A) indique les événements qui se produisent au cours d'une seule manche du jeu. Les chronologies (B) et (C) décrivent la dynamique mentale des robots et de l'utilisateur, respectivement. Crédit d'image :Mme Zhen Chen@BIGAI.

« Dans le jeu, un groupe de robots peut percevoir l'environnement; cela émule des applications du monde réel où le groupe de robots est censé travailler de manière autonome pour minimiser les interventions humaines », a déclaré le professeur Zhu. "L'utilisateur humain, cependant, ne peut pas interagir directement avec l'environnement ; à la place, l'utilisateur a reçu une fonction de valeur particulière, représentée par l'importance de quelques facteurs (par exemple, le temps total pour terminer le temps et les ressources collectées en déplacement )."

Dans le jeu d'exploration scout, l'équipe de robots n'a pas accès à la fonction de valeur donnée aux utilisateurs humains, et ils doivent l'inférer. Comme cette valeur ne peut pas être facilement exprimée et communiquée, pour terminer la tâche, le robot et l'équipe humaine doivent la déduire l'un de l'autre.

"La communication est bidirectionnelle dans le jeu :d'une part, le robot propose plusieurs plans de tâches à l'utilisateur et explique le pour et le contre de chacun d'entre eux, et d'autre part l'utilisateur fait un retour sur les propositions et note chaque explication, " Le Dr Xiaofeng Gao, l'un des premiers auteurs de l'article, a déclaré à TechXplore. "Ces communications bidirectionnelles permettent ce que l'on appelle l'alignement des valeurs."

Essentiellement, pour accomplir des tâches dans "l'exploration scoute", l'équipe de robots doit comprendre ce que la fonction de valeur des utilisateurs humains est simplement basée sur la rétroaction de l'humain. Pendant ce temps, les utilisateurs humains apprennent les estimations de valeur actuelles des robots et peuvent offrir des commentaires qui les aident à s'améliorer et les guident finalement vers la réponse correcte.

"Nous avons également intégré la théorie de l'esprit dans notre modèle informatique, permettant au système d'IA de générer des explications appropriées pour révéler sa valeur actuelle et estimer la valeur des utilisateurs à partir de leurs commentaires en temps réel pendant l'interaction", a déclaré le Dr Gao. "Nous avons ensuite mené des études approfondies auprès des utilisateurs pour évaluer notre cadre."

Lors des premières évaluations, le système créé par le Dr Yuan, le professeur Zhu, le Dr Gao et leurs collègues a obtenu des résultats remarquables, conduisant à l'alignement des valeurs dans le jeu d'exploration scout à la volée et de manière interactive. L'équipe a découvert que le robot s'alignait sur la fonction de valeur de l'utilisateur humain dès 25 % dans le jeu, tandis que les utilisateurs pouvaient obtenir des perceptions précises des fonctions de valeur de la machine à mi-chemin du jeu.

"L'appariement de la convergence (i) de la valeur des robots aux vraies valeurs de l'utilisateur et (ii) de l'estimation par l'utilisateur des valeurs des robots aux valeurs actuelles des robots forme un alignement de valeurs bidirectionnel ancré par la vraie valeur de l'utilisateur", a déclaré le Dr dit Yuan. "Nous pensons que notre cadre met en évidence la nécessité de construire des machines intelligentes qui apprennent et comprennent nos intentions et nos valeurs par le biais d'interactions, ce qui est essentiel pour éviter bon nombre des histoires de science-fiction dystopiques décrites dans les romans et sur grand écran."

Les travaux récents de cette équipe de chercheurs constituent une contribution significative au domaine de la recherche axé sur le développement d'une IA plus compréhensible. Le système qu'ils ont proposé pourrait servir d'inspiration pour la création d'autres systèmes XAI où des robots ou des assistants intelligents interagissent activement avec les humains, partageant leurs processus et améliorant leurs performances en fonction des commentaires qu'ils reçoivent des utilisateurs.

"L'alignement des valeurs est notre première étape vers une collaboration générique homme-robot", a expliqué le Dr Yuan. "Dans ce travail, l'alignement des valeurs se produit dans le contexte d'une seule tâche. Cependant, dans de nombreux cas, un groupe d'agents coopère dans de nombreuses tâches. Par exemple, nous nous attendons à ce qu'un robot domestique nous aide dans de nombreuses tâches quotidiennes, au lieu d'acheter de nombreux robots, chacun capable de faire un seul type de travail."

Jusqu'à présent, le système XAI des chercheurs a obtenu des résultats très prometteurs. Dans leurs prochaines études, le Dr Yuan, le professeur Zhu, le Dr Gao et leurs collègues prévoient d'explorer des exemples d'alignement des valeurs homme-robot qui pourraient être appliqués à de nombreuses tâches différentes du monde réel, afin que les utilisateurs humains et les agents d'IA puissent accumuler les informations qu'ils ont acquises sur les processus et les capacités de chacun lors de leur collaboration sur différentes tâches.

"Dans nos prochaines études, nous cherchons également à appliquer notre cadre à davantage de tâches et de robots physiques", a déclaré le Dr Gao. "En plus des valeurs, nous pensons que l'alignement d'autres aspects des modèles mentaux (par exemple, les croyances, les désirs, les intentions) entre les humains et les robots serait également une direction prometteuse."

Les chercheurs espèrent que leur nouveau paradigme d'IA explicable contribuera à améliorer la collaboration entre les humains et les machines sur de nombreuses tâches. En outre, ils espèrent que leur approche renforcera la confiance des humains dans les systèmes basés sur l'IA, y compris les assistants intelligents, les robots, les bots et autres agents virtuels.

"Par exemple, vous pouvez corriger Alexa ou Google Home lorsqu'il fait une erreur, mais il fera la même erreur la prochaine fois que vous l'utiliserez", a ajouté le professeur Zhu. "Lorsque votre Roomba va quelque part où vous ne voulez pas qu'il aille et essaie de le combattre, il ne comprend pas car il ne fait que suivre la logique prédéfinie de l'IA. Tout cela interdit à l'IA moderne d'entrer dans nos maisons. Comme le premier étape, notre travail présente le potentiel de résolution de ces problèmes, un pas de plus vers la réalisation de ce que la DARPA a appelé "l'adaptation contextuelle" dans la troisième vague d'IA."

© 2022 Réseau Science X Permettre aux robots sociaux d'apprendre les relations entre les routines des utilisateurs et leur humeur