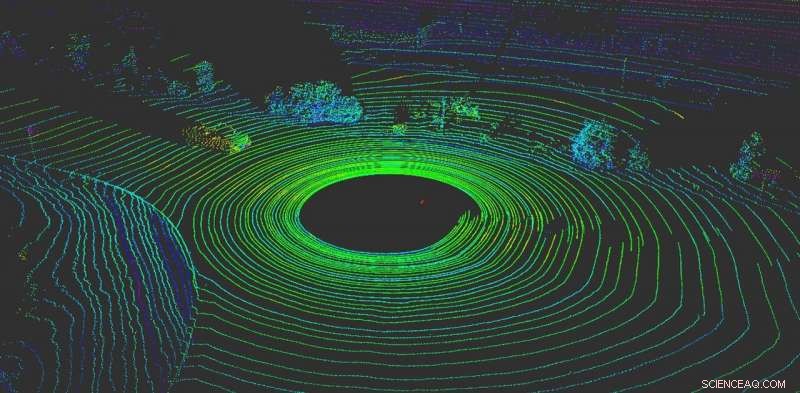

LiDAR aide un véhicule autonome à « visualiser » ce qui l'entoure. Crédit :Yulong Can avec les données de Baidu Apollo, CC BY-ND

Rien n'est plus important pour un véhicule autonome que de sentir ce qui se passe autour de lui. Comme les conducteurs humains, les véhicules autonomes doivent pouvoir prendre des décisions instantanées.

Aujourd'hui, la plupart des véhicules autonomes s'appuient sur plusieurs capteurs pour percevoir le monde. La plupart des systèmes utilisent une combinaison de caméras, capteurs radar et capteurs LiDAR (détection et télémétrie par la lumière). À bord, les ordinateurs fusionnent ces données pour créer une vue complète de ce qui se passe autour de la voiture. Sans ces données, les véhicules autonomes n'auraient aucun espoir de naviguer en toute sécurité dans le monde. Les voitures qui utilisent plusieurs systèmes de capteurs fonctionnent mieux et sont plus sûres - chaque système peut servir de contrôle sur les autres - mais aucun système n'est à l'abri des attaques.

Malheureusement, ces systèmes ne sont pas infaillibles. Les systèmes de perception basés sur des caméras peuvent être trompés simplement en apposant des autocollants sur les panneaux de signalisation pour changer complètement leur sens.

Notre travail, du groupe de recherche RobustNet de l'Université du Michigan, a montré que le système de perception basé sur LiDAR peut être compris, trop. En usurpant stratégiquement les signaux des capteurs LiDAR, l'attaque est capable de tromper le système de perception basé sur LiDAR du véhicule en lui faisant « voir » un obstacle inexistant. Si ça arrive, un véhicule pourrait provoquer un accident en bloquant la circulation ou en freinant brusquement.

Usurpation de signaux LiDAR

Les systèmes de perception basés sur LiDAR ont deux composants :le capteur et le modèle d'apprentissage automatique qui traite les données du capteur. Un capteur LiDAR calcule la distance entre lui-même et son environnement en émettant un signal lumineux et en mesurant le temps qu'il faut pour que ce signal rebondisse sur un objet et retourne au capteur. Cette durée de ce va-et-vient est aussi appelée « temps de vol ».

Une unité LiDAR envoie des dizaines de milliers de signaux lumineux par seconde. Ensuite, son modèle d'apprentissage automatique utilise les impulsions renvoyées pour brosser un tableau du monde autour du véhicule. C'est similaire à la façon dont une chauve-souris utilise l'écholocation pour savoir où se trouvent les obstacles la nuit.

Le problème est que ces impulsions peuvent être falsifiées. Pour tromper le capteur, un attaquant peut envoyer son propre signal lumineux au capteur. C'est tout ce dont vous avez besoin pour mélanger le capteur.

Cependant, il est plus difficile d'usurper le capteur LiDAR pour "voir" un "véhicule" qui n'est pas là. Réussir, l'attaquant doit chronométrer avec précision les signaux tirés sur le LiDAR victime. Cela doit se produire au niveau de la nanoseconde, puisque les signaux voyagent à la vitesse de la lumière. De petites différences apparaîtront lorsque le LiDAR calcule la distance en utilisant le temps de vol mesuré.

Si un attaquant réussit à tromper le capteur LiDAR, il doit ensuite tromper le modèle d'apprentissage automatique. Les travaux effectués dans le laboratoire de recherche OpenAI montrent que les modèles d'apprentissage automatique sont vulnérables à des signaux ou à des entrées spécialement conçus, ce que l'on appelle des exemples contradictoires. Par exemple, des autocollants spécialement créés sur les panneaux de signalisation peuvent tromper la perception basée sur la caméra.

Nous avons découvert qu'un attaquant pouvait utiliser une technique similaire pour créer des perturbations qui fonctionnent contre LiDAR. Ils ne seraient pas un autocollant visible, mais des signaux falsifiés spécialement créés pour tromper le modèle d'apprentissage automatique en lui faisant croire qu'il existe des obstacles alors qu'en fait il n'y en a pas. Le capteur LiDAR fournira les faux signaux du pirate au modèle d'apprentissage automatique, qui les reconnaîtra comme un obstacle.

L'exemple contradictoire, le faux objet, pourrait être conçu pour répondre aux attentes du modèle d'apprentissage automatique. Par exemple, l'attaquant pourrait créer le signal d'un camion qui ne bouge pas. Puis, mener l'attaque, ils pourraient l'installer à une intersection ou le placer sur un véhicule qui est conduit devant un véhicule autonome.

Deux attaques possibles

Pour démontrer l'attaque conçue, nous avons choisi un système de conduite autonome utilisé par de nombreux constructeurs automobiles :Baidu Apollo. Ce produit compte plus de 100 partenaires et a conclu un accord de production de masse avec plusieurs fabricants, dont Volvo et Ford.

En utilisant les données de capteurs du monde réel collectées par l'équipe Baidu Apollo, nous avons démontré deux attaques différentes. En premier, une "attaque de freinage d'urgence, " nous avons montré comment un attaquant peut soudainement arrêter un véhicule en mouvement en le faisant croire qu'un obstacle est apparu sur son chemin. Dans le second, une "attaque de gel AV, " nous avons utilisé un obstacle falsifié pour tromper un véhicule qui avait été arrêté à un feu rouge pour qu'il reste arrêté après que le feu soit passé au vert.

En exploitant les vulnérabilités des systèmes de perception de la conduite autonome, nous espérons déclencher une alarme pour les équipes qui construisent des technologies autonomes. La recherche de nouveaux types de problèmes de sécurité dans les systèmes de conduite autonome ne fait que commencer, et nous espérons découvrir plus de problèmes possibles avant qu'ils ne puissent être exploités sur la route par de mauvais acteurs.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.