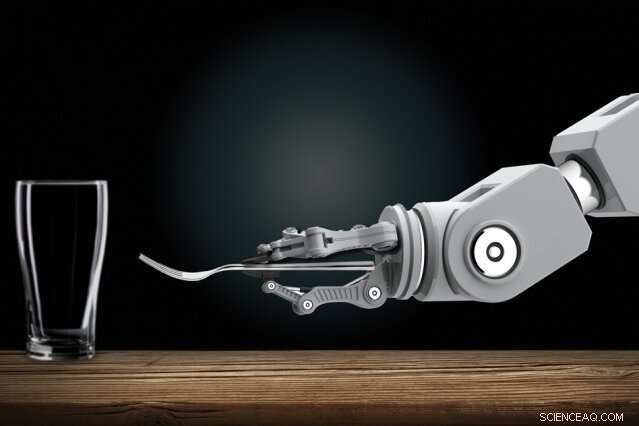

Les roboticiens développent des robots automatisés qui peuvent apprendre de nouvelles tâches uniquement en observant les humains. À la maison, vous pourriez un jour montrer à un robot domestique comment effectuer des tâches de routine. Crédit :Christine Daniloff, MIT

Former des robots interactifs peut être un jour un travail facile pour tout le monde, même ceux qui n'ont pas d'expertise en programmation. Les roboticiens développent des robots automatisés qui peuvent apprendre de nouvelles tâches uniquement en observant les humains. À la maison, vous pourriez un jour montrer à un robot domestique comment effectuer des tâches de routine. Sur le lieu de travail, vous pourriez former des robots comme de nouveaux employés, leur montrer comment accomplir de nombreuses tâches.

Faire des progrès sur cette vision, Les chercheurs du MIT ont conçu un système qui permet à ces types de robots d'apprendre des tâches compliquées qui, autrement, les entraveraient avec trop de règles déroutantes. L'une de ces tâches consiste à dresser une table dans certaines conditions.

En son coeur, le système « Planning with Uncertain Specifications » (PUnS) des chercheurs donne aux robots la capacité de planification à la manière d'un humain pour peser simultanément de nombreuses exigences ambiguës – et potentiellement contradictoires – pour atteindre un objectif final. Ce faisant, le système choisit toujours l'action la plus probable à entreprendre, sur la base d'une "croyance" à propos de certaines spécifications probables pour la tâche qu'il est censé accomplir.

Dans leur travail, les chercheurs ont compilé un ensemble de données avec des informations sur la façon dont huit objets - une tasse, un verre, cuillère, fourchette, couteau, assiette de diner, petite assiette, et bol-pourrait être placé sur une table dans diverses configurations. Un bras robotique a d'abord observé des démonstrations humaines choisies au hasard pour mettre la table avec les objets. Puis, les chercheurs ont chargé le bras de mettre automatiquement une table dans une configuration spécifique, dans des expériences réelles et en simulation, sur la base de ce qu'il avait vu.

Réussir, le robot devait peser de nombreux ordres de placement possibles, même lorsque des éléments ont été volontairement supprimés, empilé, ou caché. Normalement, tout cela embrouillerait trop les robots. Mais le robot des chercheurs n'a commis aucune erreur au cours de plusieurs expériences dans le monde réel, et seulement une poignée d'erreurs sur des dizaines de milliers de tests simulés.

"La vision est de mettre la programmation entre les mains d'experts du domaine, qui peut programmer des robots de manière intuitive, plutôt que de décrire les commandes à un ingénieur pour qu'il les ajoute à son code, " dit le premier auteur Ankit Shah, un étudiant diplômé du Département d'aéronautique et d'astronautique (AeroAstro) et du Groupe de robotique interactive, qui souligne que leur travail n'est qu'une étape dans la réalisation de cette vision. "De cette façon, les robots n'auront plus à effectuer de tâches préprogrammées. Les ouvriers d'usine peuvent apprendre à un robot à effectuer plusieurs tâches d'assemblage complexes. Les robots domestiques peuvent apprendre à empiler des armoires, charger le lave-vaisselle, ou mettre la table des gens à la maison."

Shen Li, étudiant diplômé d'AeroAstro et d'Interactive Robotics Group, et Julie Shah, chef de l'Interactive Robotics Group, se joignent à Shah. professeur agrégé à AeroAstro et au Laboratoire d'informatique et d'intelligence artificielle.

Les paris de couverture des bots

Les robots sont de bons planificateurs dans les tâches avec des "spécifications claires, " qui aident à décrire la tâche que le robot doit accomplir, compte tenu de ses actions, environnement, et objectif final. Apprendre à dresser une table en observant des démonstrations, est plein de spécifications incertaines. Les articles doivent être placés à certains endroits, selon le menu et la place des convives, et dans certaines commandes, en fonction de la disponibilité immédiate d'un article ou des conventions sociales. Les approches actuelles de la planification ne sont pas capables de faire face à des spécifications aussi incertaines.

Une approche populaire de la planification est « l'apprentissage par renforcement, " une technique d'apprentissage automatique par essais et erreurs qui les récompense et les pénalise pour les actions qu'ils accomplissent pour accomplir une tâche. Mais pour les tâches aux spécifications incertaines, il est difficile de définir des récompenses et des pénalités claires. En bref, les robots n'apprennent jamais complètement le bien du mal.

Le système des chercheurs, appelé PUnS (pour Planning with Uncertain Specifications), permet à un robot d'avoir une "croyance" sur une gamme de spécifications possibles. La croyance elle-même peut ensuite être utilisée pour distribuer des récompenses et des pénalités. "Le robot couvre essentiellement ses paris en termes de ce qui est prévu dans une tâche, et prend des mesures qui satisfont sa croyance, au lieu de nous lui donner une spécification claire, " dit Ankit Shah.

Le système est construit sur une "logique temporelle linéaire" (LTL), un langage expressif qui permet un raisonnement robotique sur les résultats actuels et futurs. Les chercheurs ont défini des modèles en LTL qui modélisent diverses conditions temporelles, comme ce qui doit arriver maintenant, doit finir par arriver, et doit arriver jusqu'à ce que quelque chose d'autre se produise. Les observations du robot sur 30 démonstrations humaines pour mettre la table ont donné une distribution de probabilité sur 25 formules LTL différentes. Chaque formule encodait une préférence ou une spécification légèrement différente pour dresser la table. Cette distribution de probabilité devient sa croyance.

"Chaque formule code quelque chose de différent, mais lorsque le robot considère diverses combinaisons de tous les modèles, et essaie de tout satisfaire ensemble, il finit par faire la bonne chose finalement, " dit Ankit Shah.

Critères suivants

Les chercheurs ont également développé plusieurs critères qui guident le robot vers la satisfaction de l'entière conviction de ces formules candidates. Une, par exemple, satisfait la formule la plus probable, qui rejette tout le reste à l'exception du modèle avec la probabilité la plus élevée. D'autres satisfont le plus grand nombre de formules uniques, sans tenir compte de leur probabilité globale, ou ils satisfont à plusieurs formules qui représentent la probabilité totale la plus élevée. Un autre minimise simplement l'erreur, le système ignore donc les formules à forte probabilité d'échec.

Les concepteurs peuvent choisir l'un des quatre critères à prédéfinir avant la formation et les tests. Chacun a son propre compromis entre flexibilité et aversion au risque. Le choix des critères dépend entièrement de la tâche. Dans les situations critiques de sécurité, par exemple, a designer may choose to limit possibility of failure. But where consequences of failure are not as severe, designers can choose to give robots greater flexibility to try different approaches.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, par exemple, the robot would finish setting the rest of the table without the item. Puis, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Prochain, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.