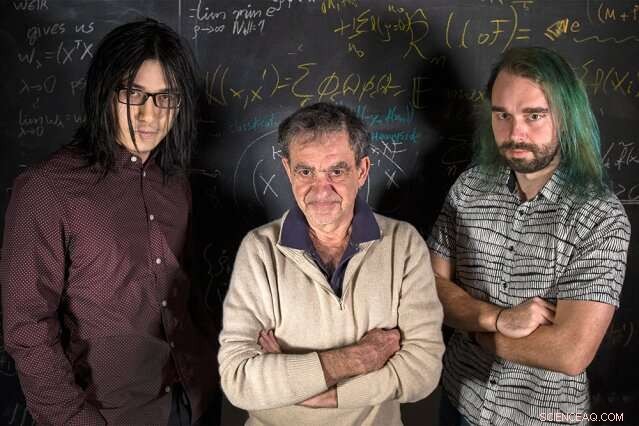

Chercheurs du MIT (de gauche à droite) Qianli Liao, Tomaso Poggio, et Andrzej Banburski se tiennent debout avec leurs équations. Crédit :Kris Brewer

Les cours d'introduction aux statistiques nous enseignent que, lors de l'ajustement d'un modèle à certaines données, nous devrions avoir plus de données que de paramètres libres pour éviter le risque de sur-ajustement - ajustement trop précis des données bruitées, et ainsi ne pas ajuster les nouvelles données. C'est surprenant, alors, que dans l'apprentissage profond moderne, la pratique consiste à avoir des ordres de grandeur plus de paramètres que de données. Malgré cela, les réseaux profonds montrent de bonnes performances prédictives, et en fait, mieux ils ont de paramètres. Pourquoi serait-ce?

On sait depuis un certain temps que de bonnes performances en machine learning proviennent de la maîtrise de la complexité des réseaux, qui n'est pas qu'une simple fonction du nombre de paramètres libres. La complexité d'un classificateur, comme un réseau de neurones, dépend de la mesure de la "taille" de l'espace de fonctions que représente ce réseau, avec plusieurs mesures techniques suggérées précédemment :dimension Vapnik-Chervonenkis, couvrant les nombres, ou complexité Rademacher, pour n'en nommer que quelques-uns. Complexité, mesurée par ces notions, peut être contrôlé au cours du processus d'apprentissage en imposant une contrainte sur la norme des paramètres - en bref, sur la "grande" qu'ils peuvent obtenir. Le fait surprenant est qu'une telle contrainte explicite ne semble pas être nécessaire dans la formation de réseaux profonds. Le deep learning se situe-t-il en dehors de la théorie classique de l'apprentissage ? Faut-il repenser les fondations ?

Dans un nouvel article de Nature Communications, "Contrôle de la complexité par descente de gradient dans les réseaux profonds, " une équipe du Center for Brains, Esprits, et Machines dirigé par le réalisateur Tomaso Poggio, le professeur Eugene McDermott au département des sciences du cerveau et des sciences cognitives du MIT, a fait la lumière sur cette énigme en abordant les applications les plus pratiques et les plus réussies de l'apprentissage profond moderne :les problèmes de classification.

"Pour les problèmes de classement, on observe qu'en fait les paramètres du modèle ne semblent pas converger, mais plutôt grossir indéfiniment pendant la descente du gradient. Cependant, dans les problèmes de classification, seuls les paramètres normalisés comptent, c'est-à-dire la direction qu'ils définissent, pas leur taille, " dit le co-auteur et candidat au doctorat du MIT Qianli Liao. " La chose pas si évidente que nous avons montrée est que la descente de gradient couramment utilisée sur les paramètres non normalisés induit le contrôle de complexité souhaité sur les paramètres normalisés. "

« On sait depuis un certain temps dans le cas de la régression pour les réseaux linéaires peu profonds, telles que les machines à noyau, que les itérations de la descente de gradient fournissent implicitement, disparition de l'effet de régularisation, " dit Poggio. " En fait, dans ce cas simple, nous savons probablement que nous obtenons la marge maximale qui se comporte le mieux, solution de norme minimale. La question que nous nous posions, alors, était :quelque chose de similaire peut-il se produire pour les réseaux profonds ?"

Les chercheurs ont découvert que oui. Comme l'explique le co-auteur et postdoctorant du MIT Andrzej Banburski, « Comprendre la convergence dans les réseaux profonds montre qu'il existe des orientations claires pour améliorer nos algorithmes. En fait, nous avons déjà vu des indices selon lesquels le contrôle de la vitesse à laquelle ces paramètres non normalisés divergent nous permet de trouver des solutions plus performantes et de les trouver plus rapidement."

Qu'est-ce que cela signifie pour l'apprentissage automatique ? Il n'y a pas de magie derrière les réseaux profonds. La même théorie derrière tous les modèles linéaires est également en jeu ici. Ce travail propose des pistes pour améliorer les réseaux profonds, les rendant plus précis et plus rapides à entraîner.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.