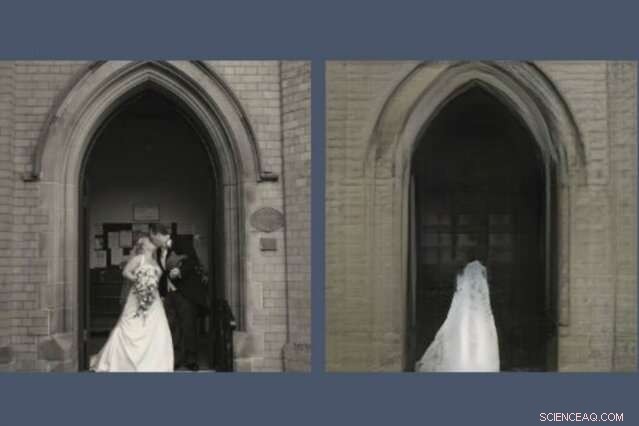

Un nouvel outil révèle ce que les modèles d'IA laissent de côté pour recréer une scène. Ici, un GAN, ou réseau accusatoire génératif, a supprimé le couple de jeunes mariés de sa reconstitution (à droite) de la photo qu'on lui avait demandé de dessiner (à gauche). Crédit :Massachusetts Institute of Technology

Quiconque a passé du temps sur les réseaux sociaux a probablement remarqué que les GAN, ou des réseaux accusatoires génératifs, sont devenus remarquablement doués pour dessiner des visages. Ils peuvent prédire à quoi vous ressemblerez quand vous serez vieux et à quoi vous ressembleriez en tant que célébrité. Mais demandez à un GAN de dessiner des scènes du monde plus vaste et les choses deviennent étranges.

Une nouvelle démo du MIT-IBM Watson AI Lab révèle ce qu'un modèle formé sur des scènes d'églises et de monuments décide de laisser de côté lorsqu'il dessine sa propre version de, dire, le Panthéon à Paris, ou la Piazza di Spagna à Rome. L'étude plus large, Voir ce qu'un GAN ne peut pas générer, a été présenté à la Conférence internationale sur la vision par ordinateur la semaine dernière.

« Les chercheurs se concentrent généralement sur la caractérisation et l'amélioration de ce qu'un système d'apprentissage automatique peut faire :ce à quoi il prête attention, et comment des entrées particulières conduisent à des sorties particulières, " dit David Bau, un étudiant diplômé du département de génie électrique et d'informatique du MIT et du laboratoire d'informatique et de sciences artificielles (CSAIL). "Avec ce travail, nous espérons que les chercheurs accorderont autant d'attention à la caractérisation des données que ces systèmes ignorent."

Dans un GAN, une paire de réseaux de neurones travaillent ensemble pour créer des images hyperréalistes inspirées d'exemples qui leur ont été donnés. Bau s'est intéressé aux GAN comme moyen de scruter l'intérieur des réseaux neuronaux de la boîte noire pour comprendre le raisonnement derrière leurs décisions. Un outil antérieur développé avec son conseiller, Professeur du MIT Antonio Torralba, et le chercheur d'IBM Hendrik Strobelt, a permis d'identifier les clusters de neurones artificiels chargés d'organiser l'image en catégories du monde réel comme les portes, des arbres, et les nuages. Un outil connexe, GANPeinture, permet aux artistes amateurs d'ajouter et de supprimer ces fonctionnalités de leurs propres photos.

Un jour, tout en aidant un artiste à utiliser GANPaint, Bau a rencontré un problème. "Comme d'habitude, nous courions après les chiffres, essayer d'optimiser la perte de reconstruction numérique pour reconstruire la photo, " dit-il. " Mais mon conseiller nous a toujours encouragés à regarder au-delà des chiffres et à scruter les images réelles. Quand nous avons regardé, le phénomène a sauté aux yeux :les gens étaient abandonnés de manière sélective. »

Tout comme les GAN et autres réseaux de neurones trouvent des modèles dans des tas de données, ils ignorent les modèles, trop. Bau et ses collègues ont formé différents types de GAN sur des scènes intérieures et extérieures. Mais peu importe où les photos ont été prises, les GAN ont systématiquement omis des détails importants comme les personnes, voitures, panneaux, fontaines, et des meubles, même lorsque ces objets apparaissaient en évidence dans l'image. Dans une reconstruction GAN, une paire de jeunes mariés s'embrassant sur les marches d'une église sont fantômes, laissant une étrange texture de robe de mariée sur la porte de la cathédrale.

"Lorsque les GAN rencontrent des objets qu'ils ne peuvent pas générer, ils semblent imaginer à quoi ressemblerait la scène sans eux, " dit Strobelt. " Parfois, les gens deviennent des buissons ou disparaissent entièrement dans le bâtiment derrière eux. "

Les chercheurs soupçonnent que la paresse des machines pourrait être à blâmer; bien qu'un GAN soit formé pour créer des images convaincantes, il peut apprendre qu'il est plus facile de se concentrer sur les bâtiments et les paysages et d'ignorer les personnes et les voitures plus difficiles à représenter. Les chercheurs savent depuis longtemps que les GAN ont tendance à négliger certains détails statistiquement significatifs. Mais c'est peut-être la première étude à montrer que les GAN de pointe peuvent systématiquement omettre des classes entières d'objets dans une image.

Une IA qui supprime certains objets de ses représentations peut atteindre ses objectifs numériques tout en manquant les détails les plus importants pour nous, les humains, dit Bau. Alors que les ingénieurs se tournent vers les GAN pour générer des images synthétiques afin de former des systèmes automatisés tels que des voitures autonomes, il y a un danger que les gens, panneaux, et d'autres informations critiques pourraient être supprimées sans que les humains s'en rendent compte. Cela montre pourquoi les performances du modèle ne doivent pas être mesurées uniquement par la précision, dit Bau. "Nous devons comprendre ce que les réseaux font et ne font pas pour nous assurer qu'ils font les choix que nous voulons qu'ils fassent."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.