Crédit :Egor Zakharov et al.

Un article discutant d'un exploit d'intelligence artificielle maintenant sur arXiv donne aux observateurs technologiques une autre raison de penser que c'est l'ère de l'effroi.

"Apprentissage contradictoire à quelques coups de modèles réalistes de têtes parlantes neuronales" par Egor Zakharov, Aliaksandra Shysheya, Egor Burkov et Victor Lempitsky révèlent leur technique qui peut transformer des photos et des peintures en têtes parlantes animées. Les affiliations des auteurs incluent le Samsung AI Center, Moscou et l'Institut des sciences et technologies de Skolkovo.

L'acteur clé dans tout ça ? Samsung. Il a ouvert des centres de recherche à Moscou, Cambridge et Toronto l'année dernière et le résultat final pourrait bien faire plus de gros titres dans l'histoire de l'IA.

Oui, la Joconde peut avoir l'air de dire à son animatrice de télévision pourquoi elle préfère les revitalisants sans rinçage. Albert Einstein peut avoir l'air de parler en faveur de l'absence de produits capillaires du tout.

Ils ont écrit que « nous considérons le problème de la synthèse d'images de tête personnalisées photoréalistes à partir d'un ensemble de repères de visage, qui pilotent l'animation du modèle." One shot apprenant à partir d'une seule image, même, est possible.

Khari Johnson, VentureBeat , ont noté qu'ils peuvent générer des têtes parlantes animées réalistes à partir d'images sans pour autant s'appuyant sur des méthodes traditionnelles telles que la modélisation 3D.

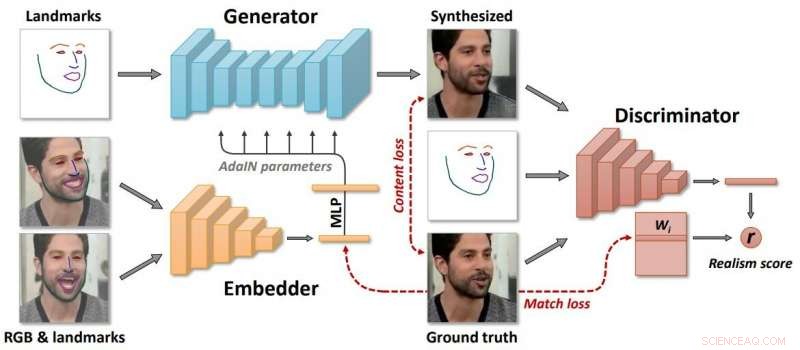

Les auteurs ont souligné que « essentiellement, le système est capable d'initialiser les paramètres du générateur et du discriminateur d'une manière spécifique à la personne, pour que la formation puisse se baser sur quelques images et se faire rapidement, malgré la nécessité de régler des dizaines de millions de paramètres."

Quelle est leur approche ? Ivan Mehta dans Le prochain Web a guidé les lecteurs à travers les étapes qui forment leur technique.

"Samsung a déclaré que le modèle crée trois réseaux de neurones au cours du processus d'apprentissage. Premièrement, il crée un réseau intégré qui relie les cadres liés aux points de repère du visage avec des vecteurs. Ensuite, en utilisant ces données, le système crée un réseau de générateurs qui mappe les points de repère dans les vidéos synthétisées. Finalement, le réseau discriminateur évalue le réalisme et la pose des trames générées."

Les auteurs ont décrit un « long méta-apprentissage » sur un grand ensemble de données de vidéos, et capable d'encadrer l'apprentissage en un seul coup de modèles de têtes neuronales parlantes de personnes jamais vues auparavant comme des problèmes d'entraînement contradictoires, avec des générateurs et discriminateurs de grande capacité.

Qui utiliserait réellement ce système ? Les rapports mentionnaient la téléprésence, les jeux multijoueurs et l'industrie des effets spéciaux.

Néanmoins, Johnson et d'autres personnes déposant leurs rapports n'étaient pas sur le point d'ignorer le risque d'avancées technologiques entre de mauvaises mains, où les espiègles peuvent produire du faux avec de mauvaises intentions.

"Cette technologie pourrait clairement aussi être utilisée pour créer des deepfakes, ", a écrit Johnson.

Donc, nous pourrions vouloir faire une pause sur cette pensée. Juste que les écrivains se réfèrent maintenant avec tant de désinvolture aux résultats "deep fake" qui sortent de certains projets d'intelligence artificielle. Et les écrivains se demandent ce que cette avancée technologique de Samsung pourrait signifier dans les deepfakes.

Jon Christian a eu une vue d'ensemble dans Futurisme . "Au cours des dernières années, nous avons vu l'essor rapide de la technologie « deepfake » qui utilise l'apprentissage automatique pour analyser des images de vraies personnes, puis produire des vidéos convaincantes d'elles faisant des choses qu'elles n'ont jamais faites ou disant des choses qu'elles n'ont jamais dites. »

Joan Solsman dans CNET : « Les progrès rapides de l'intelligence artificielle signifient que chaque fois qu'un chercheur partage une percée dans la création de deepfake, les mauvais acteurs peuvent commencer à rassembler leurs propres outils truqués par un jury pour l'imiter."

De façon intéressante, plus le public est conscient de la falsification de l'IA, plus ils accepteront facilement que certaines animations soient fausses, ou pas ? Un commentaire de spectateur sur la page vidéo :"À l'avenir, le chantage est impossible parce que tout le monde sait que vous pouvez facilement créer une vidéo à partir de n'importe quoi."

© 2019 Réseau Science X