Cynthia Rudin. Crédit :Université Duke

Alors que les mots à la mode « apprentissage automatique » continuent de gagner en popularité, de plus en plus d'industries se tournent vers les algorithmes informatiques pour répondre à des questions importantes, notamment des domaines à forts enjeux comme la santé, finances et justice pénale. Bien que cette tendance puisse conduire à des améliorations majeures dans ces domaines, cela peut également conduire à des problèmes majeurs lorsque l'algorithme d'apprentissage automatique est ce qu'on appelle une "boîte noire".

Une boîte noire est un programme d'apprentissage automatique qui n'explique pas comment il parvient à ses conclusions, soit parce qu'il est trop compliqué à comprendre pour un humain, soit parce que son fonctionnement interne est exclusif. En réponse aux préoccupations selon lesquelles ces types de modèles peuvent inclure des mécanismes internes injustes, tels que le racisme, une autre tendance croissante consiste à créer des modèles supplémentaires pour « expliquer » ces boîtes noires.

Dans un nouvel éditorial publié dans Nature Machine Intelligence , Cynthia Rudin, professeur agrégé d'informatique, génie électrique et informatique, mathématiques, et les sciences statistiques à l'Université Duke, soutient que les modèles de boîte noire doivent être abandonnés pour les décisions à enjeux élevés. Même lorsque des soi-disant modèles d'explication sont créés, elle dit, les décideurs devraient opter pour des modèles interprétables, qui sont complètement transparents et facilement compréhensibles par ses utilisateurs.

Les modèles explicables sont faux

Les modèles d'apprentissage automatique « explicables » sont construits pour tenter de comprendre ce qui se passe à l'intérieur d'une boîte noire. S'il peut produire les mêmes résultats, les gens supposent que c'est une représentation exacte.

Mais ce n'est pas.

Les algorithmes explicables fournissent des explications qui sont inexactes par définition, sinon le fonctionnement interne complexe de la boîte noire serait inutile. Alors qu'un modèle d'explication peut produire des résultats similaires ou même exacts à l'algorithme original de la boîte noire, il n'y a aucun moyen de savoir s'il utilise les mêmes paramètres ou non.

« Si un dixième des explications sont fausses, tu ne peux pas te fier aux explications, et donc vous ne pouvez pas faire confiance à la boîte noire d'origine, " dit Rudin. " Si nous ne pouvons pas savoir avec certitude si notre explication est correcte, nous ne pouvons pas savoir s'il faut faire confiance à l'explication ou au modèle original."

Plus n'est pas égal à mieux

Les gens supposent généralement que, simplement parce qu'un algorithme d'apprentissage automatique est compliqué, qu'il est plus précis qu'un simple. Mais cette croyance n'est pas fondée.

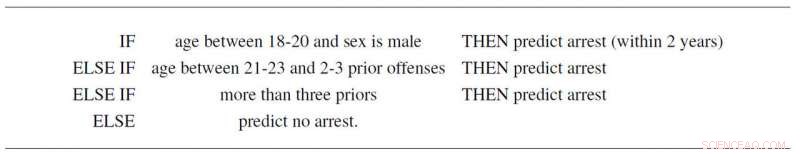

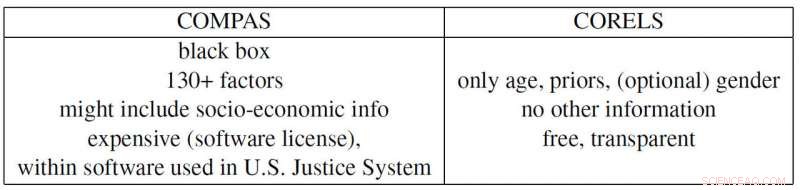

Par exemple, Rudin et ses collaborateurs Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone et Daniel Alabi ont créé un modèle interprétable simple pour la récidive criminelle basé uniquement sur l'âge, sexe et antécédents. Non seulement il suit trois règles simples que tout le monde peut comprendre, il prédit la probabilité de futures arrestations ainsi que le programme controversé "COMPAS", qui est largement utilisé dans le système de justice américain. Et en plus d'être une boîte noire que beaucoup soupçonnent d'employer des préjugés racistes, COMPAS utilise plus de 130 informations pour faire ses prédictions, qui est en soi un problème majeur.

"Si les personnes qui saisissent ces données font une erreur typographique seulement un pour cent du temps, alors plus d'un sondage sur deux en moyenne aura au moins une erreur, " dit Rudin. " De plus, un modèle de boîte noire trop compliqué peut être défectueux sans que personne ne s'en rende compte, car c'est difficile à dépanner."

L'exemple de Propublica

ProPublica a récemment accusé l'algorithme de la boîte noire de récidive de COMPAS d'être biaisé sur le plan racial, car ils ont créé un modèle explicable basé sur la race qui reproduit les résultats de COMPAS. Mais parce que les pressions sociétales ont créé un système de justice pénale où les antécédents criminels et l'âge sont corrélés à la race dans chaque ensemble de données, la boîte noire COMPAS réelle pourrait en fait ne s'appuyer que sur les deux premières variables. Mais encore une fois, il pourrait également utiliser la race comme facteur, tout comme le prétend ProPublica. Le problème est que c'est impossible à dire car COMPAS est une boîte noire propriétaire (coûteuse) que personne d'autre que ses propriétaires ne peut consulter.

Rudin signale également plusieurs autres exemples problématiques contemporains. La boîte noire brevetée BreezoMeter a déclaré aux utilisateurs californiens que la qualité de l'air était parfaitement bonne alors que la qualité de l'air était dangereusement mauvaise selon plusieurs autres modèles. Un modèle d'apprentissage automatique conçu pour lire les rayons X reprenait le mot « portable » dans une image radiographique, représentant le type d'équipement à rayons X plutôt que le contenu médical de l'image, et ainsi rapporter de mauvaises conclusions.

« Il existe un conflit de responsabilité dans l'utilisation de modèles de boîte noire pour des décisions à enjeux élevés. Les entreprises qui profitent de ces modèles ne sont pas nécessairement responsables de la qualité des prédictions individuelles, " dit Rudin. " Un détenu purgeant une peine excessivement longue en raison d'une erreur saisie dans un score de risque trop compliqué pourrait souffrir pendant des années, alors que l'entreprise qui a construit ce modèle profite de sa complexité et de sa justesse. Dans ce sens, les concepteurs du modèle ne sont pas incités à être prudents dans sa conception, performances et facilité d'utilisation. Ce sont quelques-uns des mêmes types de problèmes affectant les agences de notation de crédit qui ont fixé le prix des prêts hypothécaires en 2008. »

"J'espère que les gens réalisent les risques des modèles explicables et qu'ils n'ont en fait pas du tout besoin de boîtes noires. Ils peuvent utiliser des modèles complètement interprétables, " dit Rudin. " J'aimerais voir un système dans lequel aucun algorithme de boîte noire n'est utilisé pour une décision à enjeux élevés, à moins qu'il n'y ait pas de modèle interprétable tout aussi précis. J'ai travaillé sur de nombreuses applications différentes :soins médicaux, énergie, le risque de crédit, récidive criminelle, vision par ordinateur - et je n'ai jamais trouvé d'application où une boîte noire est réellement nécessaire."