Y a-t-il des gens là-bas qui ont besoin d'aide? Crédit :Roschetzky Photography/Shutterstock.com

Lorsque des catastrophes se produisent - qu'il s'agisse d'une catastrophe naturelle comme une inondation ou un tremblement de terre, ou d'origine humaine comme une fusillade ou un bombardement de masse - il peut être extrêmement dangereux d'envoyer des premiers intervenants, même s'il y a des gens qui ont vraiment besoin d'aide.

Les drones sont utiles, et aident à la reprise après les tornades meurtrières de l'Alabama, mais la plupart nécessitent des pilotes individuels, qui pilotent l'avion sans pilote par télécommande. Cela limite la rapidité avec laquelle les sauveteurs peuvent visualiser l'ensemble de la zone touchée, et peut retarder l'acheminement de l'aide réelle aux victimes.

Les drones autonomes pourraient couvrir plus de terrain plus rapidement, mais ne seraient plus efficaces que s'ils pouvaient à eux seuls aider les sauveteurs à identifier les personnes dans le besoin. Au Vision Lab de l'Université de Dayton, nous travaillons sur le développement de systèmes qui peuvent aider à repérer les personnes ou les animaux, en particulier ceux qui pourraient être piégés par des débris tombés. Notre technologie imite le comportement d'un sauveteur humain, en regardant brièvement de vastes zones et en choisissant rapidement des régions spécifiques sur lesquelles se concentrer, à examiner de plus près.

À la recherche d'un objet dans une scène chaotique

Les zones sinistrées sont souvent encombrées d'arbres abattus, bâtiments effondrés, routes abîmées et autres désordres qui peuvent rendre très difficile le repérage des victimes ayant besoin de secours.

Mon équipe de recherche a développé un système de réseau de neurones artificiels qui peut fonctionner dans un ordinateur à bord d'un drone. Ce système peut imiter certaines des excellentes façons dont fonctionne la vision humaine. Il analyse les images capturées par la caméra du drone et communique les découvertes notables aux superviseurs humains.

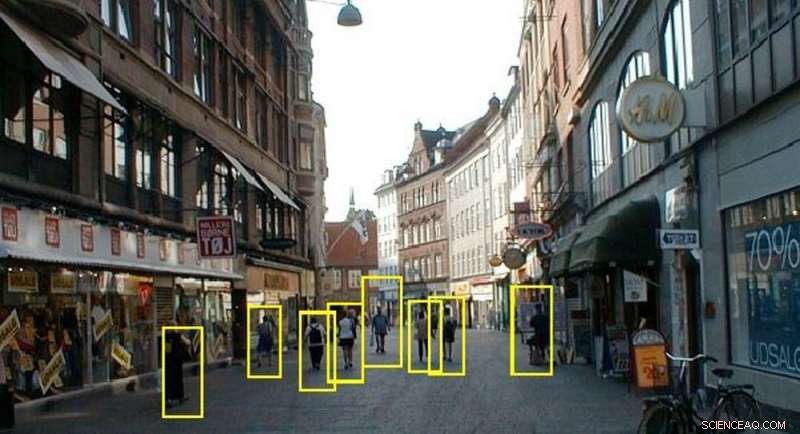

Notre système peut repérer les personnes dans un environnement animé. Crédit : Laboratoire de vision de l'Université de Dayton, CC BY-ND

D'abord, notre système traite les images pour améliorer leur clarté. Tout comme les humains plissent les yeux pour ajuster leur mise au point, nos technologies prennent des estimations détaillées des régions plus sombres d'une scène et éclaircissent les images par calcul. Lorsque les images sont trop floues ou brumeuses, le système reconnaît qu'elles sont trop lumineuses et réduit la blancheur de l'image pour voir la scène réelle plus clairement.

Dans un environnement pluvieux, le cerveau humain utilise une stratégie brillante pour voir clairement. En remarquant les parties d'une scène qui ne changent pas - et celles qui changent, au fur et à mesure que les gouttes de pluie tombent, les gens voient assez bien malgré la pluie. Notre technologie utilise la même stratégie, enquêter en permanence sur le contenu de chaque emplacement dans une séquence d'images pour obtenir des informations claires sur les objets de cet emplacement.

Nous avons également développé une technologie qui peut rendre les images d'une caméra embarquée plus grandes, plus lumineux et plus clair. En agrandissant la taille de l'image, les algorithmes et les personnes peuvent voir les fonctionnalités clés plus clairement.

Confirmation des objets d'intérêt

Notre système peut identifier des personnes à divers postes, comme couché sur le ventre ou recroquevillé en position fœtale, même sous différents angles de vue et dans des conditions d'éclairage variables.

Le cerveau humain peut regarder une vue d'un objet et imaginer à quoi il ressemblerait sous d'autres angles. Lorsque la police émet une alerte demandant au public de rechercher quelqu'un, ils incluent souvent une photo fixe - sachant que l'esprit des spectateurs imaginera des vues en trois dimensions de l'apparence de cette personne, et les reconnaître dans la rue, même s'ils n'obtiennent pas exactement la même vue que la photo proposée. Nous employons cette stratégie en calculant des modèles tridimensionnels de personnes - soit des formes humaines générales, soit des projections plus détaillées de personnes spécifiques. Ces modèles sont utilisés pour faire correspondre les similitudes lorsqu'une personne apparaît dans une scène.

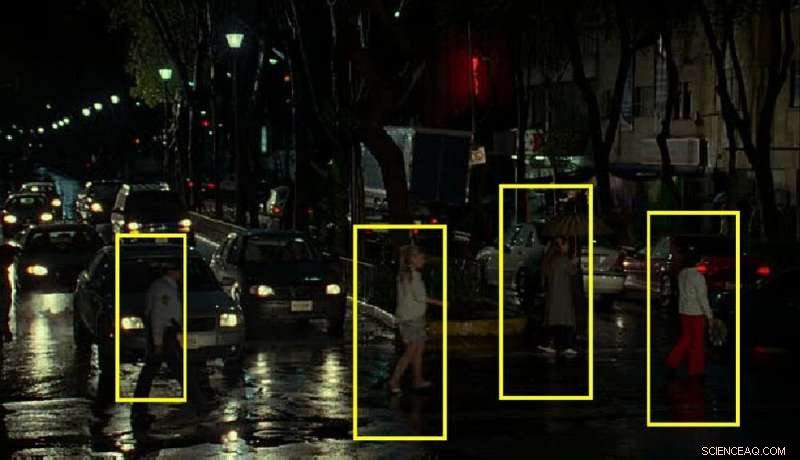

Un éclairage confus et tamisé peut rendre difficile l'identification des personnes. Crédit : Laboratoire de vision de l'Université de Dayton, CC BY-ND

Nous avons également développé un moyen de détecter des parties d'un objet, sans tout voir. Notre système peut être entraîné pour détecter et localiser une jambe qui dépasse sous les décombres, une main agitant à distance, ou une tête surgissant au-dessus d'un tas de blocs de bois. Il peut distinguer une personne ou un animal d'un arbre, buisson ou véhicule.

Assembler les morceaux

Lors de sa première analyse du paysage, notre système imite l'approche d'un observateur aéroporté, examiner le terrain pour trouver d'éventuels objets d'intérêt ou des régions méritant un examen plus approfondi, puis en regardant de plus près. Par exemple, un pilote d'avion qui recherche un camion au sol accorderait généralement moins d'attention aux lacs, étangs, les champs agricoles et les terrains de jeux - parce que les camions sont moins susceptibles de se trouver dans ces zones. Notre technologie autonome utilise la même stratégie pour concentrer la zone de recherche sur les régions les plus importantes de la scène.

Ensuite, notre système étudie chaque région sélectionnée pour obtenir des informations sur la forme, la structure et la texture des objets là-bas. Lorsqu'il détecte un ensemble de caractéristiques qui correspond à un être humain ou à une partie d'un humain, il signale cela comme l'emplacement d'une victime.

Le drone collecte également des données GPS sur sa localisation, et sent à quelle distance il se trouve des autres objets qu'il photographie. Cette information permet au système de calculer exactement l'emplacement de chaque personne ayant besoin d'aide, et alerter les sauveteurs.

Tout ce processus - capturer une image, le traiter pour une visibilité maximale et l'analyser pour identifier les personnes qui pourraient être piégées ou cachées - prend environ un cinquième de seconde sur l'ordinateur portable normal que le drone transporte, avec sa caméra haute résolution.

L'armée américaine s'intéresse à cette technologie. Nous avons travaillé avec le commandement de la recherche médicale et du matériel de l'armée américaine pour trouver des personnes blessées sur un champ de bataille qui ont besoin d'être secourues. Nous avons adapté ce travail pour servir les entreprises de services publics à la recherche d'intrusions sur les chemins des pipelines par des engins de construction ou des véhicules pouvant endommager les pipelines. Les entreprises de services publics sont également intéressées à détecter toute nouvelle construction de bâtiments à proximité des voies du pipeline. Tous ces groupes - et bien d'autres - s'intéressent à la technologie qui peut voir comme les humains peuvent voir, surtout dans des endroits que les humains ne peuvent pas être.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.