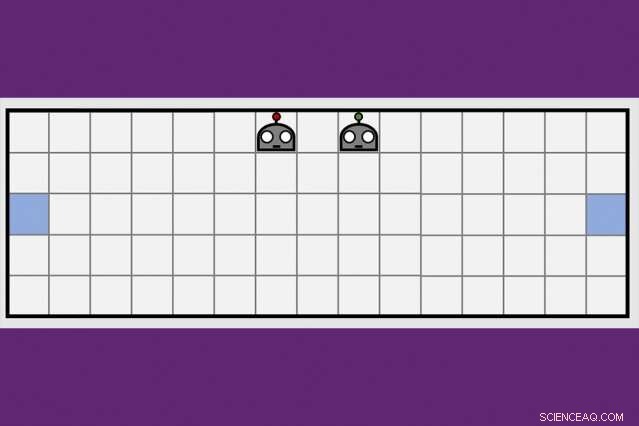

En utilisant une nouvelle technique d'apprentissage coopératif, Les chercheurs du MIT-IBM Watson AI Lab ont réduit de moitié le temps qu'il a fallu à une paire d'agents robots pour apprendre à manœuvrer de part et d'autre d'une pièce virtuelle. Crédit :Dong-ki Kim

Les premiers programmes d'intelligence artificielle pour vaincre les meilleurs joueurs du monde aux échecs et le jeu de Go ont reçu au moins quelques instructions de la part des humains, et ultimement, ne s'avérerait pas à la hauteur d'une nouvelle génération de programmes d'IA qui apprennent entièrement par eux-mêmes, par essais et erreurs.

Une combinaison d'algorithmes d'apprentissage en profondeur et d'apprentissage par renforcement est responsable de la domination des ordinateurs dans les jeux de société difficiles comme les échecs et le Go, un nombre croissant de jeux vidéo, dont Mme Pac-Man, et quelques jeux de cartes, y compris le poker. Mais pour tous les progrès, les ordinateurs restent bloqués plus un jeu ressemble à la vraie vie, avec des informations cachées, plusieurs joueurs, lecture continue, et un mélange de récompenses à court et à long terme qui rendent le calcul du mouvement optimal désespérément complexe.

Pour franchir ces obstacles, Les chercheurs en IA explorent des techniques complémentaires pour aider les agents robots à apprendre, modelé sur la façon dont les humains récupèrent de nouvelles informations non seulement par nous-mêmes, mais des gens autour de nous, et des journaux, livres, et autres médias. Une stratégie d'apprentissage collectif développée par le MIT-IBM Watson AI Lab offre une nouvelle direction prometteuse. Les chercheurs montrent qu'une paire d'agents robots peut réduire de 50 % ou plus le temps nécessaire à l'apprentissage d'une tâche de navigation simple lorsque les agents apprennent à tirer parti des connaissances croissantes de chacun.

L'algorithme enseigne aux agents quand demander de l'aide, et comment adapter leurs conseils à ce qui a été appris jusque-là. L'algorithme est unique en ce qu'aucun des agents n'est un expert; chacun est libre d'agir en tant qu'élève-enseignant pour demander et offrir plus d'informations. Les chercheurs présentent leurs travaux cette semaine à la conférence AAAI sur l'intelligence artificielle à Hawaï.

Co-auteurs de l'article, qui a reçu une mention honorable pour le meilleur article étudiant à l'AAAI, sont Jonathan Comment, professeur au département d'aéronautique et d'astronautique du MIT; Shayegan Omidshafiei, un ancien étudiant diplômé du MIT maintenant chez Alphabet's DeepMind; Dong-ki Kim du MIT; Miao Liu, Gérald Tesauro, Matthieu Riemer, et Murray Campbell d'IBM; et Christopher Amato de l'Université Northeastern.

"Cette idée de proposer des actions pour améliorer au maximum l'apprentissage de l'élève, plutôt que de simplement lui dire quoi faire, est potentiellement assez puissant, " dit Matthew E. Taylor, directeur de recherche chez Borealis AI, la branche recherche de la Banque Royale du Canada, qui n'a pas participé à la recherche. « Alors que le document se concentre sur des scénarios relativement simples, Je pense que le cadre étudiant/enseignant pourrait être étendu et utile dans les jeux vidéo multijoueurs comme Dota 2, football de robots, ou des scénarios de reprise après sinistre."

Pour l'instant, les pros ont toujours l'avantage dans Dota2, et autres jeux virtuels qui favorisent le travail d'équipe et rapide, réflexion stratégique. (Bien que la branche de recherche en IA d'Alphabet, DeepMind, a récemment fait l'actualité après avoir vaincu un joueur professionnel au jeu de stratégie en temps réel, Starcraft.) Mais à mesure que les machines s'améliorent pour manœuvrer des environnements dynamiques, ils pourraient bientôt être prêts pour des tâches réelles comme la gestion du trafic dans une grande ville ou la coordination d'équipes de recherche et de sauvetage au sol et dans les airs.

« Les machines n'ont pas les connaissances de bon sens que nous développons en tant qu'enfants, " dit Liu, un ancien post-doctorant du MIT maintenant au laboratoire MIT-IBM. "C'est pourquoi ils doivent regarder des millions d'images vidéo, et passent beaucoup de temps de calcul, apprendre à bien jouer. Même à ce moment là, ils manquent de moyens efficaces pour transférer leurs connaissances à l'équipe, ou généraliser leurs compétences à un nouveau jeu. Si nous pouvons former des robots à apprendre des autres, et généraliser leur apprentissage à d'autres tâches, nous pouvons commencer à mieux coordonner leurs interactions les uns avec les autres, et avec les humains."

L'idée clé de l'équipe MIT-IBM était qu'une équipe qui se divise et conquiert pour apprendre une nouvelle tâche - dans ce cas, manœuvrer aux extrémités opposées d'une pièce et toucher le mur en même temps, apprendra plus rapidement.

Leur algorithme d'enseignement alterne entre deux phases. En premier, l'étudiant et l'enseignant décident à chaque étape respective s'il faut demander, ou donner, des conseils basés sur leur confiance que le prochain mouvement, ou les conseils qu'ils s'apprêtent à donner, les rapprochera de leur objectif. Ainsi, l'étudiant ne demande que des conseils, et le professeur ne fait que le donner, lorsque les informations ajoutées sont susceptibles d'améliorer leurs performances. À chaque étape, les agents mettent à jour leurs stratégies de tâches respectives et le processus se poursuit jusqu'à ce qu'ils atteignent leur objectif ou manquent de temps.

A chaque itération, l'algorithme enregistre les décisions de l'élève, les conseils du professeur, et leurs progrès d'apprentissage tels que mesurés par le score final du jeu. Dans la deuxième phase, une technique d'apprentissage par renforcement profond utilise les données d'enseignement précédemment enregistrées pour mettre à jour les deux politiques de conseil. "A chaque mise à jour, l'enseignant s'améliore à donner les bons conseils au bon moment, " dit Kim, un étudiant diplômé au MIT.

Dans un document de suivi qui sera discuté lors d'un atelier à l'AAAI, les chercheurs améliorent la capacité de l'algorithme à suivre dans quelle mesure les agents apprennent la tâche sous-jacente - dans ce cas, une tâche de pousser la boîte - pour améliorer la capacité des agents à donner et à recevoir des conseils. C'est une autre étape qui rapproche l'équipe de son objectif à long terme d'entrer dans la RoboCup, un concours annuel de robotique lancé par des chercheurs universitaires en IA.

"Nous aurions besoin de passer à 11 agents avant de pouvoir jouer au football, " dit Tesauro, un chercheur d'IBM qui a développé le premier programme d'IA pour maîtriser le jeu de backgammon. "Cela va demander un peu plus de travail, mais nous avons bon espoir."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.