Crédit :Geralt/Pixabay

Des neurones artificiels pour des machines profondément intelligentes - c'est la nouvelle révolution de l'intelligence artificielle (IA), dirigé par Geoffrey Hinton et son équipe depuis 2012. Cette année-là, Hinton, expert en sciences cognitives à l'Université de Toronto et chercheur à Google Brain, a démontré l'efficacité frappante d'un réseau de neurones profonds (DNN) dans une tâche de catégorisation d'images.

À la suite de ces résultats remarquables, les universités – et les entreprises internationales – ont massivement investi dans le domaine prometteur et fascinant de l'IA. Pourtant, malgré les performances impressionnantes des DNN dans des domaines variés (reconnaissance visuelle et vocale, Traduction, imagerie médicale, etc.), des questions subsistent sur les limites du deep learning pour d'autres usages, comme les véhicules anonymes.

Pour comprendre les limites de l'IA dans son état actuel, nous devons comprendre d'où viennent les DNN et, par dessus tout, sur quelles zones du cerveau humain ils sont modelés - on sait peu de choses à ce sujet en génie industriel, et même dans certains centres de recherche. Depuis l'aube de cette nouvelle révolution, le deep learning est parfois utilisé comme une sorte de "baguette magique", avec peu d'attention à son contexte ou à ses limites. « Pour une intelligence artificielle signifiante », le titre d'un récent rapport du mathématicien français Cédric Villani, témoigne de la profonde ambivalence qui entoure ce sujet.

D'où vient le deep learning ?

Les débuts des réseaux de neurones artificiels remontent aux années 40, avec les découvertes pionnières en neurosciences et en psychologie de Warren McCulloch et Walter H. Pitts (qui ont fourni le premier modèle mathématique d'un neurone) et Donald Hebb (qui a décrit les mécanismes de l'apprentissage synaptique). Ces chercheurs voulaient comprendre comment les neurones, les éléments de base du cerveau, pourrait générer la psyché.

Leurs travaux fondateurs ont conduit à la création du premier réseau neuronal artificiel, le Perceptron, conçu en 1958 par le psychologue américain Frank Rosenblatt. Naturellement, la recherche initiale a été suivie par des développements importants basés, par exemple, sur les études neuroscientifiques d'Alan L. Hodgkin et Andrew F. Huxley décrivant la dynamique temporelle de l'intégration neuronale, et sur les recherches en informatique et mathématiques de Bernard Widrow et Ted Hoff, qui a suggéré l'utilisation d'algorithmes de descente de gradient stochastique comme moyen plus efficace de modifier les connexions synaptiques dans les réseaux de neurones.

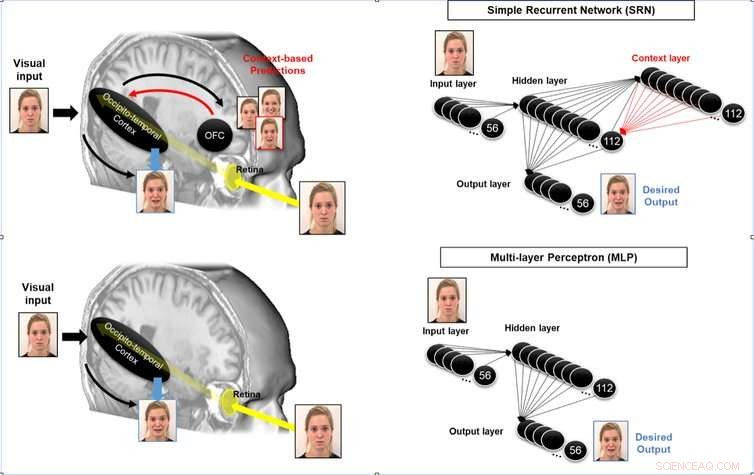

Ces optimisations mathématiques ont été développées plus avant dans les années 1980 avec les recherches en sciences cognitives de David Rumelhart, Geoffrey Hinton et James McClelland, membres du groupe de recherche sur le traitement distribué parallèle. Leurs travaux ont permis d'optimiser la modification des connexions synaptiques dans les couches neuronales profondes et ont conduit à la création du Perceptron multicouche (MLP). DNN, développé par des chercheurs tels que Geoffrey Hinton, Yann LeCun et Yoshua Bengio, sont ses descendants directs.

Existe-t-il un lien entre le deep learning et le cerveau ?

Bien que les DNN aient été développés à l'origine grâce à des travaux interdisciplinaires et inspirés par la fonction cérébrale, on peut se demander dans quelle mesure ces algorithmes constituent encore une simulation du cerveau humain. Ils ont été conçus pour effectuer des tâches telles que la reconnaissance et la catégorisation d'images. Pour ce faire, Les DNN utilisent diverses couches convolutives et de regroupement avant la reconnaissance d'image.

En ce qui concerne les couches convolutives, le travail de David Hubel et Torsten Wiesel dans les années 1960, et Leonie Jones et Derecke Palmer dans les années 1980, démontrer l'utilité de cette méthode pour simuler la réponse probable des neurones dans le cortex visuel primaire. Plusieurs études en sciences cognitives, y compris notre propre travail, utiliser ce processus comme un système neuro-inspiré pour simuler la réponse des neurones perceptifs dans le cortex visuel primaire par exemple.

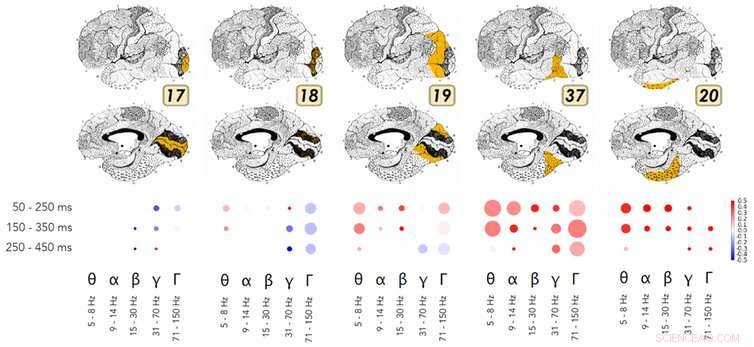

Un exemple de recherche démontrant les similitudes dans le fonctionnement des réseaux de neurones profonds et du flux ventral du cortex visuel. Crédit :Kuzovkin, Vicente, Petton, Lachaux, Baciu, Kahane et Aru, 2018., Auteur fourni

En matière de mutualisation, diverses études dans les domaines des neurosciences et de la psychologie cognitive au cours des trente dernières années ont montré comment le cerveau réalise ce processus d'abstraction dans le flux visuel ventral. Les travaux de Rufin Vogels et Keiji Tanaka montrent comment ce flux permet une identification visuelle et une catégorisation, indépendamment des propriétés de surface d'une image, comme la texture, Couleur, distance, ou la position des objets dans l'image. Ces zones cérébrales sont donc sensibles aux mêmes informations que les couches perceptives apprises par un DNN lors du processus de mise en commun.

Plus surprenant encore, les recherches de Rodrigo Quian Quiroga et de ses collègues démontrent l'existence de neurones spécifiques pour des concepts ou des identités (par exemple, un neurone "Jennifer Aniston", ou un neurone "Tour de Pise"). Ceux-ci se déclenchent en réponse à une exposition directe à un concept, comme voir le nom "Jennifer Aniston" imprimé. Ce qui est plus excitant pour l'avenir de l'IA, c'est que les travaux de M. Quiroga démontrent que cette activité neuronale est corrélée à la conscient perception d'un stimulus dans l'environnement.

Pour résumer, bien qu'ils soient simplifiés et optimisés mathématiquement par rapport à un cerveau biologique, Les DNN reproduisent des processus très similaires en tant que zone très spécifique du cortex (à savoir, cortex occipito-temporal). En utilisant l'IRM ou des électrodes implantées dans le cerveau, des études récentes en neurosciences cognitives démontrent des similitudes dans le fonctionnement des DNN et de ces zones cérébrales spécifiques.

L'IA est-elle plus fiable lorsqu'elle est inspirée par le cerveau ?

La recherche interdisciplinaire fondamentale sur les DNN a produit des résultats tangibles impressionnants dans un large éventail de domaines :reconnaissance visuelle et catégorisation, reconnaissance vocale, Traduction, le jeu de go, composition musicale, pour n'en nommer que quelques uns. Malheureusement, par méconnaissance des sciences cognitives qui les sous-tendent, Les DNN sont encore trop souvent utilisés comme une sorte de baguette magique pour résoudre tous les problèmes.

Il est possible d'améliorer la capacité d'anticipation d'un système neuromorphique en simulant les boucles récurrentes des aires associatives aux aires perceptives à l'œuvre dans le cerveau humain. Crédit :Mermillod, Bourrier, David, Kauffmann, Chauvin, Guyader, Dutheil et Peyrin, 2018., Auteur fourni

Pour prendre l'exemple des voitures sans conducteur, coupler inconsidérément des DNN aux systèmes de contrôle du véhicule serait très risqué :cela équivaudrait à demander à un chauffeur de taxi ayant perdu plus de 80 % de ses fonctions cérébrales dans un accident (ne laissant que le flux visuel ventral) de conduire une voiture. Exiger de ces systèmes qu'ils fassent plus que ce pour quoi ils ont été conçus à l'origine peut entraîner des accidents catastrophiques.

Les zones du cerveau humain impliquées dans l'anticipation (voir ci-dessous), l'orientation spatiale et les fonctions sensori-motrices nécessaires à la conduite dans un environnement complexe sont très différentes des processus neuronaux à l'œuvre au sein du flux visuel ventral. Situé dans le cortex occipito-pariétal, les processus neuronaux impliqués dans la compréhension et la planification sont très différents de ceux qui se déroulent dans le flux visuel ventral ! Ce sont des neurones très différents, sensible à la distance, position et vitesse – autant de paramètres fondamentaux pour déterminer comment nous nous comportons dans l'environnement.

L'utilisation sans discernement des DNN (ou d'autres systèmes artificiels) sans référence ou comparaison à la neuro-inspiration derrière les diverses fonctions cognitives est non seulement inefficace mais carrément dangereuse. Nous ne prétendons pas que la neuro-inspiration est le seul moyen efficace pour une IA plus sûre. Cependant, étant donné le passé tumultueux de l'IA, et en tenant compte de l'efficacité désormais prouvée des systèmes neuro-inspirés comme les DNN par rapport aux méthodes d'ingénierie précédentes (pour la reconnaissance visuelle, par exemple), nous pensons qu'il est essentiel de comprendre comment le cerveau exécute d'autres fonctions cognitives (contrôle moteur, intégration multisensorielle, etc.) afin de comparer cela aux techniques d'ingénierie actuelles pour l'exécution de ces fonctions, et produire un plus sûr, IA plus efficace.

Des recherches en IA menées en collaboration plus étroite avec les sciences cognitives permettraient de :

Ce défi nécessite une recherche interdisciplinaire impliquant non seulement les mathématiques et l'informatique, mais aussi les neurosciences et la psychologie cognitive, ainsi que des recherches en électronique et en physique pour développer les unités de traitement neuronal (NPU) en cours de conception. Nous avons l'opportunité de dépasser enfin les limites des machines de Turing-Von Neumann qui ont dominé l'électronique et les technologies de l'information depuis la Seconde Guerre mondiale.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.