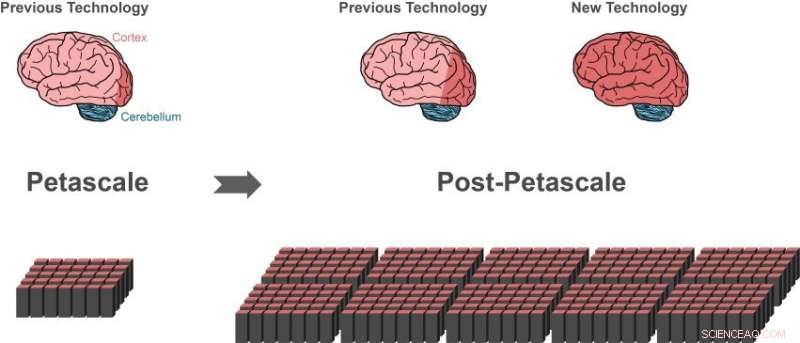

La technologie de simulation précédente peut représenter environ 1% des cellules nerveuses (neurones) dans un cerveau humain (zone rouge foncé du cerveau à gauche) à l'aide d'un superordinateur pétascale (en bas à gauche). Seuls de petits progrès (zone rouge foncé du centre du cerveau) seraient possibles sur la prochaine génération de supercalculateurs qui dépasseront de 10 à 100 fois les performances des supercalculateurs haut de gamme actuels. De plus grandes parties du cerveau humain peuvent être représentées avec la nouvelle technologie, en utilisant la même quantité de mémoire informatique (en bas à droite).i 10 % du cerveau ont approximativement la taille de l'ensemble du cortex (zone rouge foncé du cerveau à droite), ce qui est essentiel pour un traitement plus élevé. Une grande partie des autres neurones se trouvent dans le cervelet (bleu). Crédit :Forschungszentrum Jülich

Un groupe international de chercheurs a fait un pas décisif vers la création de la technologie permettant de réaliser des simulations de réseaux à l'échelle du cerveau sur les futurs supercalculateurs de la classe exascale. La découverte, Publié dans Frontières en neuroinformatique , permet de représenter de plus grandes parties du cerveau humain, utilisant la même quantité de mémoire d'ordinateur. Simultanément, le nouvel algorithme accélère considérablement les simulations cérébrales sur les superordinateurs existants.

Le cerveau humain est un organe d'une complexité incroyable, composé de 100 milliards de cellules nerveuses interconnectées. Cependant, même avec l'aide des supercalculateurs les plus puissants disponibles, il est actuellement impossible de simuler l'échange de signaux neuronaux dans des réseaux de cette taille.

"Depuis 2014, notre logiciel peut simuler environ un pour cent des neurones du cerveau humain avec toutes leurs connexions, " dit Markus Diesmann, Directeur à l'Institut de Neurosciences et de Médecine de Jülich (INM-6). Pour réaliser cet exploit impressionnant, le logiciel nécessite toute la mémoire principale des supercalculateurs pétaflopiques, comme l'ordinateur K à Kobe et JUQUEEN à Jülich.

Diesmann travaille depuis plus de 20 ans sur le logiciel de simulation NEST, un logiciel gratuit, code de simulation open source largement utilisé par la communauté neuroscientifique et un simulateur de base du projet européen du cerveau humain, dans lequel il dirige des projets dans les domaines des neurosciences théoriques et sur la plate-forme d'analyse et de calcul haute performance.

Avec NEST, le comportement de chaque neurone du réseau est représenté par une poignée d'équations mathématiques. Futurs ordinateurs exascale, comme l'ordinateur post-K prévu à Kobe et JUWELS à Jülich, dépassera de 10 à 100 fois les performances des supercalculateurs haut de gamme actuels. Pour la première fois, les chercheurs disposeront de la puissance informatique nécessaire pour simuler des réseaux neuronaux à l'échelle du cerveau humain.

Apparemment une impasse

Alors que la technologie de simulation actuelle a permis aux chercheurs de commencer à étudier de grands réseaux neuronaux, cela représentait également une impasse sur la voie de la technologie exascale. Les supercalculateurs sont composés d'environ 100, 000 petits ordinateurs, appelés nœuds, chacun équipé d'un certain nombre de processeurs effectuant les calculs réels.

"Avant qu'une simulation de réseau neuronal puisse avoir lieu, les neurones et leurs connexions doivent être créés virtuellement, ce qui signifie qu'ils doivent être instanciés dans la mémoire des nœuds. Lors de la simulation un neurone ne sait pas sur lequel des nœuds il a des neurones cibles, donc, ses courtes impulsions électriques doivent être envoyées à tous les nœuds. Chaque nœud vérifie ensuite lesquelles de toutes ces impulsions électriques sont pertinentes pour les neurones virtuels qui existent sur ce nœud, " explique Susanne Kunkel du KTH Royal Institute of Technology à Stockholm.

L'algorithme actuel de création de réseau est efficace car tous les nœuds construisent leur partie particulière du réseau en même temps. Cependant, l'envoi de toutes les impulsions électriques à tous les nœuds n'est pas adapté aux simulations sur des systèmes exascale.

"Vérifier efficacement la pertinence de chaque impulsion électrique nécessite un bit d'information par processeur pour chaque neurone de l'ensemble du réseau. Pour un réseau de 1 milliard de neurones, une grande partie de la mémoire dans chaque nœud est consommée par ce seul bit d'information par neurone, " ajoute Markus Diesmann.

C'est le principal problème lors de la simulation de réseaux encore plus grands :la quantité de mémoire informatique requise par processeur pour les bits supplémentaires par neurone augmente avec la taille du réseau neuronal. A l'échelle du cerveau humain, cela nécessiterait que la mémoire disponible pour chaque processeur soit 100 fois plus grande que dans les supercalculateurs d'aujourd'hui. Cette, cependant, est peu probable que ce soit le cas dans la prochaine génération de supercalculateurs. Le nombre de processeurs par nœud de calcul augmentera mais la mémoire par processeur et le nombre de nœuds de calcul resteront plutôt les mêmes.

Percée par un nouvel algorithme

La percée publiée dans Frontières en neuroinformatique est une nouvelle façon de construire le réseau neuronal dans le supercalculateur. En raison des algorithmes, la mémoire requise sur chaque nœud n'augmente plus avec la taille du réseau. Au début de la simulation, la nouvelle technologie permet aux nœuds d'échanger des informations sur qui doit envoyer des données d'activité neuronale à qui. Une fois ces connaissances disponibles, l'échange de données d'activité neuronale entre les nœuds peut être organisé de telle sorte qu'un nœud ne reçoive que les informations dont il a besoin. Un Bit supplémentaire pour chaque neurone du réseau n'est plus nécessaire.

Un effet secondaire bénéfique

En testant leurs nouvelles idées, les scientifiques ont fait une idée clé supplémentaire, rapporte Susanne Kunkel :« En analysant les nouveaux algorithmes, nous avons réalisé que notre nouvelle technologie permettrait non seulement des simulations sur des systèmes exascale, mais cela rendrait également les simulations plus rapides sur les supercalculateurs actuellement disponibles."

En réalité, la consommation mémoire étant désormais sous contrôle, la vitesse des simulations devient le principal objectif des développements technologiques ultérieurs. Par exemple, une grande simulation de 0,52 milliard de neurones connectés par 5,8 billions de synapses fonctionnant sur le superordinateur JUQUEEN à Jülich nécessitait auparavant 28,5 minutes pour calculer une seconde de temps biologique. Avec la simulation améliorée des structures de données, le temps est réduit à 5,2 minutes.

"Avec la nouvelle technologie, nous pouvons exploiter le parallélisme accru des microprocesseurs modernes beaucoup mieux qu'auparavant, qui deviendra encore plus important dans les ordinateurs exascale, " remarque Jakob Jordan, auteur principal de l'étude, du Forschungszentrum Jülich.

"La combinaison de matériel exascale et de logiciels appropriés apporte des investigations sur les aspects fondamentaux de la fonction cérébrale, comme la plasticité et l'apprentissage se déroulant sur des minutes de temps biologique à notre portée, " ajoute Markus Diesmann.

Avec l'une des prochaines versions du logiciel de simulation NEST, les chercheurs mettront gratuitement leurs réalisations à la disposition de la communauté en open source.

"Nous avons utilisé NEST pour simuler la dynamique complexe des circuits des noyaux gris centraux dans la santé et la maladie de Parkinson sur l'ordinateur K. Nous sommes ravis d'entendre les nouvelles sur la nouvelle génération de NEST, qui nous permettra d'exécuter des simulations à l'échelle du cerveau sur l'ordinateur post-K pour clarifier les mécanismes neuronaux du contrôle moteur et des fonctions mentales, " déclare Kenji Doya de l'Institut des sciences et technologies d'Okinawa (OIST).

"L'étude est un merveilleux exemple de la collaboration internationale dans l'effort pour construire des ordinateurs exascale. Il est important que nous ayons des applications prêtes qui peuvent utiliser ces précieuses machines dès le premier jour où elles sont disponibles, " conclut Mitsuhisa Sato du RIKEN Advanced Institute for Computer Science de Kobe.